Masked Image Modeling: 深度学习中的新范式

近年来,Masked Image Modeling (MIM)作为一种新兴的自监督学习范式在计算机视觉领域引起了广泛关注。本文将全面介绍MIM的基本原理、发展历程、主要方法以及在各个领域的应用,为读者提供一个系统的MIM技术综述。

MIM的基本原理与发展历程

Masked Image Modeling的核心思想是通过预测被遮挡的图像区域来学习视觉表征。这一思路最早源于自然语言处理中的掩码语言模型(Masked Language Model, MLM),如BERT等。2020年,OpenAI的研究人员提出了iGPT,首次将类似的掩码预测思想应用到图像领域。随后,Google的Vision Transformer (ViT)进一步验证了Transformer架构在视觉任务中的有效性。

2021年底,微软的BEiT和Facebook的MAE几乎同时提出,标志着MIM范式正式进入计算机视觉主流。BEiT采用离散的视觉词元(visual token)作为预测目标,而MAE直接预测像素值,两者分别代表了MIM的两个主要技术路线。此后,各种改进和变体方法不断涌现,MIM迅速成为自监督视觉表征学习的主导范式之一。

MIM的主要方法

MIM的基本框架包括四个核心组件:掩码(Masking)、编码器(Encoder)、目标(Target)和预测头(Head)。不同的MIM方法主要在这四个方面进行创新和改进。

-

掩码策略:最常用的是随机掩码,也有一些工作探索了基于语义或结构的掩码方法。

-

编码器架构:以Transformer为主,也有一些工作尝试结合CNN等其他架构。

-

预测目标:可分为像素级(如MAE)和特征级(如BEiT)两类。

-

预测头设计:通常采用简单的线性层或小型解码器。

下面介绍几个具有代表性的MIM方法:

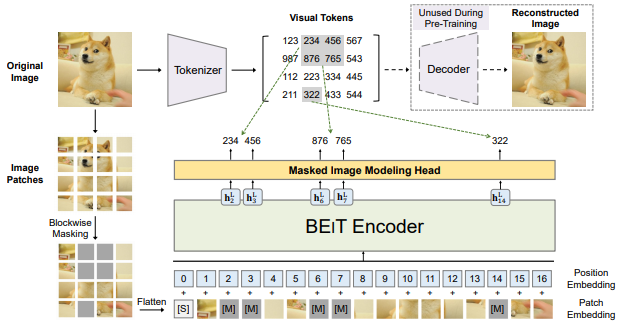

BEiT

BEiT (BERT Pre-Training of Image Transformers)是最早将BERT的掩码语言模型思想迁移到视觉领域的工作之一。它首先使用dVAE学习离散的视觉词元,然后将图像patch随机掩码,训练模型预测被掩码patch对应的视觉词元。

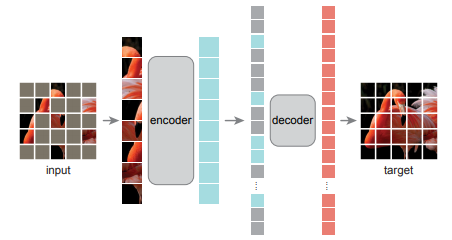

MAE

MAE (Masked Autoencoders Are Scalable Vision Learners)采用了一种非对称的编码器-解码器架构。它使用很高的掩码比例(如75%)随机掩码输入图像,仅用未被掩码的patch训练一个重型编码器,然后用一个轻量级解码器重建整张图像的像素值。这种设计大大提高了训练效率。

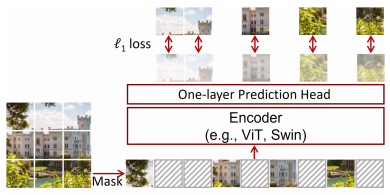

SimMIM

SimMIM (A Simple Framework for Masked Image Modeling)提出了一种简单而有效的MIM框架。它直接使用原始图像作为重建目标,采用对称的编码器-解码器结构,并引入了归一化像素值作为回归目标。这种设计在多个下游任务上取得了优秀的表现。

MIM在计算机视觉中的应用

MIM预训练的模型在多个计算机视觉任务中展现出了强大的性能:

-

图像分类: MIM预训练的模型在ImageNet等分类基准上取得了与有监督预训练相当甚至更好的结果。

-

目标检测: 多项研究表明,MIM预训练可以为COCO等目标检测任务提供优秀的特征表征。

-

语义分割: MIM预训练同样在ADE20K等语义分割数据集上展现出色的迁移学习能力。

-

视频理解: 一些工作将MIM扩展到视频领域,如VideoMAE等,在动作识别等任务上取得了不错的效果。

-

多模态学习: MIM也被应用于图像-文本等多模态预训练中,如BLIP等工作。

MIM的优势与局限性

MIM作为一种新兴的自监督学习范式,具有以下几个主要优势:

-

无需标注数据: MIM可以直接利用大量未标注的图像数据进行预训练,大大降低了数据获取成本。

-

学习通用表征: MIM学习到的特征表征具有很强的泛化能力,可以迁移到多种下游任务。

-

可扩展性强: MIM方法通常可以轻松扩展到更大的模型和数据规模。

-

与其他方法互补: MIM可以与对比学习等其他自监督学习方法结合,进一步提升性能。

然而,MIM也存在一些局限性:

-

计算开销大: 相比传统的监督学习,MIM通常需要更长的训练时间和更多的计算资源。

-

下游任务适应: MIM预训练的模型在某些特定任务上可能需要更多的微调才能达到最佳性能。

-

理论基础有待加强: 目前对MIM为何有效还缺乏深入的理论解释。

MIM的未来发展方向

尽管MIM已经取得了巨大成功,但仍有许多值得探索的方向:

-

更高效的训练策略: 如何进一步提高MIM的训练效率是一个重要问题。

-

与其他范式的融合: 将MIM与对比学习、知识蒸馏等方法有机结合可能带来更好的性能。

-

跨模态扩展: 探索MIM在视频、3D点云等其他模态数据上的应用。

-

解释性研究: 深入理解MIM的工作机制,为其设计和应用提供理论指导。

-

领域特定优化: 针对医疗影像、遥感等特定领域优化MIM方法。

结语

Masked Image Modeling作为一种新兴的自监督学习范式,在短短几年内就展现出了巨大的潜力。它不仅在多个计算机视觉任务中取得了卓越的性能,还为视觉表征学习提供了新的思路。随着研究的不断深入,MIM有望在更广泛的领域发挥重要作用,推动人工智能技术的进步。

作为一个活跃的研究方向,MIM仍在快速发展中。感兴趣的读者可以关注Awesome-MIM等项目,及时了解该领域的最新进展。相信在不久的将来,MIM会为计算机视觉乃至整个人工智能领域带来更多令人兴奋的突破。