MocapNET:让3D动作捕捉变得简单快捷

MocapNET是一项革命性的技术,它可以从单个RGB摄像头拍摄的2D图像直接估计出3D人体姿态,并输出广泛使用的BVH格式文件。这项由希腊FORTH研究所开发的技术,正在为计算机视觉和动画领域带来巨大变革。

核心创新

MocapNET的主要创新包括:

- 紧凑的2D姿态NSRM表示方法

- 人体方向分类器和方向调整的神经网络集成

- 高效的逆运动学求解器

这些创新使得MocapNET在Human 3.6M数据集上比基线方法提高了33%的准确率,同时保持了实时性能(CPU执行可达70fps)。

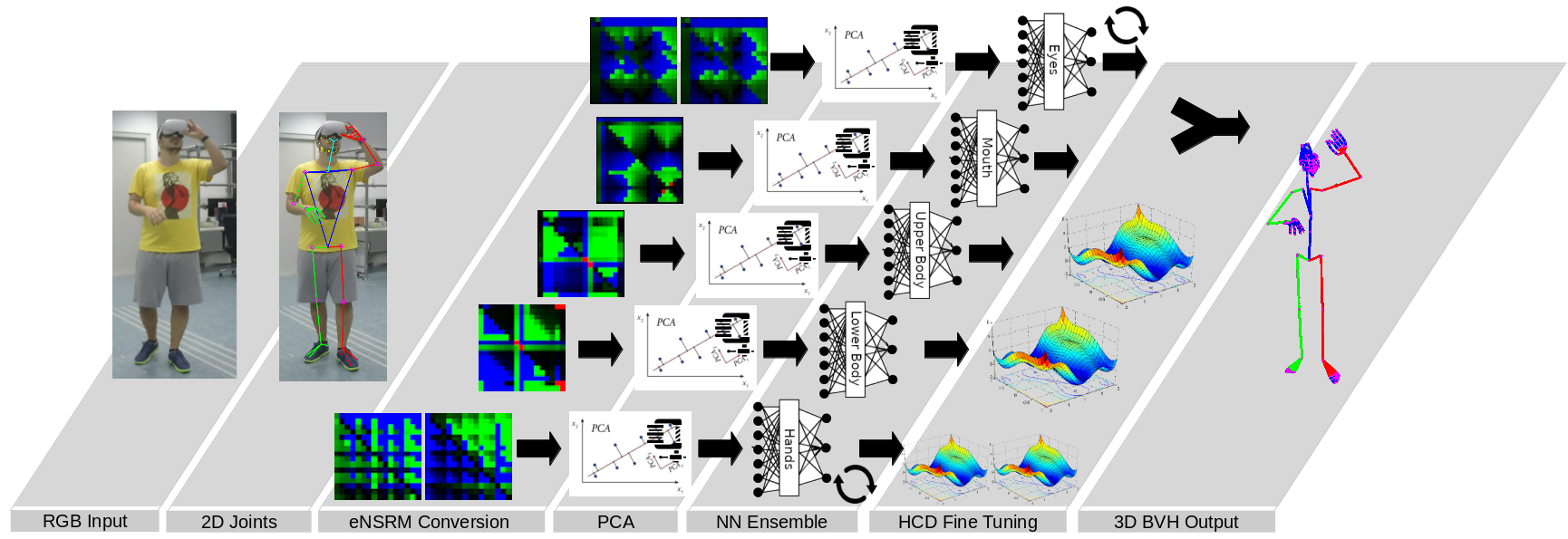

工作原理

MocapNET的工作流程如下:

- 从RGB图像中提取2D人体关节点位置

- 使用NSRM方法将2D关节点编码为紧凑表示

- 通过人体方向分类器确定大致朝向

- 使用神经网络集成估计初步3D姿态

- 应用逆运动学求解器细化3D姿态

整个过程在普通CPU上就可以实时运行,无需昂贵的GPU。

广泛应用前景

MocapNET可以应用于多个领域:

- 电影/游戏动画制作

- 虚拟现实/增强现实

- 人机交互

- 医疗康复

- 体育训练分析

- 安防监控等

它大大降低了3D动作捕捉的门槛,让普通用户也能轻松获得专业级动画效果。

开源共享

MocapNET采用开源方式发布,源代码和预训练模型都可以在GitHub上免费获取。研究人员还提供了详细的使用说明和演示视频,方便用户快速上手。

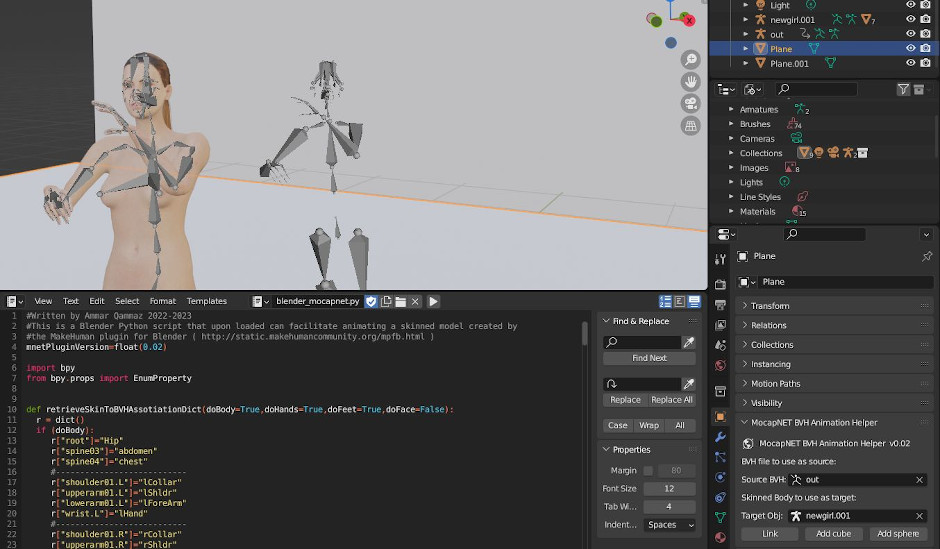

此外,MocapNET还支持与Blender等3D软件集成,可以直接生成可编辑的3D动画。

持续发展

MocapNET项目一直在不断改进和发展:

- 2019年发布MocapNET v1

- 2020年发布MocapNET v2,大幅提升准确率

- 2021年发布MocapNET v3,增加手部姿态估计

- 2023年发布MocapNET v4,支持面部表情和眼球运动

最新的v4版本已经可以捕捉包括面部和手部在内的全身动作,为虚拟人物注入更多生动细节。

如何使用

MocapNET的使用非常简单:

- 从GitHub克隆项目代码

- 运行初始化脚本安装依赖

- 编译项目

- 运行演示程序,输入视频或摄像头画面

- 获得BVH格式的3D动画文件

对于想要更高精度的用户,还可以使用OpenPose等工具预处理2D关节点数据。

# 克隆项目

git clone https://github.com/FORTH-ModelBasedTracker/MocapNET

# 安装依赖

cd MocapNET

./initialize.sh

# 编译

cd build

cmake ..

make

# 运行演示

./MocapNET2LiveWebcamDemo --from /dev/video0 --live

未来展望

MocapNET团队正在进行更多改进:

- 提高多人场景下的表现

- 支持更多种类的动作

- 改善遮挡情况下的稳定性

- 与更多3D软件集成

随着技术的不断进步,未来MocapNET有望成为3D动画制作的标准工具,让高质量的动作捕捉变得唾手可得。

总之,MocapNET为3D人体姿态估计带来了革命性的进展。它简单易用yet功能强大,必将在计算机视觉、计算机图形学等多个领域产生深远影响。对于研究人员和开发者来说,这无疑是一个值得关注和尝试的开源项目。