多模态强化学习研究综述:从图像到语言的智能代理学习

近年来,随着深度学习和强化学习的快速发展,多模态强化学习(Multi-Modal Reinforcement Learning, MMRL)已成为人工智能领域的一个重要研究方向。MMRL旨在让智能代理能够从图像、文本等多种模态数据中学习,以实现更加灵活和通用的决策能力。本文将全面综述MMRL的研究现状、关键技术及未来趋势。

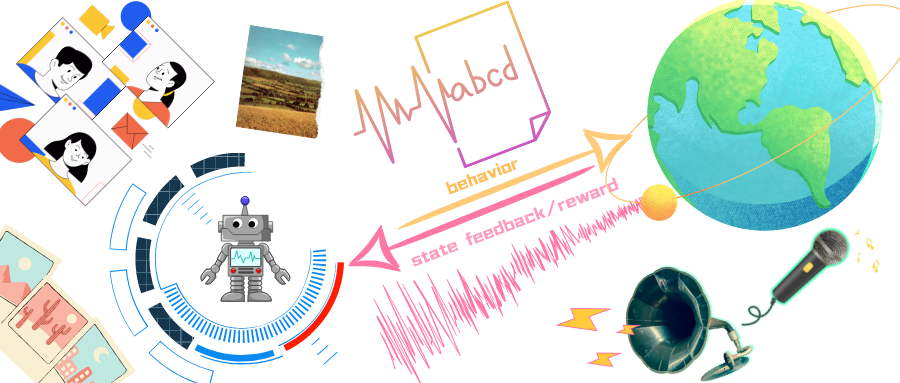

1. 多模态强化学习概述

MMRL的核心思想是让智能代理能够像人类一样,直接从视频(图像)、语言(文本)或两者的组合中学习。这种学习方式具有重要意义,因为互联网上存在大量的图像和文本数据,可以被智能代理直接利用。

如上图所示,MMRL代理可以从多种模态输入中学习,包括视觉、语言等,从而实现更加灵活的决策。

2. 视觉强化学习

视觉强化学习是MMRL的重要分支之一,主要研究如何从图像或视频中学习决策策略。近年来,该领域取得了一系列重要进展:

-

DrM(Dormant Ratio Minimization)方法通过最小化休眠比来提高视觉强化学习的效率。该方法在DeepMind Control Suite等多个benchmark上取得了state-of-the-art的性能。

-

数据增强技术被证明可以显著提升视觉强化学习的性能。一些研究对比了不同数据增强策略的效果,为实际应用提供了指导。

-

可塑性(Plasticity)研究表明,合理设计网络结构和训练策略可以提高视觉RL的泛化能力和样本效率。

-

基于实体的RL方法可以实现从像素级输入到对象操纵的端到端学习,具有很好的组合泛化能力。

这些进展大大提高了视觉RL的性能和适用性,为实现更加灵活的视觉智能代理奠定了基础。

3. 语言引导的强化学习

将语言能力引入RL系统是MMRL的另一个重要方向。近期的一些代表性工作包括:

-

PaLI模型通过联合训练实现了多语言-图像模型的zero-shot能力,展示了语言模型在视觉任务中的潜力。

-

VIMA框架提出了基于多模态提示的通用机器人操作方法,可以处理各种复杂任务。

-

MIND'S EYE系统通过模拟实现了语言模型到物理世界的推理,提高了语言模型的物理常识。

-

一些研究探索了如何将大型语言模型用于机器人导航等embodied AI任务。

这些工作表明,语言模型可以为RL系统提供强大的先验知识和推理能力,是实现通用人工智能的重要途径之一。

4. 多模态融合

如何有效融合视觉、语言等多种模态信息是MMRL面临的关键挑战。一些代表性的融合方法包括:

-

CLIP等对比学习方法可以学习图像和文本的联合表示,为多模态任务提供了强大的预训练模型。

-

基于Transformer的多模态注意力机制被广泛应用于视觉语言导航等任务中。

-

世界模型(World Model)方法通过学习环境动力学的隐变量表示,实现了多模态信息的融合。

-

一些研究提出了分离表示学习和强化学习的方法,以提高多模态RL的效率。

这些融合技术极大地提升了MMRL系统处理复杂环境的能力,是未来研究的重要方向。

5. 应用与挑战

MMRL已在机器人操作、自动驾驶、游戏AI等多个领域展现出巨大潜力。一些典型应用包括:

-

基于互联网规模知识的开放式embodied agents(如MineDojo项目)。

-

从未标注视频中学习行为的VPT方法。

-

用于视觉语言导航的场景感知Transformer模型。

-

用于机器人操作的通用视觉表示R3M。

尽管取得了这些进展,MMRL仍面临诸多挑战,如样本效率、泛化能力、鲁棒性等。未来的研究方向包括:

-

设计更高效的多模态表示学习方法。

-

提高MMRL系统的可解释性和安全性。

-

探索大规模预训练与强化学习的结合。

-

研究多模态、多任务、终身学习的统一框架。

6. 总结与展望

多模态强化学习作为一个新兴的研究方向,正在快速发展并展现出巨大潜力。通过融合视觉、语言等多种模态信息,MMRL有望实现更加灵活和通用的人工智能系统。未来,随着大规模预训练模型、自监督学习等新技术的应用,MMRL将在更多领域发挥重要作用,推动人工智能向着通用智能的目标不断前进。

本文对MMRL的研究现状进行了全面综述,希望能为相关研究者提供参考。随着技术的不断进步,我们期待看到更多激动人心的MMRL应用出现,为人类社会带来福祉。

参考文献

[1] Xu G, et al. DrM: Mastering Visual Reinforcement Learning through Dormant Ratio Minimization. ICLR 2024.

[2] Hu J, et al. Revisiting Data Augmentation in Deep Reinforcement Learning. ICLR 2024.

[3] Chen X, et al. PaLI: A Jointly-Scaled Multilingual Language-Image Model. ICLR 2023.

[4] Jiang Y, et al. VIMA: General Robot Manipulation with Multimodal Prompts. NeurIPS Workshop 2022.

[5] Fan L, et al. MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. NeurIPS 2022.

[6] Baker B, et al. Video PreTraining (VPT): Learning to Act by Watching Unlabeled Online Videos. NeurIPS 2022.

[7] Nair S, et al. R3M: A Universal Visual Representation for Robot Manipulation. CoRL 2022.