OOTDiffusion:让虚拟试衣更加真实和可控

在当今数字化时代,虚拟试衣技术正在彻底改变人们的购物体验。然而,如何生成高质量、逼真的试衣效果一直是这一领域的重大挑战。近日,来自小i机器人研究院的研究团队提出了一种名为OOTDiffusion的创新方法,为虚拟试衣带来了新的突破。

什么是OOTDiffusion?

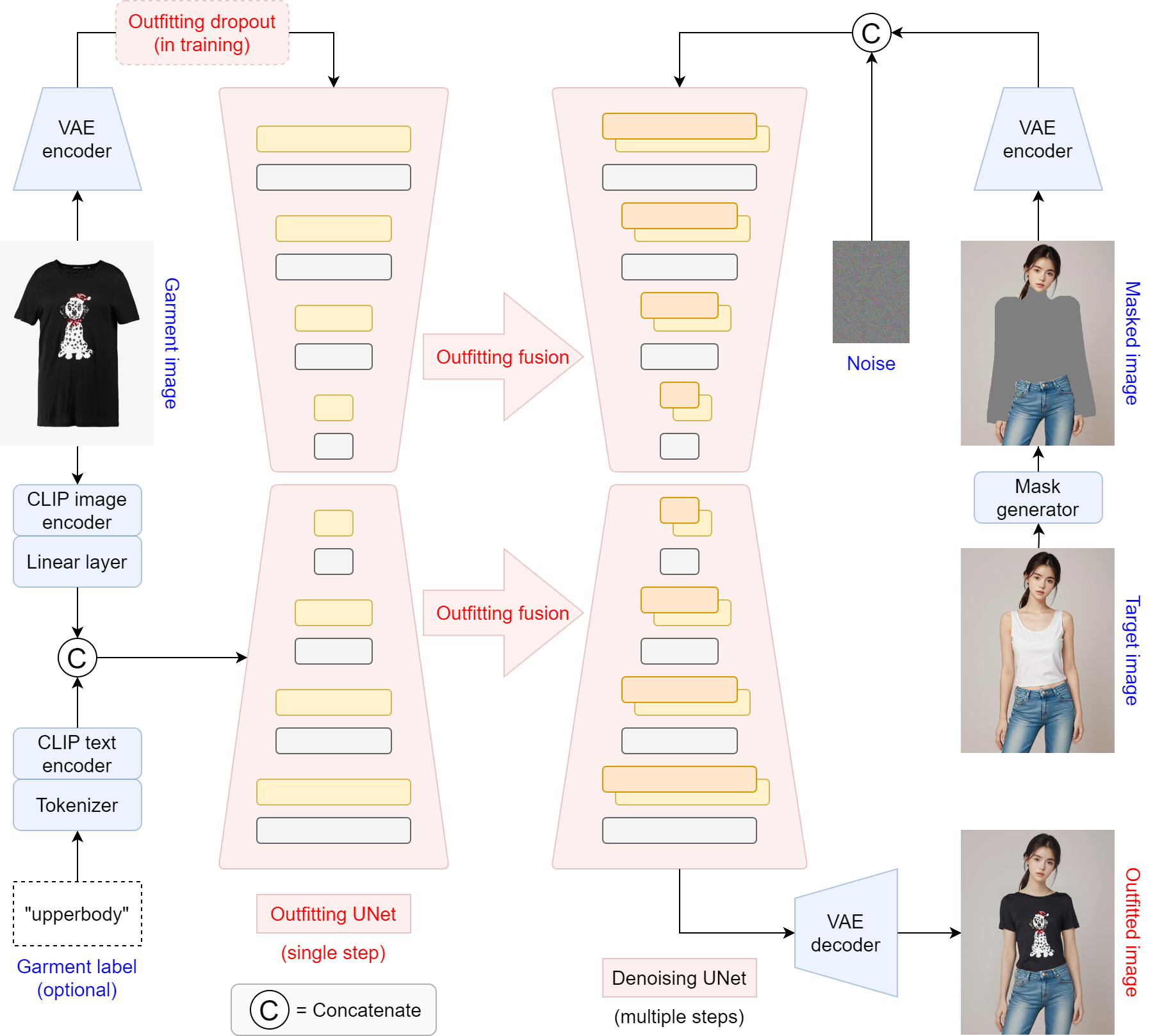

OOTDiffusion是一种基于潜在扩散模型的可控虚拟试衣系统。它利用预训练的潜在扩散模型的强大功能,设计了一个专门的outfitting UNet来学习服装细节特征。与传统方法不同,OOTDiffusion无需冗余的变形过程,而是通过在去噪UNet的自注意力层中提出的outfitting fusion方法,将服装特征精确对齐到目标人体上。

OOTDiffusion的创新之处

-

Outfitting UNet: 专门设计用于学习服装细节特征,确保生成的试衣效果更加精细逼真。

-

Outfitting Fusion: 在自注意力层中实现服装特征与人体的精确对齐,无需额外的变形步骤。

-

Outfitting Dropout: 在训练过程中引入,使得可以通过无分类器引导来调整服装特征的强度,增强了系统的可控性。

-

高质量生成: 在VITON-HD和Dress Code数据集上的实验表明,OOTDiffusion能够高效生成任意人物和服装图像的高质量试衣结果。

OOTDiffusion的应用前景

OOTDiffusion的出现为虚拟试衣技术带来了新的可能性:

-

电商平台: 为消费者提供更真实、互动的在线购物体验,提高购买转化率。

-

个性化定制: 帮助设计师和客户更直观地预览定制服装效果。

-

虚拟时装秀: 为时尚品牌提供创新的线上展示方式,节省成本的同时扩大受众群体。

-

AR/VR应用: 与增强现实和虚拟现实技术结合,创造沉浸式的试衣体验。

如何使用OOTDiffusion?

研究团队已经开源了OOTDiffusion的代码和预训练模型,使得开发者和研究者可以轻松上手这一技术。以下是使用OOTDiffusion的简要步骤:

- 克隆项目仓库:

git clone https://github.com/levihsu/OOTDiffusion

- 创建conda环境并安装依赖:

conda create -n ootd python==3.10

conda activate ootd

pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2

pip install -r requirements.txt

-

下载预训练模型: 从Hugging Face下载ootd、humanparsing和openpose模型,并放置在

checkpoints文件夹中。 -

运行推理:

cd OOTDiffusion/run

python run_ootd.py --model_path <模特图片路径> --cloth_path <衣服图片路径> --scale 2.0 --sample 4

OOTDiffusion的未来发展

尽管OOTDiffusion已经展现出了令人印象深刻的性能,但研究团队表示还有进一步提升的空间:

-

多视角生成: 目前OOTDiffusion主要处理正面视角的试衣效果,未来可能会扩展到多角度生成。

-

动态效果: 实现动态的试衣效果,如行走、转身等动作下的服装展示。

-

更细粒度的控制: 允许用户调整更多细节,如服装颜色、材质等。

-

跨模态整合: 结合文本描述或语音指令来控制试衣过程。

结语

OOTDiffusion的出现无疑为虚拟试衣技术注入了新的活力。它不仅提高了生成图像的质量和真实感,还通过创新的设计提供了更高的可控性。随着这一技术的不断发展和完善,我们可以期待在不久的将来,虚拟试衣将成为一种更加普及和成熟的应用,为时尚产业和消费者带来前所未有的便利和体验。

对于有兴趣深入了解或使用OOTDiffusion的读者,可以访问项目的GitHub仓库获取更多信息。同时,研究团队也欢迎社区的贡献,共同推动这一激动人心的技术向前发展。

让我们一起期待OOTDiffusion为虚拟试衣领域带来的更多可能性!

🔗 相关链接: