OpenAI Whisper简介

OpenAI Whisper是一个由OpenAI开发的开源自动语音识别(ASR)系统,于2022年发布。它通过大规模弱监督学习,在多语言语音识别和翻译任务上取得了突破性的进展。Whisper模型经过了680,000小时多语言和多任务监督数据的训练,展现出强大的泛化能力和鲁棒性。

Whisper的技术特点

-

多语言支持: Whisper支持99种语言的语音识别,并可以将这些语言翻译成英语。

-

强大的泛化能力: 即使在未见过的口音、背景噪音和技术语言上也能表现出色。

-

零样本学习: 无需针对特定数据集进行微调,就能在多个公开基准上实现竞争性的结果。

-

多任务能力: 同时支持语音识别、语音翻译、语言识别和语音活动检测等任务。

-

开源性: Whisper的代码和预训练模型都是开源的,方便研究者和开发者使用和改进。

Whisper模型版本

Whisper提供了多个不同规模的预训练模型,以适应不同的应用场景和计算资源限制:

| 模型大小 | 参数数量 | 仅英语版本 | 多语言版本 |

|---|---|---|---|

| tiny | 39 M | ✓ | ✓ |

| base | 74 M | ✓ | ✓ |

| small | 244 M | ✓ | ✓ |

| medium | 769 M | ✓ | ✓ |

| large | 1550 M | x | ✓ |

| large-v2 | 1550 M | x | ✓ |

| large-v3 | 1550 M | x | ✓ |

最新的large-v3模型在超过100万小时的弱标注音频和400万小时的伪标注音频上进行了训练,相比large-v2模型,在各种语言上的错误率降低了10%到20%。

Whisper的应用场景

-

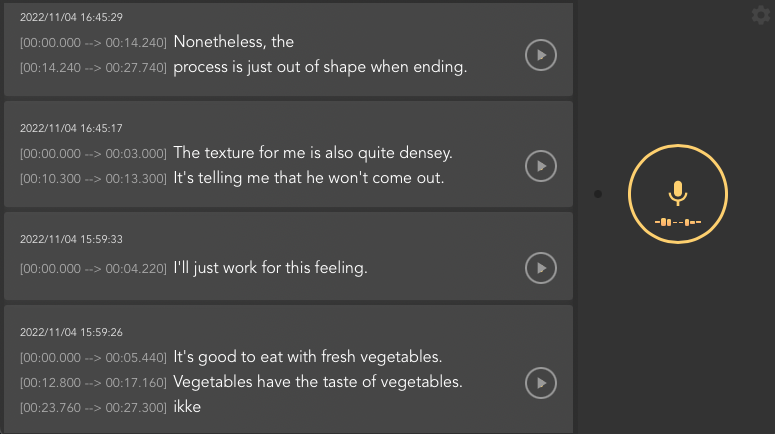

自动字幕生成: 为视频、播客等内容生成精确的多语言字幕。

-

实时语音翻译: 在国际会议或跨语言交流中提供实时翻译服务。

-

语音助手: 提升智能语音助手的识别准确度和多语言能力。

-

语音数据分析: 对大规模语音数据进行转录和分析,用于市场研究、客户服务改进等。

-

无障碍技术: 为听障人士提供更准确的语音转文字服务。

-

语言学习工具: 帮助学习者提高发音和听力理解能力。

在Hugging Face上使用Whisper

Whisper模型可以通过Hugging Face Transformers库轻松使用。以下是一个使用Whisper large-v3模型进行语音识别的Python代码示例:

import torch

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor, pipeline

from datasets import load_dataset

device = "cuda:0" if torch.cuda.is_available() else "cpu"

torch_dtype = torch.float16 if torch.cuda.is_available() else torch.float32

model_id = "openai/whisper-large-v3"

model = AutoModelForSpeechSeq2Seq.from_pretrained(

model_id, torch_dtype=torch_dtype, low_cpu_mem_usage=True, use_safetensors=True

)

model.to(device)

processor = AutoProcessor.from_pretrained(model_id)

pipe = pipeline(

"automatic-speech-recognition",

model=model,

tokenizer=processor.tokenizer,

feature_extractor=processor.feature_extractor,

torch_dtype=torch_dtype,

device=device,

)

dataset = load_dataset("distil-whisper/librispeech_long", "clean", split="validation")

sample = dataset[0]["audio"]

result = pipe(sample)

print(result["text"])

这段代码展示了如何加载Whisper large-v3模型,并使用它来转录音频文件。Hugging Face的生态系统使得使用和部署Whisper模型变得非常简单。

Whisper的性能优化

为了提高Whisper模型的推理速度和内存效率,可以采用以下优化策略:

-

分块处理长音频: 对于长音频文件,可以使用分块算法进行处理,提高处理速度。

-

使用torch.compile: 通过PyTorch的即时编译功能,可以显著提升模型的推理速度。

-

Flash Attention 2: 对支持的GPU,使用Flash Attention 2可以大幅提高注意力机制的计算效率。

-

Torch SDPA: 对于不支持Flash Attention的GPU,可以使用PyTorch的缩放点积注意力(SDPA)机制来优化性能。

这些优化技术可以根据具体的硬件环境和应用需求灵活选用,以获得最佳的性能表现。

Whisper的局限性和未来发展

尽管Whisper在多个方面表现出色,但它仍然存在一些局限性:

-

实时处理能力有限: Whisper并非设计用于实时流式处理任务,这限制了它在某些实时应用场景中的使用。

-

计算资源需求: 大型Whisper模型需要较高的计算资源,这可能限制其在资源受限的环境中的应用。

-

幻听现象: 在某些情况下,模型可能会生成实际音频中不存在的内容,这被称为"幻听"。

-

语言不平衡: 对于低资源语言或方言,模型的性能可能不如主流语言。

未来,Whisper的发展可能会聚焦于以下几个方向:

- 提高实时处理能力

- 减少计算资源需求

- 改善对低资源语言的支持

- 进一步提高识别准确度和鲁棒性

结论

OpenAI Whisper代表了语音识别技术的一个重要里程碑。它的多语言能力、强大的泛化性和开源特性为众多应用场景提供了新的可能性。随着技术的不断进步和社区的持续贡献,我们可以期待Whisper在未来为更多领域带来革命性的变革。

无论是研究人员、开发者还是企业用户,都可以利用Whisper来探索语音技术的新前沿,创造出更智能、更自然的人机交互体验。随着语音识别技术的不断发展,我们离实现真正的"万物互联"又近了一步。

参考资料

- OpenAI Whisper GitHub仓库

- Hugging Face Whisper模型页面

- Robust Speech Recognition via Large-Scale Weak Supervision

通过深入了解和应用Whisper技术,我们可以期待在语音识别、多语言交流和人工智能领域迎来更多激动人心的创新和突破。Whisper的开源特性为整个技术社区提供了宝贵的资源,让我们共同期待语音技术的美好未来。