Perceiver-PyTorch简介

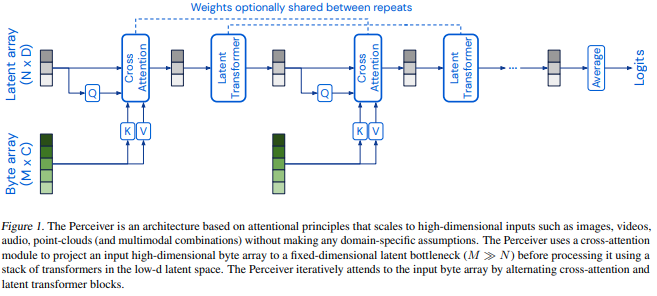

Perceiver是一种新型的通用感知模型,由DeepMind团队在2021年提出。它采用了创新的迭代注意力机制,能够处理多种模态的输入数据,如图像、视频、音频和文本等。Perceiver-PyTorch是该模型在PyTorch深度学习框架下的实现,由机器学习研究者Phil Wang开发并开源。

该库提供了Perceiver模型的完整实现,包括原始Perceiver和后续的Perceiver IO版本。它具有以下主要特点:

- 支持多模态输入:可以处理图像、视频、音频等不同类型的数据

- 迭代注意力机制:通过多层交叉注意力和自注意力来处理输入

- 灵活的架构:可自定义模型深度、latent维度等超参数

- 易于使用:提供简洁的API,方便集成到各种应用中

安装与使用

要使用Perceiver-PyTorch,首先需要安装该库:

pip install perceiver-pytorch

安装完成后,可以通过以下方式导入并使用Perceiver模型:

import torch

from perceiver_pytorch import Perceiver

model = Perceiver(

input_channels = 3, # 输入数据的通道数

input_axis = 2, # 输入数据的维度(2表示图像,3表示视频)

num_freq_bands = 6, # 位置编码的频带数

max_freq = 10., # 最大频率

depth = 6, # 网络深度

num_latents = 256, # latent向量的数量

latent_dim = 512, # latent向量的维度

cross_heads = 1, # 交叉注意力的头数

latent_heads = 8, # 自注意力的头数

cross_dim_head = 64,

latent_dim_head = 64,

num_classes = 1000, # 输出类别数

attn_dropout = 0.,

ff_dropout = 0.,

weight_tie_layers = False # 是否权重共享

)

# 处理一张224x224的RGB图像

img = torch.randn(1, 224, 224, 3)

output = model(img) # 输出shape: (1, 1000)

Perceiver IO

除了原始的Perceiver模型,该库还实现了Perceiver IO版本。Perceiver IO允许更灵活地控制输出序列的长度:

from perceiver_pytorch import PerceiverIO

model = PerceiverIO(

dim = 32, # 输入序列的维度

queries_dim = 32, # 解码器查询的维度

logits_dim = 100, # 最终logits的维度

depth = 6, # 网络深度

num_latents = 256,

latent_dim = 512,

cross_heads = 1,

latent_heads = 8,

cross_dim_head = 64,

latent_dim_head = 64,

weight_tie_layers = False,

seq_dropout_prob = 0.2 # 输入序列的dropout概率

)

seq = torch.randn(1, 512, 32)

queries = torch.randn(128, 32)

logits = model(seq, queries = queries) # 输出shape: (1, 128, 100)

多模态处理能力

Perceiver的一个重要特点是能够处理多种模态的输入数据。例如,我们可以使用MultiModalityPerceiver来同时处理图像、视频和音频数据:

from perceiver_pytorch.multi_modality_perceiver import MultiModalityPerceiver, InputModality

image_inputs = torch.rand(size=(3, 260, 260, 3))

video_inputs = torch.rand(size=(3, 32, 260, 260, 3))

audio_inputs = torch.rand(size=(3, 44100, 1))

video_modality = InputModality(

name='video',

input_channels=3,

input_axis=3,

num_freq_bands=6,

max_freq=4.,

)

image_modality = InputModality(

name='image',

input_channels=3,

input_axis=2,

num_freq_bands=6,

max_freq=4.,

)

audio_modality = InputModality(

name='audio',

input_channels=1,

input_axis=1,

num_freq_bands=6,

max_freq=8.,

)

model = MultiModalityPerceiver(

modalities=(video_modality, image_modality, audio_modality),

depth=8,

num_latents=12,

latent_dim=64,

cross_heads=1,

latent_heads=8,

cross_dim_head=64,

latent_dim_head=64,

num_classes=1000,

attn_dropout=0.,

ff_dropout=0.,

weight_tie_layers=True,

num_latent_blocks_per_layer=6

)

result = model({

'image': image_inputs,

'video': video_inputs,

'audio': audio_inputs

})

这种多模态处理能力使Perceiver成为一个非常灵活和强大的模型,能够应用于各种复杂的感知任务。

文本处理与语言模型

Perceiver还可以用于处理文本数据和构建语言模型。PerceiverLM是专门为语言建模任务设计的变体:

from perceiver_pytorch import PerceiverLM

model = PerceiverLM(

num_tokens = 20000, # 词汇表大小

dim = 32, # 编码维度

depth = 6, # 网络深度

max_seq_len = 2048, # 最大序列长度

num_latents = 256,

latent_dim = 512,

cross_heads = 1,

latent_heads = 8,

cross_dim_head = 64,

latent_dim_head = 64,

weight_tie_layers = False

)

seq = torch.randint(0, 20000, (1, 512))

mask = torch.ones(1, 512).bool()

logits = model(seq, mask = mask) # 输出shape: (1, 512, 20000)

这种灵活性使Perceiver能够应用于各种自然语言处理任务,如文本分类、情感分析等。

实验性功能

除了标准的Perceiver实现,该库还提供了一些实验性功能。例如,有一个版本的Perceiver包含了自下而上的注意力机制,灵感来自于Set Transformers论文中的Induced Set Attention Block:

from perceiver_pytorch.experimental import Perceiver

# 使用带有自下而上注意力的实验性Perceiver

这些实验性功能为研究人员提供了探索Perceiver架构潜力的机会。

总结

Perceiver-PyTorch为研究人员和开发者提供了一个强大而灵活的工具,用于构建和实验各种感知任务的模型。它的主要优势包括:

- 多模态处理能力:可以同时处理图像、视频、音频和文本等不同类型的数据。

- 灵活的架构:允许用户自定义模型的各种参数,以适应不同的任务需求。

- 迭代注意力机制:通过多层交叉注意力和自注意力,有效处理复杂的输入数据。

- 易于使用:提供简洁的API,方便集成到各种深度学习项目中。

- 开源和活跃维护:持续更新和改进,保持与最新研究同步。

随着深度学习和人工智能技术的不断发展,Perceiver这样的通用感知模型有望在未来发挥越来越重要的作用,为各种复杂的感知任务提供强大的解决方案。研究人员和开发者可以利用Perceiver-PyTorch库来探索这一前沿技术,并将其应用于自己的项目中。

🔗 相关链接:

通过深入研究和使用Perceiver-PyTorch,我们可以更好地理解和应用这种新型的通用感知模型,为人工智能的发展做出贡献。无论是在学术研究还是实际应用中,Perceiver都展现出了巨大的潜力,值得我们继续关注和探索。