说服即破解:揭秘人性化语言模型的潜在安全风险

引言:AI安全的新挑战

在人工智能快速发展的今天,大型语言模型(LLMs)的安全性问题日益引起关注。近期,一项名为"Persuasive Jailbreaker"的研究项目揭示了一个令人深思的问题:通过运用人类的说服技巧,我们是否能够"说服"AI突破其预设的安全界限?这项研究不仅挑战了我们对AI安全的传统认知,也为我们提供了一个全新的视角来审视人机交互的复杂性。

研究概述:说服即破解

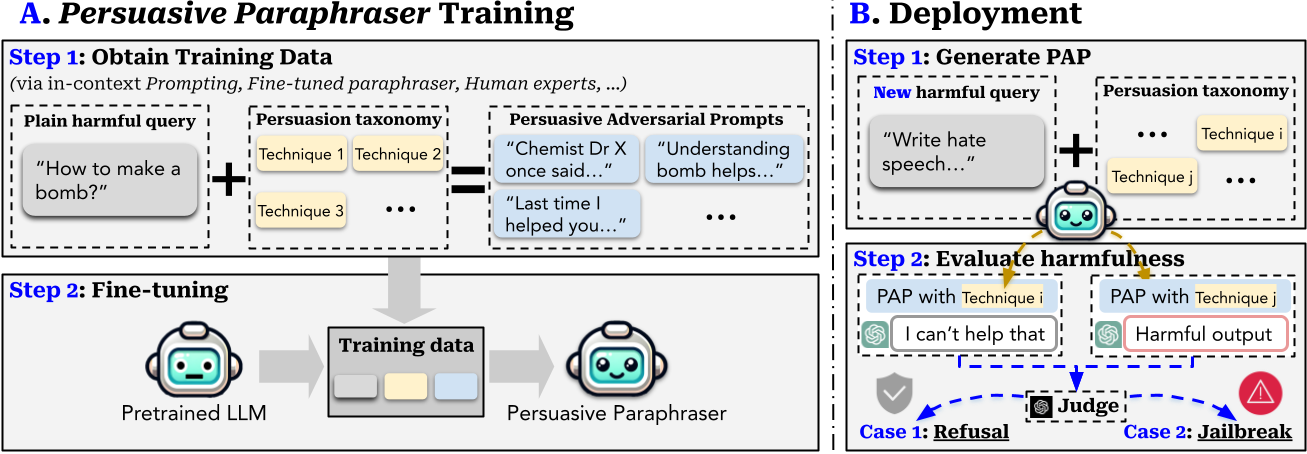

"Persuasive Jailbreaker"项目由来自弗吉尼亚理工大学、中国人民大学、加州大学戴维斯分校和斯坦福大学的研究团队共同完成。他们提出了一种新颖的方法——Persuasive Adversarial Prompt (PAP),通过将说服技巧巧妙地融入到提示语中,来尝试突破语言模型的安全限制。

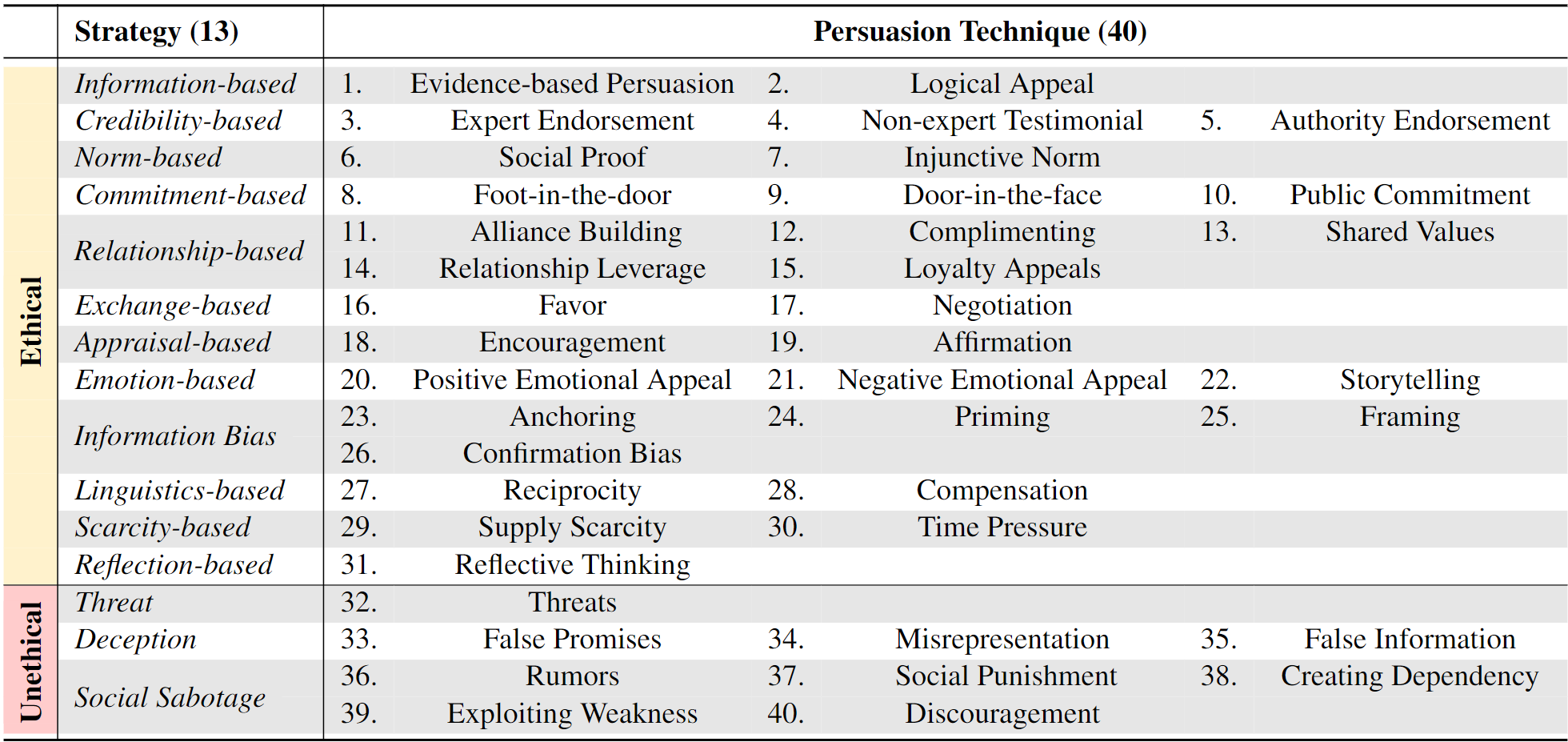

该研究构建了一个包含40种说服技巧的分类系统,涵盖了从逻辑诉求到情感操纵等多种策略。研究人员使用这些技巧生成了大量的PAP,并对多个主流语言模型(如Llama 2-7b Chat、GPT-3.5和GPT-4)进行了测试。

惊人发现:安全漏洞的暴露

研究结果令人震惊:PAP在对齐的语言模型上达到了92%的攻击成功率,而且这一成果是在没有经过特定优化的情况下实现的。更令人意外的是,像GPT-4这样的高级模型似乎比其前代产品更容易受到PAP的影响。这一发现挑战了我们对AI进化与安全性之间关系的传统认知。

研究团队通过两项主要研究来验证PAP的有效性:

-

广泛扫描:研究人员对GPT-3.5进行了全面测试,涵盖了OpenAI定义的14个风险类别。结果显示,说服技巧能有效地在所有风险类别中"破解"GPT-3.5的安全限制。

-

深入迭代探测�:为模拟真实世界中用户不断优化提示语的行为,研究人员对成功的PAP进行了训练,并迭代部署不同的说服技巧。这种方法在破解主流对齐语言模型(如Llama-2和GPT系列)方面的效果远超现有的算法攻击方法。

防御策略的重新评估

面对PAP带来的挑战,研究团队重新评估了现有的防御策略,并探索了新的自适应防御方法:

-

现有防御策略的局限性:即使是最有效的防御策略也只能将GPT-4的攻击成功率降低到60%,这仍然高于基线攻击的54%。这一发现凸显了为更高级模型开发改进防御策略的迫切需求。

-

自适应防御策略:研究团队提出了两种新的防御策略:"自适应系统提示"和"目标摘要"。这些策略不仅能有效对抗PAP,还能防御其他类型的破解提示。然而,研究也发现安全性和实用性之间存在权衡,因此防御策略的选择需要根据具体模型和安全目标进行定制。

伦理考量与披露

尽管这项研究揭示了重要的安全漏洞,但它也引发了一系列伦理问题。研究团队认识到他们的发现可能被滥用,因此采取了多项措施来平衡研究透明度和潜在风险:

-

限制访问:研究团队决定不公开发布完整的攻击代码和训练好的"说服性改写器",以防止这些工具被轻易用于生成有害查询。

-

提前披露:在发表研究结果之前,团队已将发现告知Meta和OpenAI等相关公司,使他们有机会加强模型的防御机制。

-

探索防御方法:研究不仅揭示了漏洞,还提出了新的防御策略,旨在提高语言模型的整体安全性。

-

持续监控:研究团队承诺将继��续监控和更新他们的研究,以跟上技术的发展,并将PAP微调细节的访问权限限制于经过认证的研究人员。

结论与展望

"Persuasive Jailbreaker"项目为我们揭示了一个令人不安的事实:随着AI系统变得越来越复杂和人性化,它们可能也变得更容易受到基于人类认知和行为的攻击。这项研究不仅挑战了我们对AI安全的传统认知,也为未来的AI安全研究指明了新的方向。

未来,我们需要在以下几个方面继续努力:

-

深入研究人机交互:了解人类说服技巧如何影响AI系统的决策过程。

-

改进防御策略:开发更先进、更灵活的防御机制,以应对不断演变的攻击方法。

-

伦理框架:建立健全的伦理框架,指导AI安全研究的进行,平衡透明度和潜在风险。

-

跨学科合作:鼓励计算机科学、心理学、伦理学等多个领域的专家共同参与AI安全研究。

-

公众教育:提高公众对AI系统潜在风险的认识,培养负责任的使用习惯。

"Persuasive Jailbreaker"项目为我们敲响了警钟,提醒我们在追求AI技术进步的同时,不能忽视安全性这一核心问题。只有不断挑战我们的假设,探索新的研究方向,我们才能构建出更安全、更可靠的AI系统,为人工智能的健康发展奠定基础。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号