PicoMLXServer:让本地AI模型运行变得轻而易举

在人工智能快速发展的今天,如何让AI模型更好地服务于本地应用已成为许多开发者关注的焦点。Apple公司推出的MLX AI框架为此提供了强大的支持,而PicoMLXServer则进一步简化了这一过程,为开发者和用户带来了前所未有的便利。

PicoMLXServer的核心优势

PicoMLXServer的设计理念是"简单即是美"。它为MLX Server提供了一个直观的图形用户界面,让用户能够轻松管理和运行本地的MLX模型。以下是PicoMLXServer的几个突出特点:

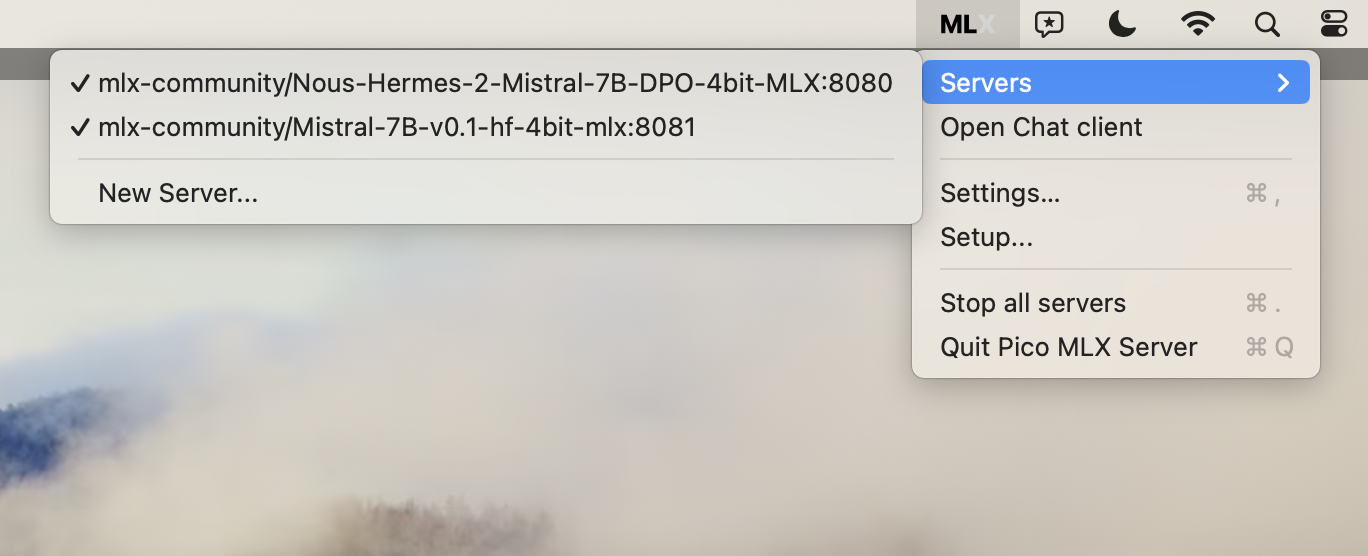

- 便捷的菜单栏操作:通过菜单栏的快捷操作,用户可以快速启动和停止服务器。

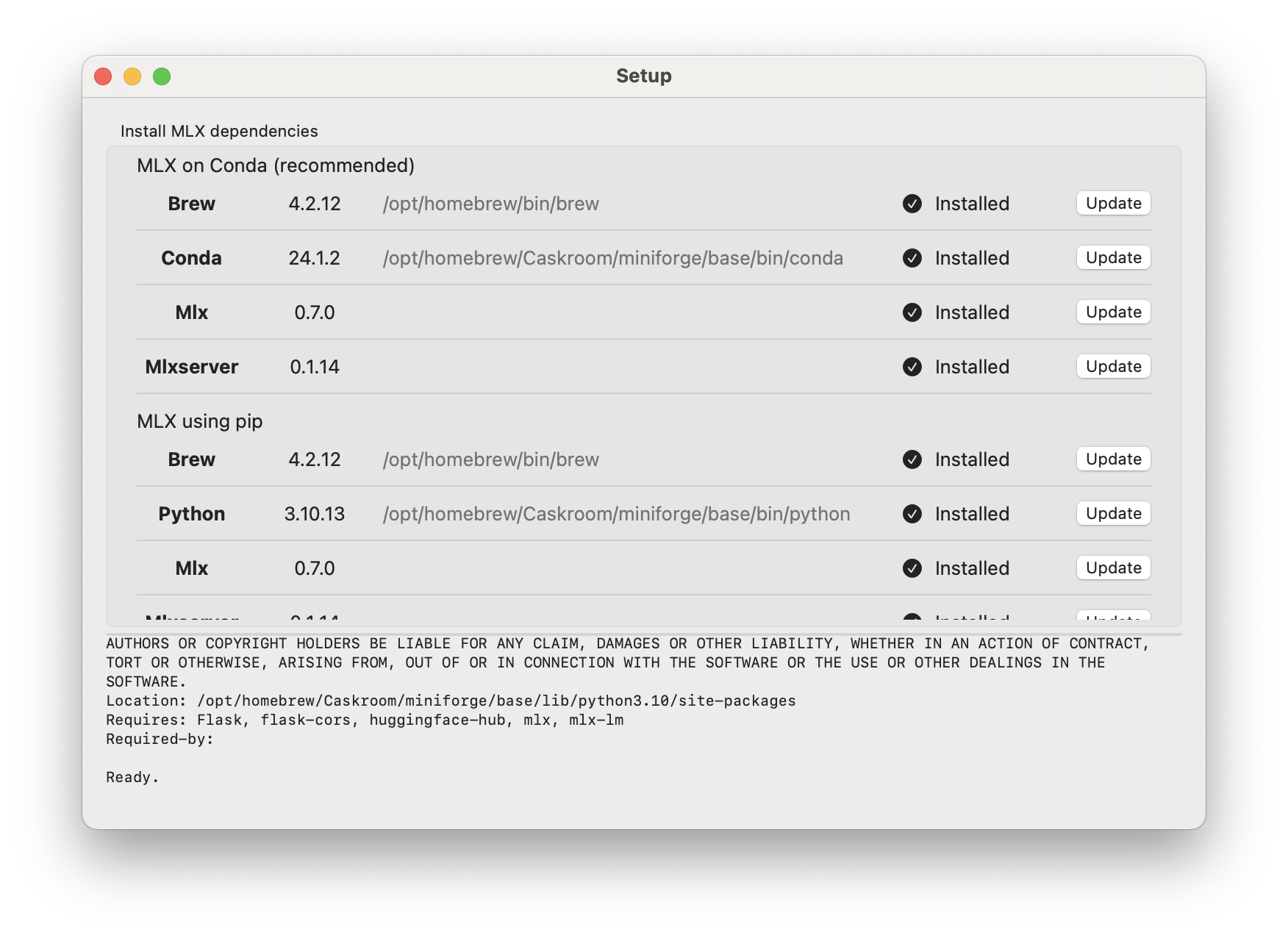

- 自动化的环境配置:PicoMLXServer能够自动安装和设置Python环境、MLX和MLX Server,大大降低了用户的配置门槛。

- 多服务器支持:允许在不同端口运行多个服务器,满足不同场景的需求。

- 实时日志查看:提供单独的窗口用于查看服务器的实时日志,方便调试和监控。

- 自定义聊天客户端链接:默认支持Pico AI Assistant,同时允许用户自定义其他AI聊天客户端。

轻松上手PicoMLXServer

对于想要体验PicoMLXServer的用户来说,入门过程非常简单:

- 安装:用户可以选择从源代码使用Xcode构建,或直接从GitHub下载经过公证的可执行文件。

- 环境配置:PicoMLXServer提供了自动化的设置选项,用户只需在"MLX -> Setup..."中进行简单的操作即可完成环境配置。

- 创建新服务器:通过"MLX -> Servers -> New Server..."可以快速创建新的服务器实例。用户可以选择默认的模型,或从MLX Community上选择其他模型。

- 查看日志:点击"View Logs"按钮即可在单独的窗口中实时查看服务器日志。

PicoMLXServer与AI客户端的无缝对接

PicoMLXServer的一大亮点是其与OpenAI API的兼容性。这意味着任何支持OpenAI API的AI助手都可以与PicoMLXServer配合使用。用户只需将AI客户端指向http://127.0.0.1:8080(或其他在PicoMLXServer中设置的端口),即可开始使用本地运行的MLX模型。

对于开发者来说,PicoMLXServer使用的是OpenAI的POST /v1/completions API,这为集成各种AI应用提供了极大的灵活性。

PicoMLXServer的未来展望

尽管PicoMLXServer已经为用户提供了强大的功能,但其开发团队并未就此止步。未来的发展路线包括:

- 从Python转向MLX Swift,进一步提升性能和集成度。

- 开发基于Swift的HTTP服务器,为整个系统带来更好的一致性和性能优化。

这些计划显示了PicoMLXServer团队对技术创新的不懈追求,也预示着未来用户将能享受到更加高效和强大的本地AI模型运行体验。

PicoMLXServer在AI生态中的地位

PicoMLXServer并非孤立存在,它是一个更大的AI工具生态系统的重要组成部分。与MLX、MLX Swift、MLX Server等项目紧密相连,PicoMLXServer为整个MLX社区带来了更加友好的用户界面和更简化的操作流程。

此外,PicoMLXServer的开发团队还创造了其他优秀的AI工具,如Swift OpenAI Proxy,这进一步丰富了AI开发者的工具箱。这种多元化的工具集合不仅提高了开发效率,也为AI应用的多样化发展提供了坚实的基础。

结语

PicoMLXServer的出现无疑为本地AI模型的运行和管理带来了革命性的变化。它不仅简化了复杂的技术流程,还为AI开发者和普通用户alike提供了一个易于使用的平台。随着AI技术的不断发展,像PicoMLXServer这样的工具将在推动AI民主化和普及化方面发挥越来越重要的作用。

对于想要深入探索AI技术,或者只是想在本地运行强大AI模型的用户来说,PicoMLXServer无疑是一个值得尝试的优秀工具。它不仅能满足当前的需求,还有潜力随着技术的进步不断evolve,为用户带来更多惊喜。让我们期待PicoMLXServer在未来能为AI领域带来更多革新和便利! 🚀🤖