Promptulate: 简化AI应用开发的利器

在人工智能快速发展的今天,大语言模型(LLM)应用开发已成为一个炙手可热的领域。然而,构建高质量的LLM应用往往需要复杂的工程设计和繁琐的代码实现。为了简化这一过程,由Cogit Lab开发的Promptulate框架应运而生。Promptulate通过Pythonic的开发范式,为开发者提供了一种极其简洁高效的方式来构建Agent应用。本文将详细介绍Promptulate的特性、架构、使用方法以及设计理念,展示它如何革新LLM应用开发流程。

Promptulate的核心特性

Promptulate拥有许多强大的特性,使其成为LLM应用开发的理想选择:

-

Pythonic代码风格: Promptulate充分考虑到Python开发者的习惯,提供了Pythonic的SDK调用方式。仅通过一个

pne.chat函数就可以封装所有核心功能,让一切尽在掌握之中。 -

模型兼容性: 支持市面上几乎所有类型的大模型,并且可以轻松定制以满足特定需求。

-

多样化的Agent: 提供各种类型的Agent,如WebAgent、ToolAgent、CodeAgent等,能够进行规划、推理和行动来处理复杂问题。将Planner等组件原子化,以简化开发过程。

-

低成本集成: 轻松集成来自不同框架(如LangChain)的工具,大大降低了集成成本。

-

函数即工具: 可以直接将任何Python函数转换为Agent可用的工具,简化了工具创建和使用流程。

-

生命周期和钩子: 提供丰富的Hooks和全面的生命周期管理,允许在Agent、Tool和LLM的各个阶段插入自定义代码。

-

终端集成: 易于集成应用终端,内置客户端支持,为prompt提供快速调试能力。

-

Prompt缓存: 为LLM Prompt提供缓存机制,减少重复工作,提高开发效率。

-

强大的OpenAI封装: 使用pne后,不再需要使用openai sdk,核心功能可以用pne.chat替代,并提供增强功能以简化开发难度。

-

Streamlit组件集成: 快速原型设计,并提供许多开箱即用的示例和可重用的streamlit组件。

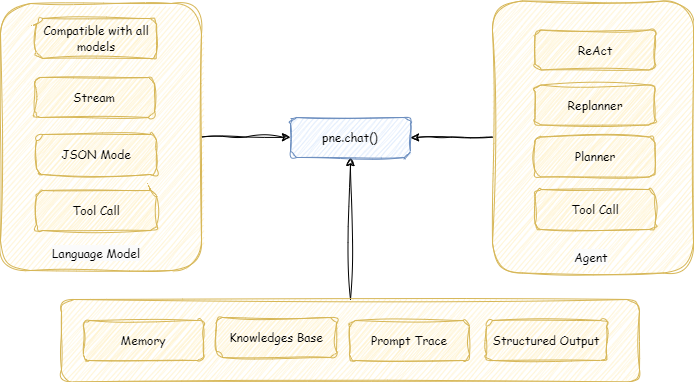

Promptulate的核心理念是提供一种简单、Pythonic且高效的方式来构建AI应用。这意味着你不需要花费大量时间学习框架。我们希望通过pne.chat()就能完成大部分工作,让你只需几行代码就能轻松构建任何AI应用。

支持的基础模型

Promptulate整合了litellm的功能,支持市面上几乎所有类型的大模型,包括但不限于OpenAI、Azure、AWS (SageMaker和Bedrock)、Google (Vertex AI和PaLM)、Anthropic、Cohere等多家提供商的模型。这种强大的模型支持使你能够轻松构建任何第三方模型调用。

快速上手

安装Promptulate非常简单,只需在终端输入以下命令:

pip install promptulate

注意:你的Python版本应该是3.8或更高。

尽管pne提供了许多模块,但在90%的LLM应用开发场景中,你只需使用pne.chat()函数就能完成大部分工作。让我们通过几个示例来了解pne的基本用法。

像OpenAI一样聊天

你可以使用pne.chat()来实现类似OpenAI的聊天功能:

import promptulate as pne

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Who are you?"},

]

response: str = pne.chat(messages=messages, model="gpt-4-turbo")

print(response)

替代OpenAI SDK

许多第三方库可以使用OpenAI SDK调用他们的模型,比如Deepseek。在pne中,你可以直接使用pne.chat()函数来调用这些模型,无需使用OpenAI SDK,并且提供了增强功能以简化开发难度:

import os

import promptulate as pne

os.environ["DEEPSEEK_API_KEY"] = "your api key"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "How are you?"},

]

response = pne.chat(

messages=messages,

model="openai/deepseek-chat",

)

print(response)

结构化输出

稳健的输出格式化是LLM应用开发的基础。使用pne,你可以轻松实现格式化输出:

from typing import List

import promptulate as pne

from pydantic import BaseModel, Field

class LLMResponse(BaseModel):

provinces: List[str] = Field(description="List of provinces' names")

resp: LLMResponse = pne.chat("Please tell me all provinces in China.", output_schema=LLMResponse)

print(resp)

具有规划、工具使用和反思能力的Agent

受Plan-and-Solve论文的启发,pne还允许开发者构建能够通过规划、推理和行动来处理复杂问题的Agent。可以使用enable_plan参数激活Agent的规划能力:

import os

import promptulate as pne

from langchain_community.tools.tavily_search import TavilySearchResults

os.environ["TAVILY_API_KEY"] = "your_tavily_api_key"

os.environ["OPENAI_API_KEY"] = "your_openai_api_key"

tools = [TavilySearchResults(max_results=5)]

pne.chat("what is the hometown of the 2024 Australia open winner?", model="gpt-4-1106-preview", enable_plan=True)

原子化Agent结构

在Agent开发场景中,我们经常需要拆分Agent的许多原子组件以实现更好的定制。pne提供了原子化的Agent组件,如Planner。以下示例展示了如何使用单独的Planner组件进行任务规划:

import promptulate as pne

model = pne.LLMFactory.build("gpt-4-turbo")

planner = pne.Planner(model, system_prompt="You are a planner")

plans = planner.run("Plan a trip to Paris")

print(plans)

Promptulate的设计原则

Promptulate框架的设计原则包括模块化、可扩展性、互操作性、健壮性、可维护性、安全性、效率和易用性。这些原则确保了框架能够适应各种复杂的AI应用开发需求:

- 模块化: 使用模块作为基本单位,便于集成新组件、模型和工具。

- 可扩展性: 框架能够处理大量数据、复杂任务和高并发。

- 互操作性: 与各种外部系统、工具和服务兼容,实现无缝集成和通信。

- 健壮性: 具有强大的错误处理、容错和恢复机制,确保在各种条件下可靠运行。

- 安全性: 实施严格措施以防止未授权访问和恶意行为。

- 效率: 优化框架性能、资源使用和响应时间,确保流畅响应的用户体验。

- 易用性: 使用用户友好的接口和清晰的文档,易于使用和理解。

遵循这些原则并应用最新的人工智能技术,Promptulate旨在为创建自动化代理提供一个强大而灵活的框架。

结语

Promptulate作为一个轻量级的大语言模型自动化与自主语言代理开发框架,为AI应用开发带来了革命性的变化。它不仅简化了开发流程,还提供了丰富的功能和灵活的定制选项,使开发者能够快速构建高质量的LLM应用。无论你是经验丰富的AI工程师还是刚入门的开发者,Promptulate都能为你提供强大的支持,帮助你轻松驾驭LLM应用开发的复杂性。

随着AI技术的不断发展,Promptulate也在持续进化,不断增加新特性和优化现有功能。我们期待看到更多基于Promptulate构建的创新AI应用,为各行各业带来智能化的解决方案。如果你对Promptulate感兴趣,不妨立即尝试,开始你的AI应用开发之旅吧!

🔗 相关链接:

通过Promptulate,让我们共同探索AI应用开发的无限可能!