PyContinual:开启持续学习新篇章

在机器学习领域,持续学习(Continual Learning)近年来受到越来越多的关注。与传统的机器学习方法不同,持续学习旨在使模型能够不断学习新知识,同时保留已学习的知识,从而实现真正的"终身学习"。然而,实现高效的持续学习仍然面临诸多挑战,如灾难性遗忘等问题。为了推动持续学习的研究与应用,来自伊利诺伊大学芝加哥分校的研究团队开发了PyContinual框架,为研究人员提供了一个易用且可扩展的实验平台。

强大而灵活的持续学习工具箱

PyContinual是一个基于PyTorch实现的持续学习框架,集成了多种最先进的持续学习算法。该框架的主要特点包括:

-

丰富的算法支持: PyContinual实现了40多种持续学习基线方法和变体,涵盖了领域内的主要算法,如EWC、LwF、GEM等。研究人员可以方便地比较不同算法的性能。

-

多样化的数据集: 框架支持多种语言数据集(如文档/句子/方面情感分类、自然语言推理、主题分类)和图像数据集(如CelebA、CIFAR10/100、MNIST等)。这使得研究人员可以在不同类型的任务上评估算法性能。

-

灵活的学习场景: PyContinual支持任务增量学习(Task Incremental Learning)和领域增量学习(Domain Incremental Learning)两种主要的持续学习场景,满足不同的研究需求。

-

易于使用和扩展: 用户只需修改少量参数就可以运行不同的基线方法和数据集。同时,框架的模块化设计也方便研究人员扩展自己的模型和方法。

-

高效的训练模式: 除了支持单GPU训练,PyContinual还可以配置为多节点分布式训练和混合精度训练,提高了大规模实验的效率。

深入PyContinual的核心功能

让我们进一步了解PyContinual的一些核心功能和使用方法:

1. 简单易用的接口

PyContinual提供了简洁的命令行接口,用户只需修改几个关键参数就可以运行不同的实验配置。例如:

python run.py \

--bert_model 'bert-base-uncased' \

--backbone bert_adapter \

--baseline ctr \

--task asc \

--eval_batch_size 128 \

--train_batch_size 32 \

--scenario til_classification \

--idrandom 0 \

--use_predefine_args

这个命令使用BERT作为backbone,运行CTR算法在方面级情感分类(ASC)任务上进行任务增量学习。用户可以轻松更改baseline、backbone和task等参数来运行不同的实验配置。

2. 灵活的模型扩展

PyContinual采用模块化设计,方便研究人员扩展自己的模型。用户只需在./dataloader、./networks和./approaches目录下编写相应的代码,就可以集成新的数据集、网络结构和学习算法。

3. 丰富的评估指标

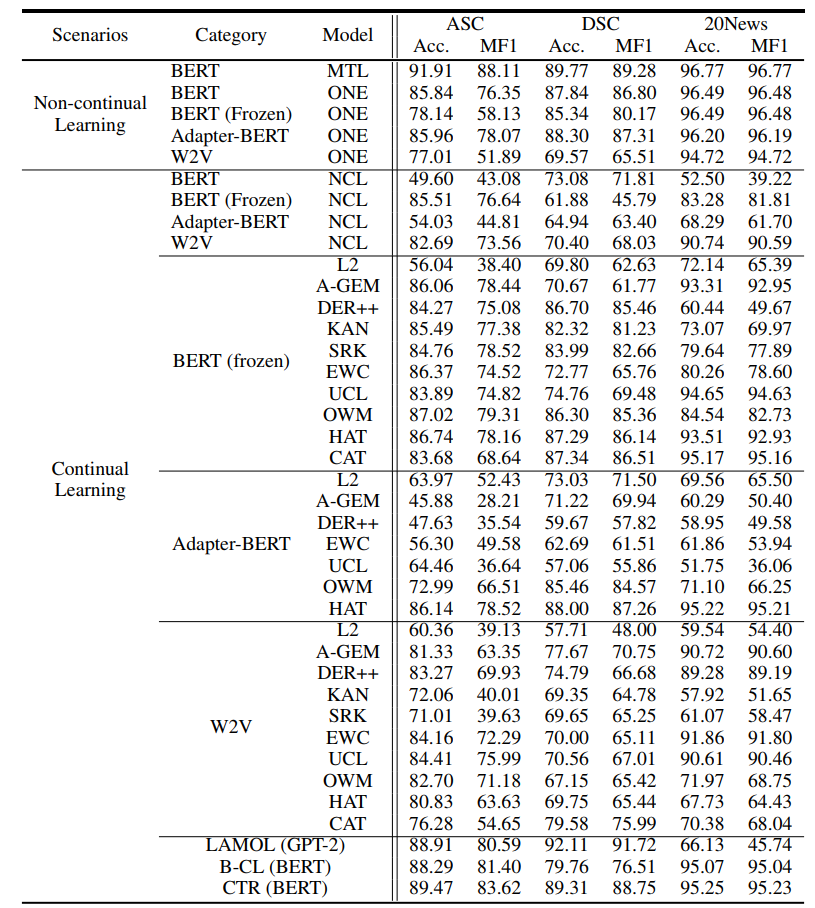

PyContinual提供了丰富的评估指标来衡量持续学习算法的性能。上图展示了不同算法在ASC任务上的性能比较,包括平均准确率、前向迁移和后向迁移等指标。这些全面的评估结果有助于研究人员深入分析算法的优劣。

PyContinual的应用与影响

PyContinual不仅是一个实验框架,更是多项重要研究成果的基础。以下是一些基于PyContinual的代表性工作:

-

《Achieving Forgetting Prevention and Knowledge Transfer in Continual Learning》(NeurIPS 2021): 提出了一种新的持续学习方法,同时实现了知识保留和知识迁移。

-

《CLASSIC: Continual and Contrastive Learning of Aspect Sentiment Classification Tasks》(EMNLP 2021): 将对比学习引入持续学习,提高了模型在方面级情感分类任务上的性能。

-

《Adapting BERT for Continual Learning of a Sequence of Aspect Sentiment Classification Tasks》(NAACL 2021): 探讨了如何将预训练语言模型BERT应用于持续学习场景。

这些研究不仅推动了持续学习算法的发展,也为自然语言处理等领域的持续学习应用提供了新的思路。

未来展望

尽管PyContinual已经提供了丰富的功能,但持续学习领域仍有诸多挑战待解决。未来,PyContinual团队计划在以下方向继续完善框架:

-

更多的预训练模型支持: 除了BERT,计划增加对RoBERTa、BART等更多预训练语言模型的支持。

-

生成式任务: 目前主要关注分类任务,未来将扩展到文本生成等更复杂的任务。

-

效率优化: 进一步优化分布式训练和混合精度训练,提高大规模实验的效率。

-

跨模态学习: 探索视觉-语言等跨模态持续学习场景。

-

实际应用: 将持续学习算法应用到实际的NLP系统中,如对话系统、推荐系统等。

结语

PyContinual为持续学习研究提供了一个强大而灵活的工具,大大降低了进入该领域的门槛。无论是初学者还是经验丰富的研究人员,都可以利用PyContinual快速开展实验、验证想法。随着框架的不断完善和社区的持续贡献,我们有理由相信,PyContinual将在推动持续学习技术发展和应用落地方面发挥越来越重要的作用。

如果您对持续学习感兴趣,不妨访问PyContinual的GitHub仓库,亲身体验这个强大的框架。同时,也欢迎您为项目贡献代码,共同推动持续学习技术的进步。让我们携手开启人工智能持续学习的新篇章!