RegionSpot:开创性的开放世界视觉区域识别模型

在计算机视觉领域,理解和识别图像中的任意区域一直是一个具有挑战性的任务。近日,Surrey大学的研究团队提出了一种名为RegionSpot的创新模型,为这一难题带来了突破性的解决方案。

RegionSpot的核心理念

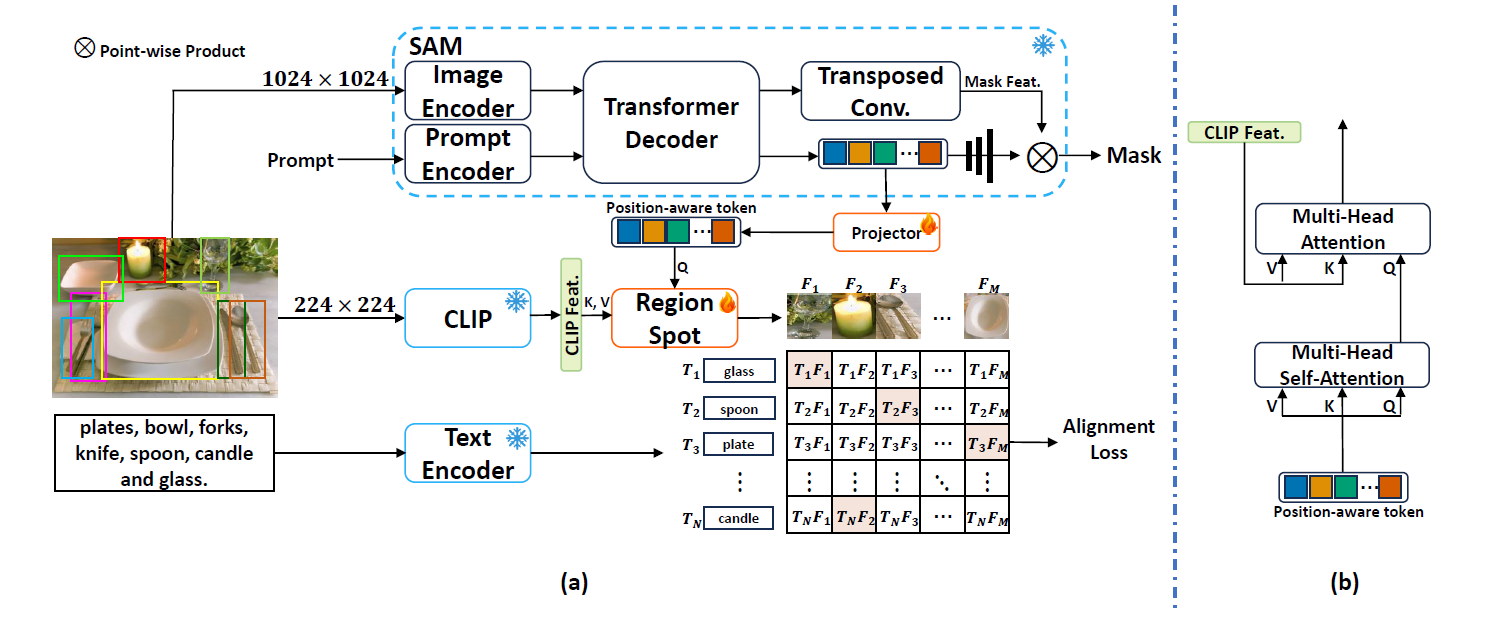

RegionSpot的核心思想是充分利用现有的基础模型,将它们的优势结合起来。具体而言,RegionSpot融合了定位基础模型(如SAM)的位置感知能力和视觉-语言模型(如CLIP)的语义理解能力。这种独特的组合使得RegionSpot能够在不需要大规模训练数据的情况下,实现高效准确的开放世界区域识别。

技术创新点

-

冻结基础模型: RegionSpot保持SAM和CLIP模型参数不变,仅优化一个轻量级的注意力模块来整合两个模型的知识。这大大减少了训练开销,同时保留了预训练模型的强大能力。

-

位置感知token: 通过将SAM的mask embeddings转换为位置感知的token,RegionSpot能够准确捕捉目标的空间信息。

-

高效训练: 相比其他方法动辄需要几万GPU小时的训练,RegionSpot仅需200 GPU小时即可完成训练,极大地提高了效率。

性能表现

在多个benchmark上,RegionSpot展现出了卓越的性能:

- 在LVIS数据集上,RegionSpot-Pro↑336相比GLIP-L在罕见类别上提升了13.1个AP,在整体mAP上提升了2.9。

- 在ODinW数据集上,RegionSpot-Pro↑336比GLIP-L平均提高了2.5个AP。

- 在LVIS minival集上,RegionSpot-Pro↑336在罕见类别上比GroundingDINO-L高出11.0个AP。

这些结果充分证明了RegionSpot在开放世界目标识别任务上的强大能力,尤其是在处理罕见类别时表现突出。

应用示例

RegionSpot的使用非常简单直观。以下是一个简单的代码示例:

from regionspot.modeling.regionspot import build_regionspot_model

from regionspot import RegionSpot_Predictor

custom_vocabulary = ['<custom>']

clip_type = <clip_type>

regionspot = build_regionspot_model(checkpoint="<path/to/checkpoint>", custom_vocabulary=custom_vocabulary, clip_type=clip_type)

predictor = RegionSpot_Predictor(regionspot)

predictor.set_image(<your_image>)

masks, mask_iou_score, class_score, class_index = predictor.predict(<input_prompts>)

通过这几行代码,用户就可以轻松地使用RegionSpot来识别图像中的任意区域。

潜在应用领域

RegionSpot的出现为多个领域带来了新的可能性:

- 自动图像标注: 可以大幅提高图像数据集的标注效率。

- 视觉问答系统: 增强AI系统对图像内容的理解和交互能力。

- 医疗影像分析: 协助医生快速识别和定位潜在的病变区域。

- 自动驾驶: 提高车辆对复杂道路环境的感知能力。

- 工业质检: 自动检测产品缺陷,提高生产效率。

未来展望

尽管RegionSpot已经展现出了强大的性能,但研究团队认为仍有进一步提升的空间:

- 多模态融合: 探索将更多模态(如文本、音频)融入模型中,进一步增强识别能力。

- 实时性能优化: 提高模型的推理速度,使其能够在实时场景中应用。

- 跨域迁移: 研究如何让模型更好地适应不同领域的数据,提高通用性。

结语

RegionSpot的出现无疑为开放世界视觉区域识别任务带来了一个强有力的解决方案。它不仅在性能上超越了现有方法,更在训练效率和模型灵活性上有着显著优势。随着进一步的研究和优化,我们有理由相信RegionSpot将在计算机视觉领域发挥越来越重要的作用,为更多实际应用场景带来革命性的变革。

对于有兴趣深入了解或使用RegionSpot的读者,可以访问项目的GitHub仓库获取更多信息和资源。让我们共同期待RegionSpot在未来带来的更多惊喜和突破!