serverless-chat-langchainjs学习资料汇总 - 使用LangChain.js构建无服务器AI聊天应用

serverless-chat-langchainjs是一个使用LangChain.js和Azure无服务器技术构建的AI聊天应用示例。本文将介绍该项目的主要特性、架构以及如何开始使用。

项目概述

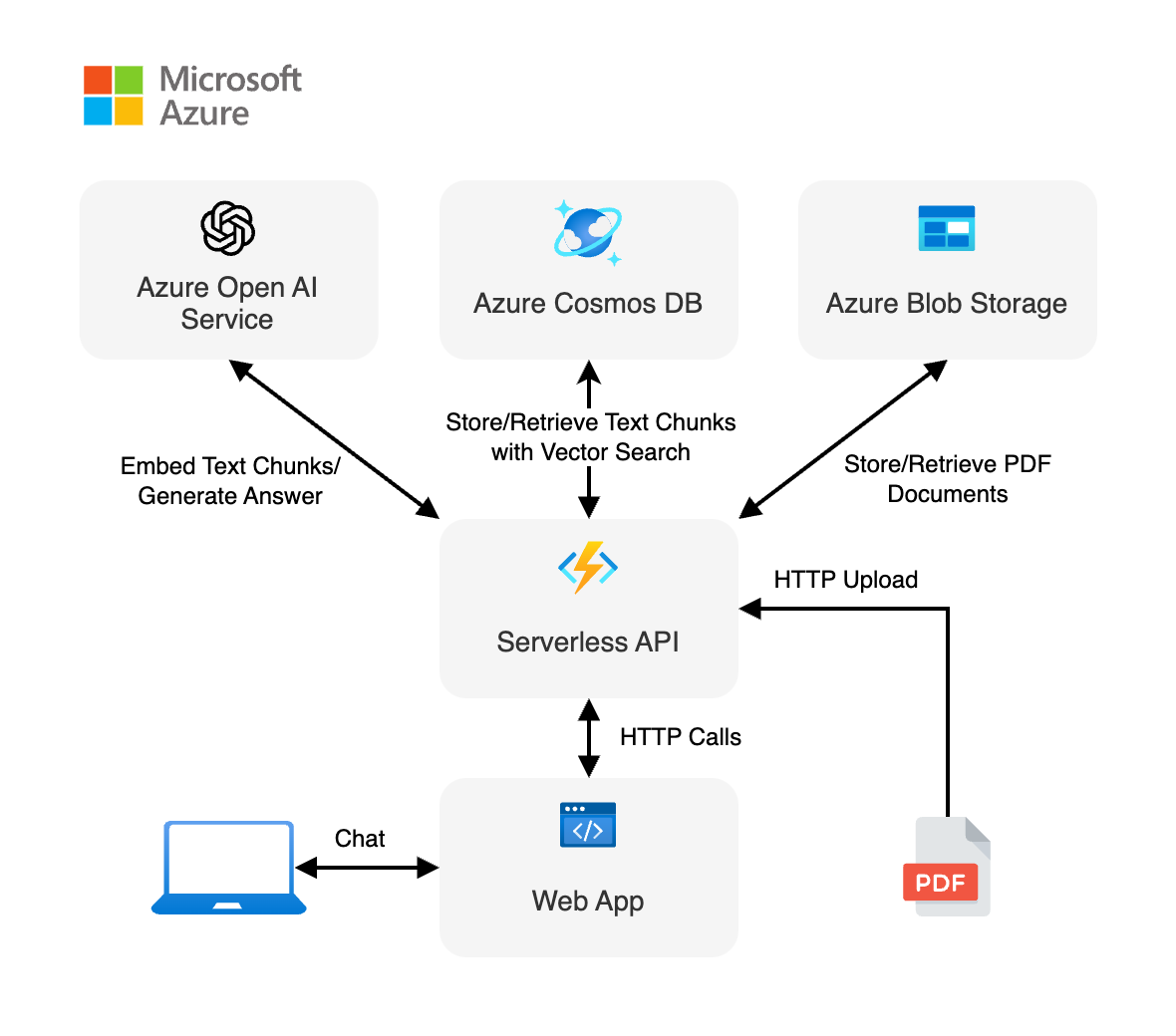

该项目展示了如何使用LangChain.js和Azure构建一个具有检索增强生成(RAG)功能的无服务器AI聊天体验。应用程序托管在Azure Static Web Apps和Azure Functions上,使用Azure Cosmos DB for NoSQL作为向量数据库。您可以将其作为构建更复杂AI应用程序的起点。

主要特性包括:

- 无服务器架构:利用Azure Functions和Azure Static Web Apps实现完全无服务器部署

- 检索增强生成(RAG):结合Azure Cosmos DB和LangChain.js的功能,提供相关和准确的响应

- 可扩展和经济高效:利用Azure的无服务器产品提供可扩展和经济高效的解决方案

- 本地开发:支持使用Ollama进行本地开发和测试,无需任何云成本

快速开始

有多种方法可以开始使用这个项目:

- 使用GitHub Codespaces(推荐):提供预配置的环境,可以直接在浏览器中运行

- 在本地环境中设置:按照说明在本地机器上设置开发环境

使用GitHub Codespaces

本地环境设置

需要安装以下工具:

- Node.js LTS

- Azure Developer CLI

- Git

- PowerShell 7+ (仅限Windows用户)

- Azure Functions Core Tools

然后克隆项目代码:

git clone <your-forked-repo-url>

运行示例

有多种方法运行此示例:

- 本地使用Ollama运行

- 本地使用Azure OpenAI模型运行

- 部署到Azure

本地使用Ollama运行

- 安装Ollama

- 下载所需模型:

ollama pull mistral:v0.2

ollama pull all-minilm:l6-v2

- 安装依赖:

npm install

- 启动应用:

npm start

- 在浏览器中打开 http://localhost:8000

部署到Azure

- 打开终端,导航到项目根目录

- 运行

azd auth login进行身份验证 - 运行

azd up部署应用程序到Azure

部署完成后,您将在终端中看到Web应用的URL。

学习资源

- LangChain.js文档

- Azure Static Web Apps文档

- Azure Functions文档

- Azure Cosmos DB for NoSQL文档

- Generative AI For Beginners课程

常见问题

常见问题解答请查看FAQ。

故障排除

如果运行或部署此示例时遇到任何问题,请查看故障排除指南。

通过本文的介绍,您应该对serverless-chat-langchainjs项目有了初步的了解。欢迎阅读更多文档并尝试使用,如有任何问题,可以在GitHub仓库中提出issue。