SGPT: 基于GPT的语义搜索句子嵌入

SGPT: 基于GPT的语义搜索句子嵌入

语义搜索是信息检索领域的一个重要任务,其目标是根据语义相似度而非简单的关键词匹配来检索相关文档。近年来,随着预训练语言模型的发展,基于神经网络的语义搜索方法取得了显著进展。本文介绍了一种新的语义搜索方法 - SGPT(GPT Sentence Embeddings for Semantic Search),该方法利用GPT模型生成高质量的句子嵌入,可用于多种语义搜索场景。

SGPT的核心思想

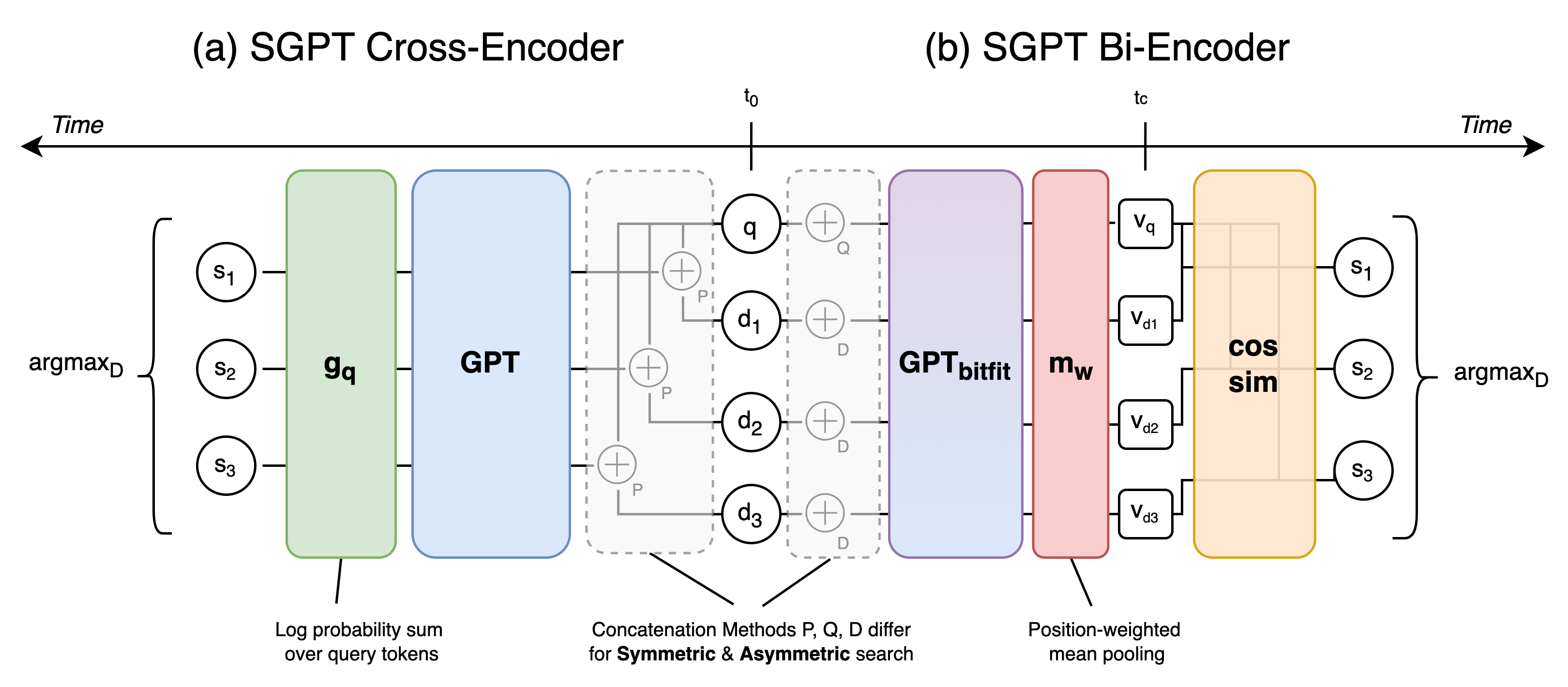

SGPT的核心思想是利用GPT等大规模预训练语言模型的强大语义理解能力,将其应用到语义搜索任务中。具体来说,SGPT提出了两种主要的模型架构:

-

SGPT-BE (Bi-Encoder): 双编码器架构,分别对查询和文档进行编码,然后计算相似度。

-

SGPT-CE (Cross-Encoder): 交叉编码器架构,将查询和文档作为一个整体输入模型,直接预测相关性分数。

这两种架构都可以应用于对称搜索(查询和文档使用相同的编码方式)和非对称搜索(查询和文档使用不同的编码方式)场景。

SGPT-BE: 基于GPT的双编码器

SGPT-BE采用了一种创新的方法来生成句子嵌入:

-

只微调GPT模型的偏置张量,保持其他参数固定,这样可以大大减少需要训练的参数量。

-

使用位置加权平均池化来生成固定长度的句子表示。具体来说,对每个token的表示按其在序列中的位置进行加权,然后取平均。

-

对于非对称搜索,在查询和文档前分别添加特殊标记([和{),以区分它们的角色。

通过这种方法,SGPT-BE可以生成高质量的句子嵌入,同时保持计算效率。

SGPT-CE: 基于GPT的交叉编码器

SGPT-CE直接利用GPT模型的语言建模能力来评估查询-文档对的相关性:

-

将查询和文档拼接成一个序列,输入GPT模型。

-

计算模型对查询部分的对数概率,作为相关性分数。

-

无需任何微调,直接使用预训练的GPT模型。

这种方法充分利用了GPT模型的零样本学习能力,可以在没有任何训练数据的情况下进行语义搜索。

SGPT的优势

SGPT相比传统方法具有以下优势:

-

利用大规模预训练语言模型的强大语义理解能力。

-

支持双编码器和交叉编码器两种架构,适用于不同的应用场景。

-

可用于对称和非对称搜索,灵活性高。

-

SGPT-BE只需微调少量参数,训练效率高。

-

SGPT-CE无需微调,可直接进行零样本语义搜索。

实验结果

研究者在多个基准数据集上评估了SGPT的性能,包括BEIR(异构领域检索)和USEB(同构领域检索)。实验结果表明:

-

在BEIR上,SGPT-BE(5.8B参数)在27个数据集中的22个上优于DPR等强基线。

-

在USEB上,SGPT-BE(5.8B参数)在所有6个数据集上都取得了最佳性能。

-

SGPT-CE展现出强大的零样本能力,在多个数据集上超越了经过微调的BERT交叉编码器。

-

增加模型规模可以持续提升性能,表明SGPT有潜力从更大的语言模型中受益。

这些结果充分证明了SGPT在语义搜索任务上的有效性和潜力。

使用SGPT

研究者提供了多种使用SGPT的方式,包括:

-

基于Hugging Face Transformers的实现:

- 支持SGPT-BE和SGPT-CE

- 提供了对称和非对称搜索的示例代码

-

基于Sentence Transformers的实现:

- 与流行的Sentence Transformers库兼容

- 提供了简单易用的API

-

预训练�模型:

- 在Hugging Face Model Hub上提供了多个预训练模型

- 包括不同参数规模(从125M到5.8B)的模型

这些实现和预训练模型大大降低了使用SGPT的门槛,使其可以被广泛应用于各种语义搜索场景。

总结与展望

SGPT为语义搜索提供了一种新的范式,通过利用GPT等大规模预训练语言模型的能力,在多个基准测试中取得了优异的性能。它的灵活架构和简单有效的实现使其具有广阔的应用前景。

未来的研究方向可能包括:

-

探索更大规模的语言模型(如GPT-3)在SGPT中的应用。

-

将SGPT扩展到多语言和跨语言语义搜索场景。

-

研究如何进一步提高SGPT的计算效率,使其适用于大规模实时搜索系统。

-

将SGPT与其他信息检索技术(如稀疏检索)结合,构建更强大的混合搜索系统。

总的来说,SGPT为语义搜索领域带来了新的机遇和挑战,有望推动该领域的进一步发展。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号