SimAlign:突破传统的词对齐新方法

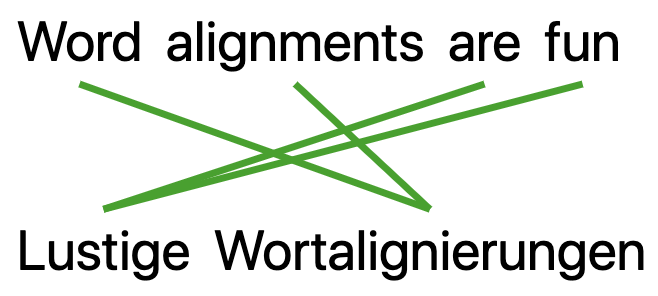

在自然语言处理(NLP)领域,词对齐是一项至关重要的任务,对机器翻译、跨语言信息检索等多项应用都有重要意义。传统的统计词对齐方法虽然表现不错,但通常需要大量的平行语料数据作为训练资源。而近期由CIS研究团队开发的SimAlign方法,则开创性地提出了一种无需平行训练数据的词对齐新思路,引起了学术界的广泛关注。

SimAlign的核心思想

SimAlign的核心思想是充分利用预训练语言模型(如多语言BERT)所蕴含的跨语言语义信息,通过静态和上下文化的多语言词嵌入来计算词间相似度,从而实现高质量的词对齐。这种方法的独特之处在于:

- 无需平行语料训练数据,只需利用单语资源即可构建多语言词嵌入

- 结合了静态词嵌入和基于上下文的动态词嵌入,能更全面地捕捉词义信息

- 采用了多种匹配算法(如最大权匹配、迭代最大匹配等),进一步提升对齐质量

性能评估

研究团队在多个语言对上对SimAlign进行了全面评估。结果表明,SimAlign在多数情况下都能达到或超越传统统计对齐方法的表现:

如上图所示,SimAlign在英语-德语等语言对上的F1分数比使用10万句平行语料训练的eflomal高出5个百分点,充分展示了该方法的优越性。

技术实现

SimAlign的实现主要基于Python和PyTorch框架。其核心代码结构如下:

from simalign import SentenceAligner

# 初始化对齐器

myaligner = SentenceAligner(model="bert", token_type="bpe", matching_methods="mai")

# 输入待对齐的源语言和目标语言句子

src_sentence = ["This", "is", "a", "test", "."]

trg_sentence = ["Das", "ist", "ein", "Test", "."]

# 获取词对齐结果

alignments = myaligner.get_word_aligns(src_sentence, trg_sentence)

# 输出不同匹配方法的对齐结果

for matching_method in alignments:

print(matching_method, ":", alignments[matching_method])

SimAlign支持多种预训练模型和匹配算法,用户可以根据具体需求进行灵活配置。

应用前景

SimAlign为多项NLP任务带来了新的可能性:

- 机器翻译: 可用于神经机器翻译模型的训练和优化

- 跨语言信息抽取: 帮助在低资源语言中构建信息抽取系统

- 词典构建: 自动发现和验证双语词典条目

- 跨语言迁移学习: 为模型在不同语言间的迁移提供对齐信息

结语

SimAlign的提出为词对齐这一经典NLP任务带来了全新视角。它不仅在技术上实现了突破,更重要的是为低资源语言的NLP应用开辟了新的可能性。随着预训练语言模型的不断发展,我们有理由相信,SimAlign及其衍生方法将在未来的跨语言NLP研究和应用中发挥越来越重要的作用。