引言

在人工智能和机器学习领域,扩散模型(Diffusion Models)已经成为生成高质量图像的强大工具。然而,这些模型的训练过程往往耗时较长,限制了其在实际应用中的广泛使用。为了解决这一问题,来自新加坡国立大学、深圳技术大学等机构的研究团队提出了一种名为SpeeD的创新方法,旨在显著加快扩散模型的训练速度。

SpeeD的核心思想

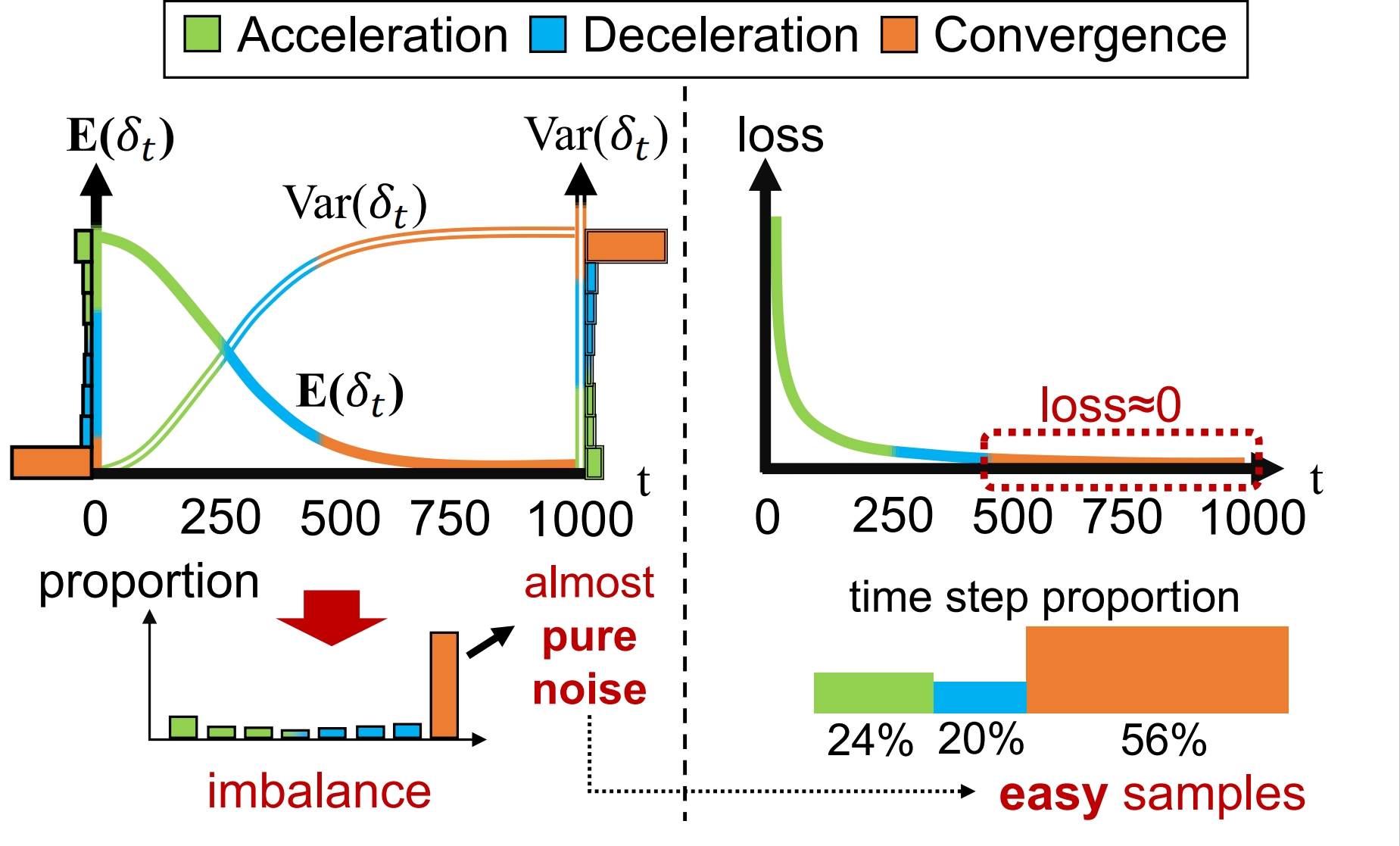

SpeeD的核心思想源于对扩散过程中时间步长的深入研究。研究团队发现,在扩散过程中,不同时间步长对模型训练的贡献并不均衡。具体来说,时间步长可以大致划分为三个区域:加速区、减速区和收敛区。

研究发现,收敛区的样本对训练的贡献较小,但却占用了大量的计算资源。基于这一观察,SpeeD提出了两个关键策略:

- 非对称采样(Asymmetric Sampling):降低收敛区时间步长的参与度。

- 变化感知权重(Change-Aware Weighting):为扩散过程中变化较快的时间步长赋予更高的权重。

通过这两个策略的结合,SpeeD成功地在保持生成质量的同时,大幅提升了训练速度。

SpeeD的实现细节

SpeeD的实现基于Facebook Research的DiT(Scalable Diffusion Models with Transformers)项目,并使用OmegaConf进行配置管理。研究团队重构了DiT的代码,使其更易于修改实验设置和参数。

SpeeD的主要实现步骤包括:

- 环境配置:使用conda或pip安装必要的依赖包。

- 训练过程:使用torchrun命令进行多GPU训练。

- 推理过程:生成用于测试的样本。

- 采样过程:生成可视化用的图像样本。

例如,要进行基于ImageNet数据集的256x256分辨率的类条件图像生成任务,可以使用以下命令:

# 训练

torchrun --nproc_per_node=8 main.py -c configs/image/imagenet_256/base.yaml -p train

# 推理

torchrun --nproc_per_node=8 main.py -c configs/image/imagenet_256/base.yaml -p inference

# 采样

python main.py -c configs/image/imagenet_256/base.yaml -p sample

SpeeD的性能优势

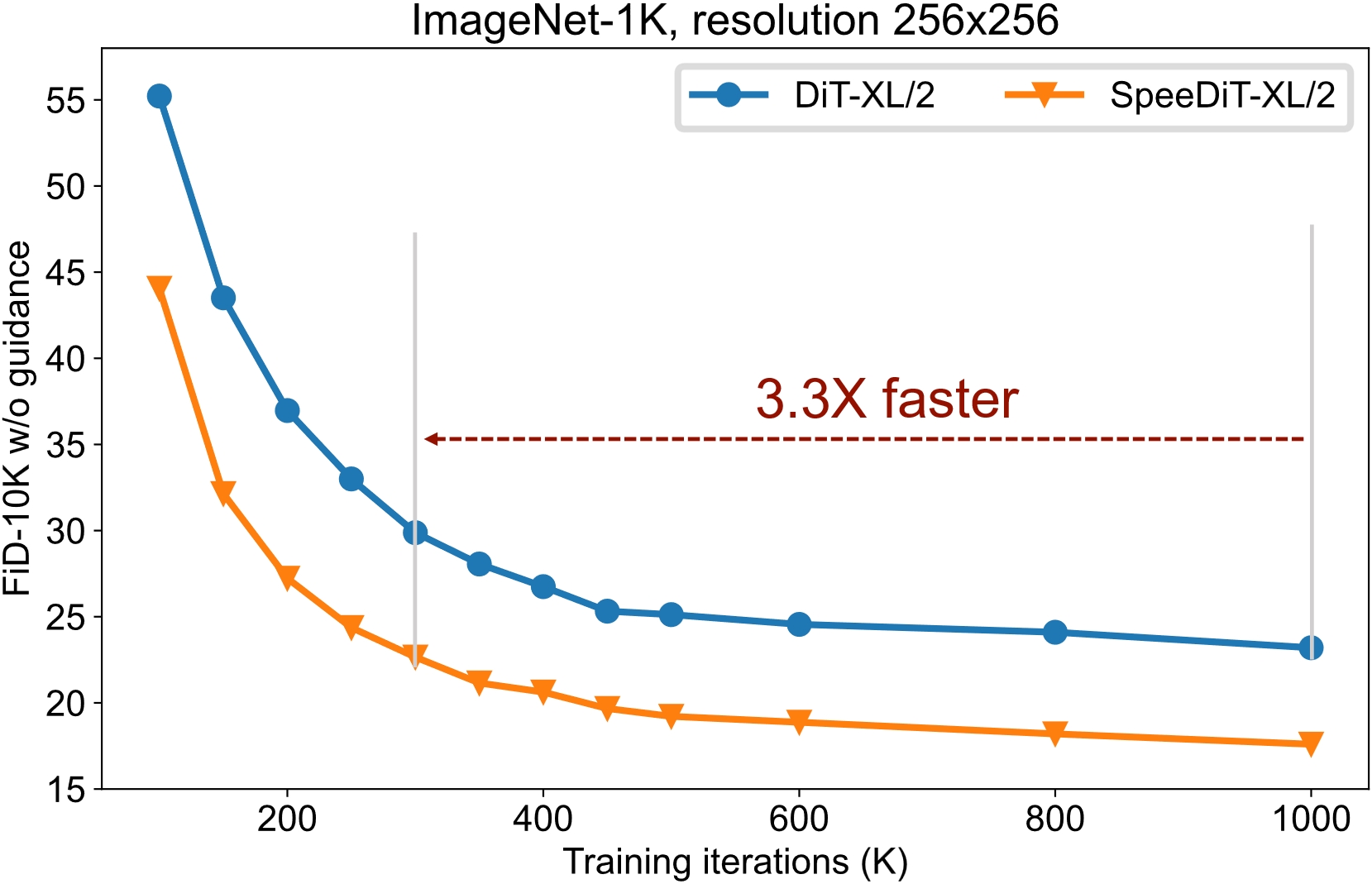

SpeeD的最大亮点在于其显著的性能提升。根据研究团队的实验结果,SpeeD能够将扩散模型的训练速度提高约3倍,同时保持生成图像的质量。

这一突破性的成果不仅大大缩短了模型的训练时间,还降低了计算资源的消耗,为扩散模型在实际应用中的推广铺平了道路。

SpeeD的应用前景

SpeeD的出现为扩散模型的应用开辟了新的可能性。以下是一些潜在的应用领域:

- 高分辨率图像生成:加速高质量、高分辨率图像的生成过程。

- 视频生成:为基于扩散模型的视频生成任务提供更高效的训练方法。

- 3D模型生成:加速3D模型的生成和渲染过程。

- 艺术创作:为数字艺术家提供更快速的创作工具。

- 医学图像处理:加速医学图像的生成和分析。

SpeeD的未来发展

尽管SpeeD在扩散模型训练加速方面取得了显著成果,但研究团队表示,这只是一个开始。未来,他们计划进一步优化SpeeD,使其适用于更多类型的生成任务。同时,他们也呼吁更多研究者加入到这一领域,共同推动扩散模型技术的进步。

开源贡献

SpeeD项目已在GitHub上开源,欢迎社区成员参与贡献。项目地址:SpeeD GitHub Repository

研究团队特别感谢以下项目的贡献:

结论

SpeeD的出现无疑是扩散模型领域的一个重要里程碑。通过创新的时间步长处理方法,SpeeD成功地在保持生成质量的同时,将训练速度提升了约3倍。这一突破不仅大大提高了扩散模型的实用性,也为未来更多高效生成模型的研究指明了方向。

随着SpeeD的开源和不断完善,我们有理由相信,未来会有更多基于扩散模型的创新应用涌现,为人工智能和创意产业带来新的机遇和挑战。让我们共同期待SpeeD为AI生成领域带来的更多惊喜!

参考文献

如果您在研究中使用了SpeeD,请考虑引用以下论文:

@article{wang2024closer,

title={A Closer Look at Time Steps is Worthy of Triple Speed-Up for Diffusion Model Training},

author={Kai Wang, Yukun Zhou, Mingjia Shi, Zhihang Yuan, Yuzhang Shang, Xiaojiang Peng, Hanwang Zhang and Yang You},

year={2024},

journal={arXiv preprint arXiv:2405.17403},

}

让我们一起为AI的未来贡献力量,推动技术的不断进步!🚀💡🌟