引言

在当今大数据和人工智能快速发展的时代,如何高效地处理和加载海量数据集已成为机器学习领域面临的一大挑战。为了解决这一问题,MosaicML团队开发了StreamingDataset - 一个革命性的数据流式传输库,旨在为大规模神经网络训练提供最快、最经济、最具可扩展性的数据加载解决方案。

StreamingDataset的设计理念是让训练过程变得更加简单高效,无论训练数据位于何处,都能实现数据的按需流式传输。这一创新技术不仅大大提升了训练效率,还为研究人员和开发者提供了更大的灵活性。本文将深入探讨StreamingDataset的核心特性、使用方法以及它在机器学习领域的重要应用。

StreamingDataset的核心特性

1. 无缝数据混合

StreamingDataset的一大亮点是其强大的数据混合能力。通过Stream类,用户可以轻松地实现不同数据集的混合,并精确控制每个数据集的采样比例。这种灵活的数据混合机制为研究人员提供了进行各种实验的可能性,使得模型训练更加多样化和高效。

例如,用户可以这样混合不同的数据集:

streams = [

Stream(remote='s3://datasets/c4', proportion=0.4),

Stream(remote='s3://datasets/github', proportion=0.1),

Stream(remote='gcs://datasets/my_internal', proportion=0.5),

]

dataset = StreamingDataset(

streams=streams,

samples_per_epoch=1e8,

)

这种方式允许研究人员灵活地组合和调整不同数据源的比例,从而优化模型的训练效果。

2. 真正的确定性

StreamingDataset的另一个突出特性是其真正的确定性。无论使用多少GPU、节点或CPU工作线程,数据样本的顺序都保持一致。这一特性带来了多方面的好处:

- 更容易重现和调试训练过程和损失峰值

- 可以在不同规模的硬件配置间无缝切换,如从64个GPU训练转移到8个GPU上调试,而保持结果的可重现性

如图所示,无论在1、8、16、32还是64个GPU上训练,模型都能得到完全相同的损失曲线,这充分证明了StreamingDataset的确定性特性。

3. 即时中断恢复

在长时间的训练过程中,硬件故障或意外中断是常见的问题。传统的数据加载方式可能需要花费大量时间重新加载数据。而StreamingDataset凭借其确定性的样本排序,能够在几秒钟内恢复训练,而不是几小时。

这一特性不仅节省了宝贵的时间,还大大减少了因数据重新加载而产生的额外成本,如云存储的出口费用和GPU的空闲时间。对于大规模训练项目而言,这可以节省数千美元的开支。

4. 高吞吐量

StreamingDataset采用了高效的MDS格式,最大限度地减少了不必要的处理工作,从而实现了超低的样本延迟和更高的吞吐量。在数据加载成为瓶颈的工作负载中,StreamingDataset的性能优势尤为明显。

以下是ImageNet + ResNet-50训练的性能对比:

| 工具 | 吞吐量 |

|---|---|

| StreamingDataset | ~19000 img/sec |

| ImageFolder | ~18000 img/sec |

| WebDataset | ~16000 img/sec |

这些数据清楚地表明,StreamingDataset在数据加载效率方面具有显著优势。

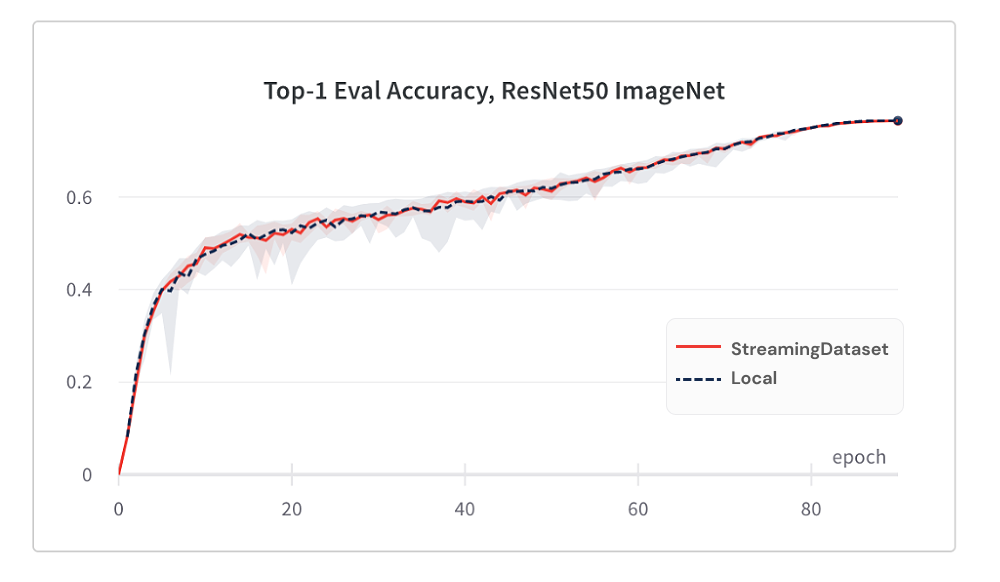

5. 卓越的收敛性能

尽管StreamingDataset采用了流式传输的方式,但它并未牺牲模型的收敛性能。事实上,使用StreamingDataset训练的模型能够达到与使用本地磁盘数据相当的收敛效果。这要归功于其先进的数据打乱算法。

下面是ImageNet + ResNet-50训练的Top-1准确率对比:

| 工具 | Top-1准确率 |

|---|---|

| StreamingDataset | 76.51% +/- 0.09 |

| ImageFolder | 76.57% +/- 0.10 |

| WebDataset | 76.23% +/- 0.17 |

这些数据充分证明,StreamingDataset不仅提高了数据加载的效率,还能确保模型达到最佳的训练效果。

6. 随机访问能力

StreamingDataset提供了强大的随机访问能力。即使某个样本尚未下载,用户也可以通过dataset[i]直接访问第i个样本。系统会立即启动下载,并在完成后返回结果。这种类似于PyTorch map-style数据集的访问方式,为研究人员提供了更大的灵活性。

dataset = StreamingDataset(...)

sample = dataset[19543]

7. 无分割要求

与一些要求数据集大小必须能被设备数量整除的解决方案不同,StreamingDataset可以轻松处理任意数量的样本。它通过智能的样本重复机制,确保每个设备处理相同数量的样本,而不会丢弃任何数据。

dataset = StreamingDataset(...)

dl = DataLoader(dataset, num_workers=...)

8. 磁盘使用限制

为了适应不同的硬件环境,StreamingDataset提供了磁盘使用限制功能。用户可以通过设置cache_limit参数,动态删除最近最少使用的数据分片,以保持磁盘使用量在指定限制之下。

dataset = StreamingDataset(

cache_limit='100gb',

...

)

StreamingDataset的应用实例

StreamingDataset已在多个重要的机器学习项目中得到应用,展现出其强大的实力:

- BioMedLM: MosaicML与斯坦福CRFM合作开发的生物医学领域大型语言模型。

- Mosaic Diffusion Models: 以不到16万美元的成本从头训练Stable Diffusion模型。

- Mosaic LLMs: 以不到50万美元的成本实现GPT-3级别的性能。

- Mosaic ResNet: 通过Mosaic ResNet和Composer实现超高速的计算机视觉训练。

- Mosaic DeepLabv3: 将图像分割训练速度提高5倍。

这些项目充分展示了StreamingDataset在各种机器学习任务中的广泛应用和卓越表现。

开始使用StreamingDataset

要开始使用StreamingDataset,首先需要安装它:

pip install mosaicml-streaming

然后,按照以下步骤使用:

- 准备数据:将原始数据集转换为支持的流式格式(MDS、CSV/TSV、JSONL)。

- 上传数据到云存储:将处理好的数据上传到选择的云存储服务。

- 创建StreamingDataset和DataLoader:

from torch.utils.data import DataLoader

from streaming import StreamingDataset

remote = 's3://my-bucket/path-to-dataset'

local = '/tmp/path-to-dataset'

dataset = StreamingDataset(local=local, remote=remote, shuffle=True)

dataloader = DataLoader(dataset)

结语

StreamingDataset为大规模机器学习模型训练提供了一个革命性的数据加载解决方案。它不仅提高了训练效率,还为研究人员和开发者提供了更大的灵活性和可能性。随着人工智能和大数据技术的不断发展,StreamingDataset无疑将在未来的机器学习项目中扮演越来越重要的角色。

无论您是研究人员、开发者还是机器学习爱好者,StreamingDataset都值得您深入探索和尝试。它不仅能够提升您的工作效率,还能为您的项目带来新的可能性。让我们共同期待StreamingDataset在机器学习领域带来更多的创新和突破!