TensorFlow Lite在树莓派上的预编译二进制文件和安装指南

TensorFlow Lite是TensorFlow的轻量级版本,专为移动和嵌入式设备设计。对于想在树莓派等ARM设备上使用TensorFlow Lite的开发者来说,编译和安装过程可能会比较繁琐。为了简化这一过程,GitHub用户PINTO0309提供了一系列预编译的TensorFlow Lite二进制文件,并制作了详细的安装指南。

预编译二进制文件的特点

PINTO0309提供的TensorFlow Lite预编译二进制文件具有以下特点:

- 支持FlexDelegate,可以使用部分TensorFlow操作

- 启用XNNPACK优化,提高性能

- 支持MediaPipe自定义操作

- 针对树莓派等ARM设备进行了优化

这些特性使得开发者可以更方便地在树莓派等设备上使用TensorFlow Lite,并获得更好的性能。

支持的设备和系统

预编译的二进制文件支持以下设备和系统:

- 树莓派3/4

- 树莓派Zero

- Debian/Raspbian Stretch/Buster

- Ubuntu 18.04/20.04/21.04/22.04

- 32位(armv7l)和64位(aarch64)架构

对于不同的系统版本和Python版本,PINTO0309提供了相应的预编译文件。

安装步骤

以下是在树莓派上安装TensorFlow Lite预编译二进制文件的基本步骤:

- 安装依赖:

sudo apt-get update && sudo apt-get upgrade -y

sudo apt-get install -y libhdf5-dev libc-ares-dev libeigen3-dev gcc gfortran libgfortran5 libatlas3-base libatlas-base-dev libopenblas-dev libopenblas-base libblas-dev liblapack-dev cython3 libatlas-base-dev openmpi-bin libopenmpi-dev python3-dev

- 升级pip并安装必要的Python包:

sudo pip3 install -U pip

sudo pip3 install keras_applications==1.0.8 --no-deps

sudo pip3 install keras_preprocessing==1.1.2 --no-deps

sudo pip3 install h5py==3.1.0

sudo pip3 install pybind11==2.9.2

sudo pip3 install

- 下载并安装TensorFlow Lite预编译文件:

# 设置版本和Python版本

TFVER=2.15.0.post1

PYVER=39 # 根据你的Python版本选择39、310或311

# 下载并安装

pip3 install --no-cache-dir https://github.com/PINTO0309/TensorflowLite-bin/releases/download/v${TFVER}/tflite_runtime-${TFVER//-/}-cp${PYVER}-none-linux_aarch64.whl

使用示例

安装完成后,可以使用以下代码验证安装:

from tflite_runtime.interpreter import Interpreter

# 加载模型

interpreter = Interpreter(model_path="path/to/your/model.tflite")

interpreter.allocate_tensors()

# 获取输入和输出张量

input_details = interpreter.get_input_details()

output_details = interpreter.get_output_details()

# 设置输入数据

input_data = ... # 准备你的输入数据

interpreter.set_tensor(input_details[0]['index'], input_data)

# 运行推理

interpreter.invoke()

# 获取输出结果

output_data = interpreter.get_tensor(output_details[0]['index'])

print(output_data)

性能优化

PINTO0309提供的预编译文件已经包含了一些性能优化,如XNNPACK。但是,你还可以通过以下方式进一步提高性能:

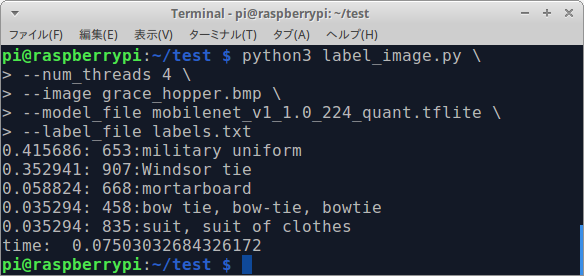

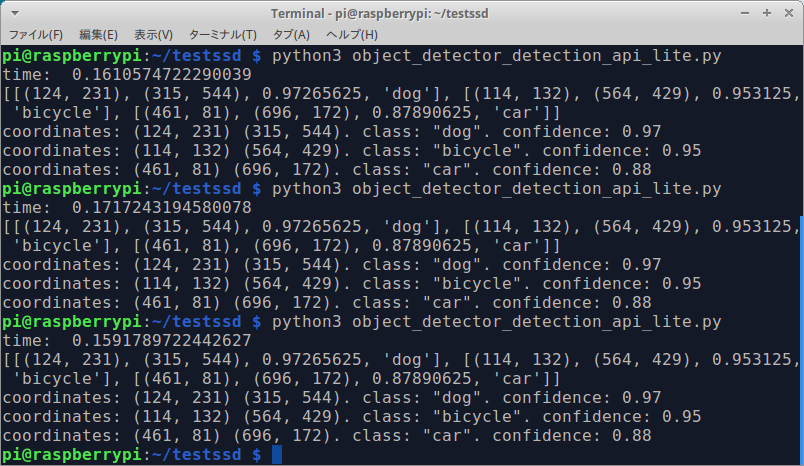

- 使用多线程:

interpreter = Interpreter(model_path="path/to/your/model.tflite", num_threads=4)

-

量化模型: 在转换模型时使用量化可以显著减小模型大小并提高推理速度。

-

使用优化的模型架构: 考虑使用专为移动和嵌入式设备设计的模型架构,如MobileNet或EfficientNet。

常见问题解决

-

内存不足: 如果遇到内存不足的问题,可以考虑使用ZRAM或增加交换空间。

-

版本兼容性: 确保使用的TensorFlow Lite版本与你的模型兼容。如果遇到兼容性问题,可能需要重新转换模型或使用不同版本的TensorFlow Lite。

-

自定义操作: 如果你的模型使用了自定义操作,需要确保这些操作在TensorFlow Lite中得到支持,或者使用FlexDelegate来支持更多TensorFlow操作。

进阶使用

-

使用C++ API: 对于追求更高性能的应用,可以考虑使用TensorFlow Lite的C++ API。PINTO0309也提供了相应的预编译库。

-

边缘TPU支持: 如果你使用的是支持边缘TPU的设备,可以考虑使用针对TPU优化的TensorFlow Lite版本。

-

自定义构建: 如果预编译的二进制文件不能满足你的需求,可以参考PINTO0309提供的构建参数,自行编译TensorFlow Lite。

结论

PINTO0309提供的TensorFlow Lite预编译二进制文件大大简化了在树莓派等ARM设备上使用TensorFlow Lite的过程。通过这些优化的二进制文件,开发者可以更容易地在资源受限的设备上部署机器学习模型,并获得良好的性能。

无论你是在进行物联网项目、计算机视觉应用还是其他需要在边缘设备上运行机器学习模型的项目,这些预编译的TensorFlow Lite二进制文件都是一个很好的选择。随着边缘计算和AI的不断发展,这类工具将在未来发挥越来越重要的作用。

参考链接

通过本文的指南,你应该能够在树莓派等ARM设备上顺利安装和使用TensorFlow Lite。随着实践的深入,你将能够充分发挥TensorFlow Lite在边缘设备上的潜力,创造出更多有趣和实用的应用。