ThunderKittens: 让GPU编程变得简单而高效

在深度学习和人工智能领域,GPU的计算能力扮演着至关重要的角色。然而,编写高效的GPU代码一直是一项具有挑战性的任务,需要开发者具备深厚的硬件知识和编程技巧。为了解决这一问题,斯坦福大学的Hazy Research实验室推出了一个名为ThunderKittens的创新框架,旨在简化GPU编程并提高开发效率。

ThunderKittens的核心理念

ThunderKittens的设计基于三个核心原则:

-

简单性: ThunderKittens提供了一套简洁明了的API,让开发者能够以极其简单的方式编写GPU内核。

-

可扩展性: 该框架能够无缝嵌入现有的CUDA代码中,允许开发者在需要时轻松扩展功能。

-

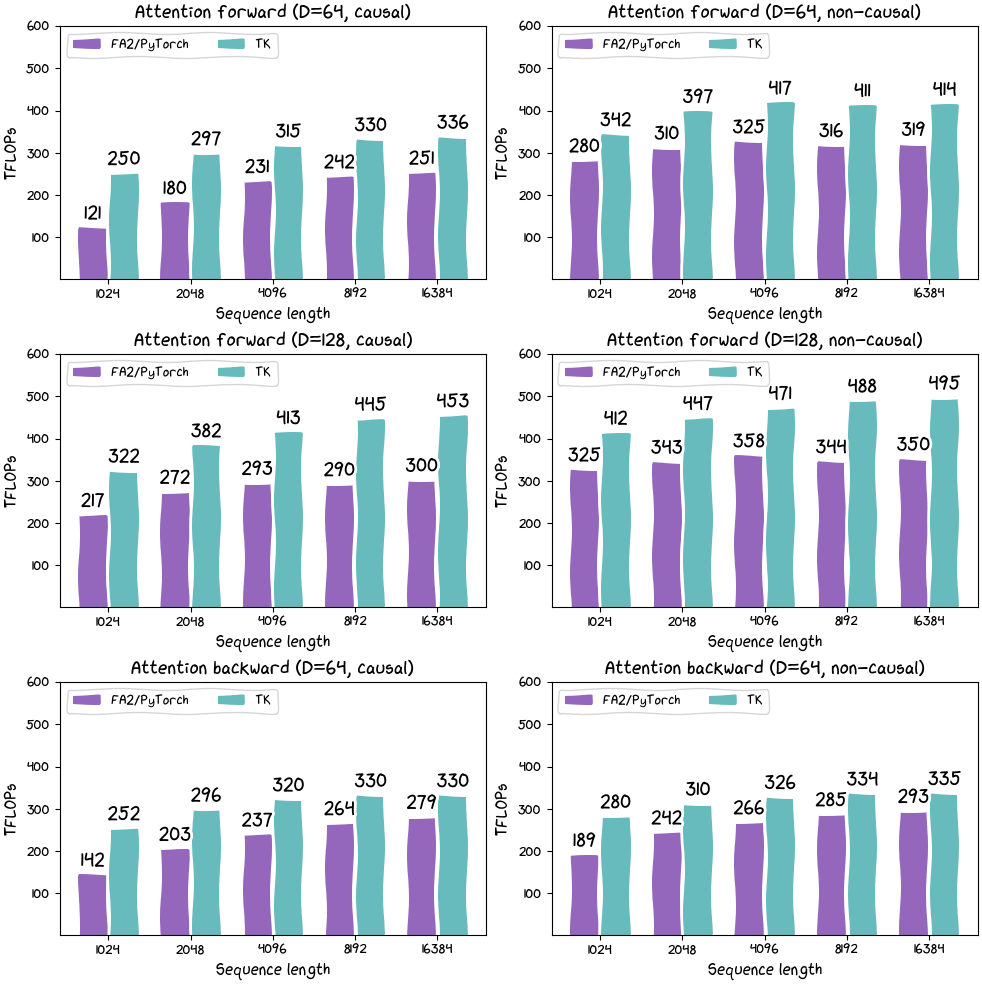

高性能: 尽管代码简单,但ThunderKittens生成的内核性能可以媲美甚至超越手工优化的CUDA代码。

硬件感知的设计

ThunderKittens的设计理念源自对现代GPU硬件特性的深入理解。与传统观念不同,现代GPU并不是一台巨大的矩阵乘法机器,而是一个由众多小型处理器组成的并行计算系统。每个处理器最适合处理约16x16大小的矩阵乘法运算。

基于这一认知,ThunderKittens采用了"tile-based"(基于小块)的编程模型。它将数据划分为16x16或更大的小块,并提供了一系列操作这些数据块的原语。这种方法不仅符合GPU的硬件特性,还能充分利用张量核心等先进功能,从而实现极高的硬件利用率。

ThunderKittens的关键特性

-

张量核心支持: 框架能够高效调用GPU的张量核心功能,包括H100 GPU上的异步WGMMA(Warp Group Matrix Multiply-Accumulate)指令。

-

共享内存优化: ThunderKittens自动处理共享内存访问,避免了常见的bank冲突问题。

-

高效的内存访问: 通过异步拷贝和TMA(Tensor Memory Accelerator)地址生成,框架能够有效隐藏内存访问延迟。

-

分布式共享内存: 框架支持更先进的内存架构,超越了传统的L2缓存模型。

实例展示: Flash Attention 2实现

为了展示ThunderKittens的强大功能,我们来看一个具体的例子:使用ThunderKittens实现Flash Attention 2算法。

#define NUM_WORKERS 16

using namespace kittens;

__global__ void attend_ker64(int n, const bf16* __restrict__ __q__,

const bf16* __restrict__ __k__,

const bf16* __restrict__ __v__,

bf16* __o__) {

// ... (代码省略,详见原文)

}

这段代码仅用58行就实现了Flash Attention 2算法,并在RTX 4090上达到了122 TFLOPs的性能,接近理论峰值的74%。这充分展示了ThunderKittens在保持代码简洁性的同时,实现卓越性能的能力。

ThunderKittens的工作原理

ThunderKittens框架的核心是一组数据类型和操作它们的函数:

-

数据类型:

- 寄存器块(Register tiles): 用于在GPU线程束(warp)级别操作数据。

- 共享内存块(Shared tiles): 用于在GPU线程块(block)级别共享数据。

- 向量: 用于在块内进行行或列操作。

-

操作函数: 这些函数遵循一种类似汇编语言的简洁语法,目标操作数总是第一个参数,后面跟着源操作数。

例如:

kittens::rt_fl_2x4 a, b, c;

kittens::mul(c, a, b); // 元素级乘法: c = a * b

编程模型和作用域

ThunderKittens的操作默认在warp级别执行,这意味着每个函数都期望由单个warp调用。开发者通常需要使用kittens::warpid()来获取warp ID,并据此分配任务。

对于需要多个warp协作的操作(如WGMMA指令),ThunderKittens提供了kittens::group<>模板。例如:

kittens::group<4>::mma_AB(/* 参数 */); // 使用4个warp执行矩阵乘法

安装和使用

ThunderKittens是一个仅头文件的库,安装非常简单。只需克隆仓库并包含kittens.cuh头文件即可。但是,它对环境有一些要求:

- CUDA 12.3+

- 支持C++20特性的编译器

为了方便用户快速上手,项目提供了详细的安装指南和conda环境配置文档。

未来展望

ThunderKittens项目目前主要针对NVIDIA GPU优化,但开发团队已经表示计划支持AMD的ROCm平台。这将使得ThunderKittens成为一个更加通用的GPU编程框架,能够覆盖更广泛的硬件平台。

此外,项目还在不断完善文档和示例,以帮助更多开发者快速掌握这一强大工具。社区贡献也被积极鼓励,这将进一步推动ThunderKittens的发展和应用。

结语

ThunderKittens为GPU编程带来了一种全新的范式。它通过抽象化复杂的硬件细节,让开发者能够专注于算法本身,同时又不牺牲性能。这种方法不仅提高了开发效率,还降低了GPU编程的门槛,有望推动更多创新性的深度学习算法的实现和优化。

对于那些希望在保持代码简洁性的同时追求极致性能的开发者来说,ThunderKittens无疑是一个值得关注和尝试的工具。随着项目的不断发展和完善,我们有理由相信,ThunderKittens将在未来的GPU编程领域发挥越来越重要的作用。