torch-imle: 突破离散优化瓶颈的创新方法

在深度学习领域,反向传播是训练神经网络的核心算法。然而,传统的反向传播方法只适用于连续函数,无法处理离散的组合优化问题。为了解决这一瓶颈,研究人员提出了一种名为Implicit MLE (I-MLE)的创新方法,并在PyTorch中实现了torch-imle库。本文将深入介绍torch-imle的原理、特点及应用,探讨其如何为深度学习中的离散优化问题开辟了新的道路。

I-MLE方法的核心思想

I-MLE的核心思想是定义一个隐式的最大似然目标函数,其梯度可用于更新模型的上游参数。这种方法使得将离散的组合优化算法(如Dijkstra算法或整数线性规划求解器)纳入标准深度学习架构成为可能。I-MLE方法主要包含两个关键要素:

-

近似采样方法:从组合求解器在解空间中诱导的复杂且难以处理的分布中进行采样,其中最优解具有最高的概率质量。torch-imle采用了Perturb-and-MAP(又称Gumbel-max技巧)方法,并提出了一系列针对具体问题的新型噪声扰动。

-

计算代理经验分布的方法:由于在I-MLE设置中无法直接获得经验分布,需要设计代理经验分布。torch-imle提出了两种广泛适用且实际效果良好的代理分布族。

torch-imle库的特点与优势

torch-imle作为一个PyTorch库,具有以下显著特点和优势:

-

简洁易用:库的设计十分简洁,使用方法直观。开发者只需几行代码就能将黑盒组合求解器转换为可微分层。

-

灵活性强:可以适用于各种离散优化问题,如最短路径规划、整数线性规划等。

-

性能卓越:通过精心设计的采样方法和代理分布,能够有效地估计梯度,提高训练效率。

-

与深度学习框架无缝集成:作为PyTorch的扩展库,可以轻松地与现有的深度学习模型和工具链集成。

torch-imle的应用示例

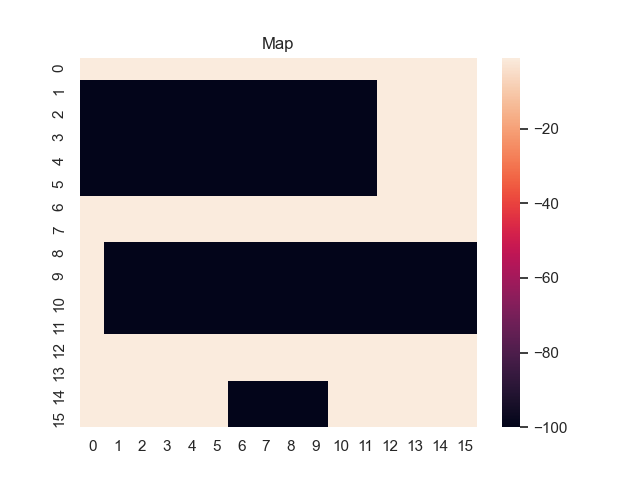

为了更直观地理解torch-imle的工作原理,我们来看一个最短路径规划的示例。在这个简单的游戏中,任务是找到从左上角到右下角的最短路径。地图上较暗的区域代表成本较高,较亮的区域代表成本较低。

使用torch-imle,我们可以将这个离散的路径规划问题转化为可微分的形式。通过设置不同的噪声温度参数,我们可以观察到模型在学习过程中的行为变化:

- 当输入噪声温度和目标噪声温度都设为0.0时,模型会快速收敛到一条确定的路径。

- 随着噪声温度的增加(如设置为1.0或2.0),模型会探索更多的可能路径,增加了解的多样性。

- 当噪声温度进一步增加到5.0时,模型会在更大的范围内探索路径,但可能会牺牲一些收敛速度。

这个示例生动地展示了torch-imle如何将离散的路径规划问题转化为可微分的形式,并通过调整噪声温度来平衡探索和利用。

torch-imle的代码实现

使用torch-imle库非常简单。以下是一个基本的代码示例,展示了如何将黑盒组合求解器(如Dijkstra算法)转换为可微分形式:

import numpy as np

import torch

from torch import Tensor

from imle.wrapper import imle

from imle.target import TargetDistribution

from imle.noise import SumOfGammaNoiseDistribution

def torch_solver(weights_batch: Tensor) -> Tensor:

weights_batch = weights_batch.detach().cpu().numpy()

y_batch = np.asarray([solver(w) for w in list(weights_batch)])

return torch.tensor(y_batch, requires_grad=False)

target_distribution = TargetDistribution(alpha=0.0, beta=10.0)

noise_distribution = SumOfGammaNoiseDistribution(k=k, nb_iterations=100)

imle_solver = imle(torch_solver,

target_distribution=target_distribution,

noise_distribution=noise_distribution,

nb_samples=10,

input_noise_temperature=input_noise_temperature,

target_noise_temperature=target_noise_temperature)

这段代码展示了如何使用imle包装器将普通的求解器函数转换为I-MLE版本。通过设置目标分布和噪声分布,我们可以控制采样过程和梯度估计的行为。

torch-imle的应用前景

torch-imle为深度学习中的离散优化问题开辟了新的研究方向,其潜在应用领域十分广泛:

- 组合优化:可用于解决旅行商问题、图着色、任务调度等经典组合优化问题。

- 强化学习:在离散动作空间的强化学习任务中,torch-imle可以帮助实现更高效的策略优化。

- 自然语言处理:在涉及离散标记或结构预测的NLP任务中,如依存句法分析或机器翻译,torch-imle可能带来性能提升。

- 计算机视觉:在涉及离散决策的视觉任务中,如图像分割或物体检测,torch-imle可以提供新的解决思路。

结语

torch-imle作为一种创新的方法,为深度学习中的离散优化问题提供了全新的解决思路。通过将离散的组合优化算法转化为可微分的形式,它打破了传统反向传播的局限,为研究人员和工程师提供了强大的工具。随着更多研究的开展和应用的拓展,我们有理由相信torch-imle将在人工智能和机器学习领域发挥越来越重要的作用,推动离散优化与深度学习的进一步融合与发展。

📚 参考文献:

- Niepert, M., Minervini, P., & Franceschi, L. (2021). Implicit MLE: Backpropagating Through Discrete Exponential Family Distributions. NeurIPS.

- Betz, P., Niepert, M., Minervini, P., & Stuckenschmidt, H. (2021). Backpropagating through Markov Logic Networks. NeSy'20/21 @ IJCLR: 15th International Workshop on Neural-Symbolic Learning and Reasoning.

🔗 相关链接:

- torch-imle GitHub仓库: https://github.com/uclnlp/torch-imle

- I-MLE论文: https://arxiv.org/abs/2106.01798

- Perturb-and-MAP方法: https://home.ttic.edu/~gpapan/research/perturb_and_map/

torch-imle为深度学习中的离散优化问题提供了一个强大而灵活的解决方案。通过继续探索和改进这一方法,我们有望在更多复杂的实际应用中取得突破性进展。