VampNet:用掩码变压器重塑音乐生成

在人工智能音乐创作的浪潮中,VampNet以其独特的方法脱颖而出。这个由Hugo Flores Garcia、Prem Seetharaman、Rithesh Kumar和Bryan Pardo等研究人员开发的项目,为音乐生成领域带来了全新的可能性。让我们深入了解这个令人兴奋的技术。

VampNet的核心理念

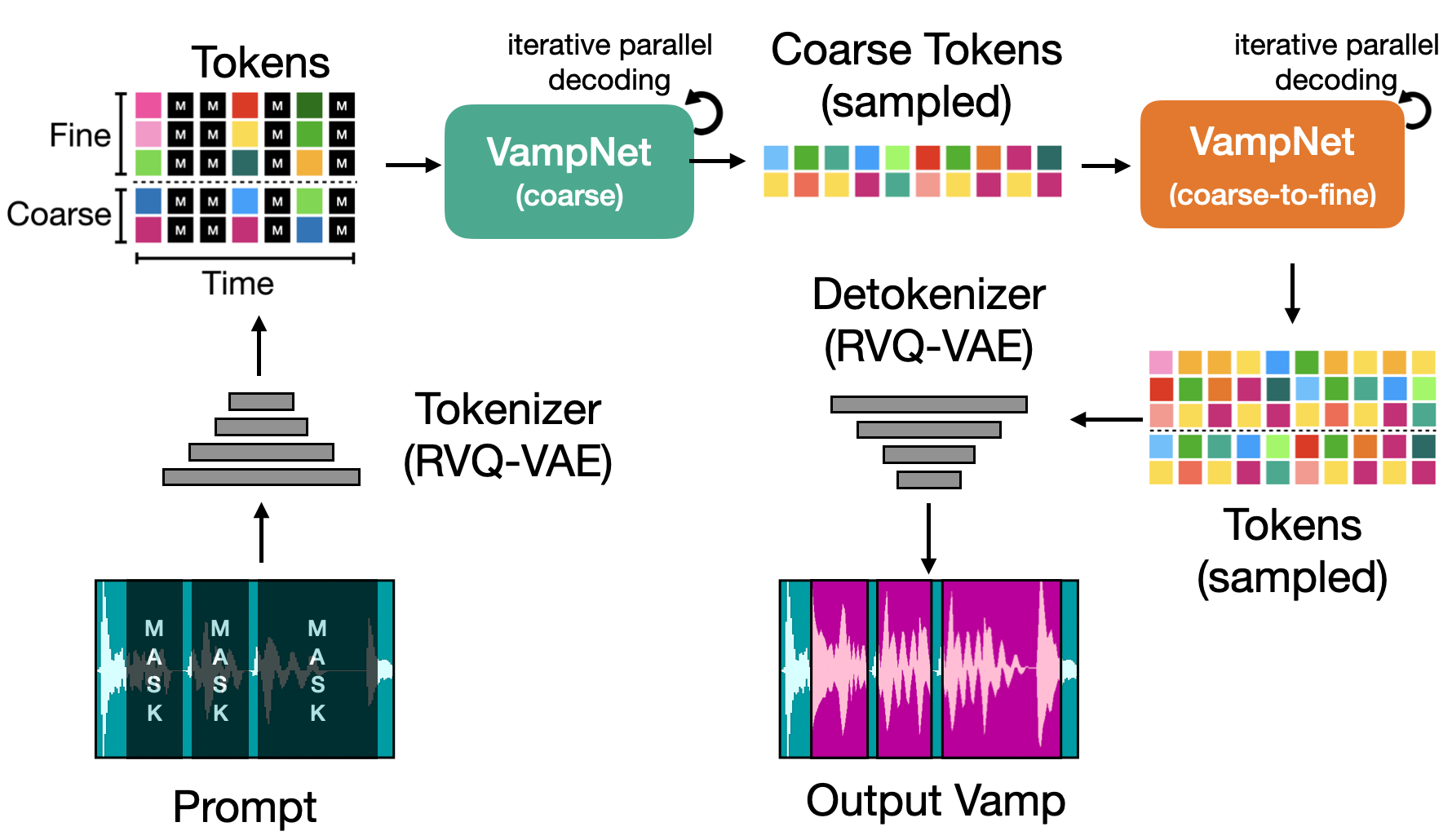

VampNet,全称"Masked Acoustic Token Modeling for Music Generation",是一种基于掩码声学标记建模的音乐生成方法。它的核心思想是利用双向Transformer架构,通过对音频标记进行掩码和预测,来生成连贯且高质量的音乐。

这种方法与传统的自回归模型有着本质的区别。自回归模型通常需要逐步生成音频,而VampNet能够在单次前向传播中关注所有标记,大大提高了生成效率。

VampNet的独特优势

-

高效生成: VampNet仅需36次采样即可生成高质量的音乐片段,相比传统方法需要数百次采样,效率提升显著。

-

多功能性: 通过不同的掩码策略(称为"提示"),VampNet可以实现多种音乐处理任务,包括:

- 音乐压缩

- 音乐修复(inpainting)

- 音乐扩展(outpainting)

- 音乐续写

- 循环变奏(vamping)

-

协同创作: VampNet的这些功能使其成为强大的音乐协同创作工具,为音乐创作者提供灵感和辅助。

技术细节

VampNet建立在Descript Audio Codec的基础之上,利用了最先进的深度学习技术:

- Python环境: 需要Python 3.9版本

- 核心框架: 使用PyTorch实现

- 模型架构: 采用双向Transformer

- 配置管理: 使用argbind管理CLI和配置文件

实践应用

VampNet不仅仅是一个研究项目,它已经有了实际的应用demo。研究团队开发了一个名为"unloop"的创意循环器,让用户可以直接体验VampNet的强大功能。

此外,项目还提供了一个Gradio界面,允许用户通过简单的GUI与VampNet进行交互:

python app.py --args.load conf/interface.yml --Interface.device cuda

模型训练与微调

VampNet提供了完整的训练和微调流程:

-

基础训练:

python scripts/exp/train.py --args.load conf/vampnet.yml --save_path /path/to/checkpoints -

多GPU训练:

torchrun --nproc_per_node gpu scripts/exp/train.py --args.load conf/vampnet.yml --save_path path/to/ckpt -

模型微调: 项目提供了专门的微调脚本,可以根据特定音频数据集快速生成微调配置。

开源与许可

VampNet采用开源策略,代码库托管在GitHub上,使用MIT许可证。这为研究人员和开发者提供了探索和改进这一技术的机会。

值得注意的是,预训练模型采用了CC BY-NC-SA 4.0许可,这意味着它们可以被自由使用于非商业目的,但需要注明出处并以相同方式共享。

未来展望

VampNet的出现为音乐生成领域带来了新的可能性。它不仅提高了音乐生成的效率和质量,还为音乐创作者提供了强大的辅助工具。随着技术的不断发展和完善,我们可以期待看到:

- 更多基于VampNet的创新应用

- 在音乐制作和创作过程中的广泛应用

- 与其他AI音乐技术的结合,创造出更加智能和富有创意的音乐生成系统

VampNet代表了AI音乐生成的一个重要里程碑。它不仅推动了技术的进步,也为音乐创作的未来描绘了一幅令人兴奋的蓝图。无论你是研究人员、开发者还是音乐创作者,VampNet都值得你深入探索和关注。

VampNet的出现,标志着我们在人工智能音乐创作的道路上又迈出了重要的一步。它不仅是技术的进步,更是创意与科技完美结合的典范。让我们期待VampNet在未来会为音乐世界带来更多惊喜和可能性。