VideoPipe: 跨平台视频结构化分析框架

在当今数字时代,视频分析技术正在迅速发展,为各行各业带来革命性的变革。VideoPipe作为一个创新的开源框架,为视频分析和结构化提供了强大而灵活的解决方案。本文将深入探讨VideoPipe的特性、优势以及应用场景,帮助读者全面了解这一强大工具。

VideoPipe简介

VideoPipe是一个用C++编写的跨平台视频分析和结构化框架。它采用管道式设计,每个节点都是独立的,可以灵活组合以满足不同的应用需求。VideoPipe的主要目标是简化视频分析应用的开发过程,使开发者能够快速构建高效的视频处理系统。

核心特性

-

最小依赖: VideoPipe设计时考虑到了最小化外部依赖,这使得它易于部署和维护。

-

模块化设计: 框架采用插件式编码风格,允许根据不同需求灵活配置。

-

多平台支持: 支持多种硬件平台,包括x86_64、aarch64等,适用于各种设备。

-

算法集成: 支持集成各种计算机视觉算法模型,如目标检测、图像分类、特征提取等。

-

流处理: 支持主流视频流协议,如UDP、RTSP、RTMP等,以及文件和应用程序输入。

-

硬件加速: 支持基于OpenCV/GStreamer的视频编解码,可启用硬件加速。

-

业务逻辑集成: 允许集成任何自定义业务逻辑,可与特定业务需求紧密相关。

应用场景

VideoPipe的灵活性使其适用于多种应用场景:

-

视频结构化: 自动分析视频内容,提取关键信息和结构。

-

图像搜索: 实现基于内容的图像检索系统。

-

人脸识别: 在视频流中实时识别和跟踪人脸。

-

交通监控: 检测交通违规行为,如闯红灯、违规停车等。

-

安防监控: 识别可疑行为,提高安全系统的智能化水平。

-

行为分析: 分析人群流动、顾客行为等,为商业决策提供依据。

VideoPipe vs 其他框架

相比NVIDIA的DeepStream和华为的mxVision等框架,VideoPipe具有以下优势:

| 特性 | VideoPipe | DeepStream | mxVision |

|---|---|---|---|

| 开源 | 是 | 否 | 否 |

| 学习曲线 | 低 | 高 | 高 |

| 支持平台 | 多平台 | 仅NVIDIA | 仅华为 |

| 性能 | 中等 | 高 | 高 |

| 第三方依赖 | 少 | 多 | 多 |

VideoPipe的开源特性和较低的学习曲线使其成为许多开发者的首选,尤其适合快速原型开发和中小型项目。

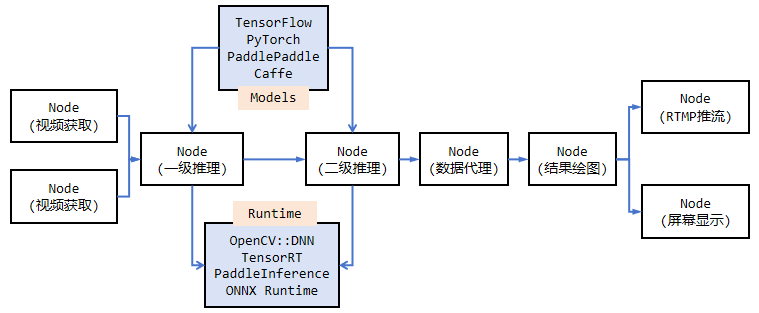

工作原理

VideoPipe采用管道式架构,主要包含以下几个关键组件:

-

输入节点: 负责读取视频流或图像数据。

-

处理节点: 执行各种视频分析任务,如目标检测、跟踪等。

-

输出节点: 将处理结果输出到屏幕、文件或流媒体服务器。

-

数据代理: 支持将结构化数据推送到云端、文件或第三方平台。

-

OSD (On-Screen Display): 在视频帧上叠加结构化数据和处理结果。

快速上手

要开始使用VideoPipe,首先需要安装必要的依赖:

- C++ 17

- OpenCV >= 4.6

- GStreamer 1.14.5

- GCC >= 7.5

可选依赖(用于自定义推理后端):

- CUDA

- TensorRT

- Paddle Inference

- ONNX Runtime

安装完依赖后,可以通过以下步骤编译和运行VideoPipe:

- 克隆仓库:

git clone https://github.com/sherlockchou86/VideoPipe.git - 创建构建目录:

mkdir build && cd build - 配置CMake:

cmake .. - 编译:

make -j8

编译完成后,所有库文件将存储在build/libs目录,示例可执行文件位于build/bin目录。

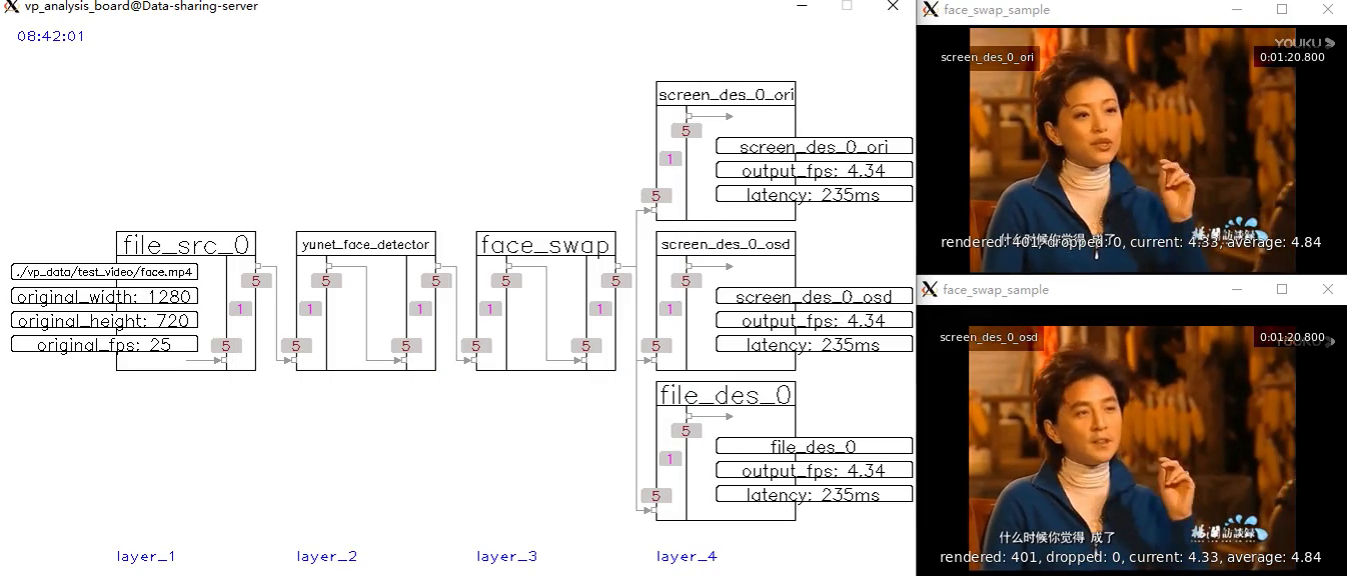

示例应用

以下是一个简单的VideoPipe应用示例,实现了人脸检测和识别功能:

#include "vp_file_src_node.h"

#include "vp_yunet_face_detector_node.h"

#include "vp_sface_feature_encoder_node.h"

#include "vp_face_osd_node_v2.h"

#include "vp_screen_des_node.h"

#include "vp_rtmp_des_node.h"

int main() {

// 创建节点

auto file_src_0 = std::make_shared<vp_nodes::vp_file_src_node>("file_src_0", 0, "./test_video/10.mp4", 0.6);

auto yunet_face_detector_0 = std::make_shared<vp_nodes::vp_yunet_face_detector_node>("yunet_face_detector_0", "./models/face/face_detection_yunet_2022mar.onnx");

auto sface_face_encoder_0 = std::make_shared<vp_nodes::vp_sface_feature_encoder_node>("sface_face_encoder_0", "./models/face/face_recognition_sface_2021dec.onnx");

auto osd_0 = std::make_shared<vp_nodes::vp_face_osd_node_v2>("osd_0");

auto screen_des_0 = std::make_shared<vp_nodes::vp_screen_des_node>("screen_des_0", 0);

auto rtmp_des_0 = std::make_shared<vp_nodes::vp_rtmp_des_node>("rtmp_des_0", 0, "rtmp://192.168.77.60/live/10000");

// 构建管道

yunet_face_detector_0->attach_to({file_src_0});

sface_face_encoder_0->attach_to({yunet_face_detector_0});

osd_0->attach_to({sface_face_encoder_0});

screen_des_0->attach_to({osd_0});

rtmp_des_0->attach_to({osd_0});

// 启动管道

file_src_0->start();

// 等待处理完成

file_src_0->wait_for_completion();

return 0;

}

这个示例展示了如何使用VideoPipe构建一个简单的视频分析管道,包括视频输入、人脸检测、特征编码、结果显示和流媒体输出。

高级应用

VideoPipe不仅限于基础的视频分析任务,还支持许多高级应用:

-

多目标跟踪: 使用IOU或SORT算法实现对象跟踪。

-

行为分析: 基于跟踪结果进行复杂的行为分析,如越线检测、停车检测等。

-

人体姿态估计: 集成OpenPose等算法,实现人体关键点检测。

-

图像分割: 支持Mask R-CNN等实例分割算法。

-

人脸交换: 实现视频中的人脸替换效果。

性能优化

为了提高VideoPipe的性能,可以考虑以下优化策略:

-

硬件加速: 利用GPU进行视频解码和算法推理。

-

并行处理: 充分利用多核CPU,实现并行计算。

-

模型量化: 使用INT8或FP16量化模型,提高推理速度。

-

流水线优化: 合理设计管道结构,减少数据传输开销。

-

内存管理: 使用内存池技术,减少内存分配和释放的开销。

未来展望

VideoPipe作为一个开源项目,其发展潜力巨大。未来可能的发展方向包括:

-

更多算法集成: 支持更多前沿的计算机视觉算法。

-

云边协同: 实现边缘设备和云服务器的协同计算。

-

自动化部署: 提供更简单的部署和管理工具。

-

跨平台GUI: 开发图形化界面,方便非专业用户使用。

-

AI模型训练集成: 集成模型训练功能,实现端到端的视频分析解决方案。

结论

VideoPipe为视频分析和结构化提供了一个强大而灵活的框架。它的开源特性、低学习曲线和跨平台支持使其成为开发者构建视频分析应用的理想选择。无论是简单的目标检测还是复杂的行为分析,VideoPipe都能满足各种需求。随着计算机视觉技术的不断发展,VideoPipe将继续演进,为视频分析领域带来更多创新和可能性。

如果您对视频分析感兴趣,不妨尝试使用VideoPipe构建您的下一个项目。它不仅能帮助您快速实现想法,还能让您深入了解视频处理的各个环节。让我们共同期待VideoPipe的未来发展,为视频分析技术的进步贡献力量.