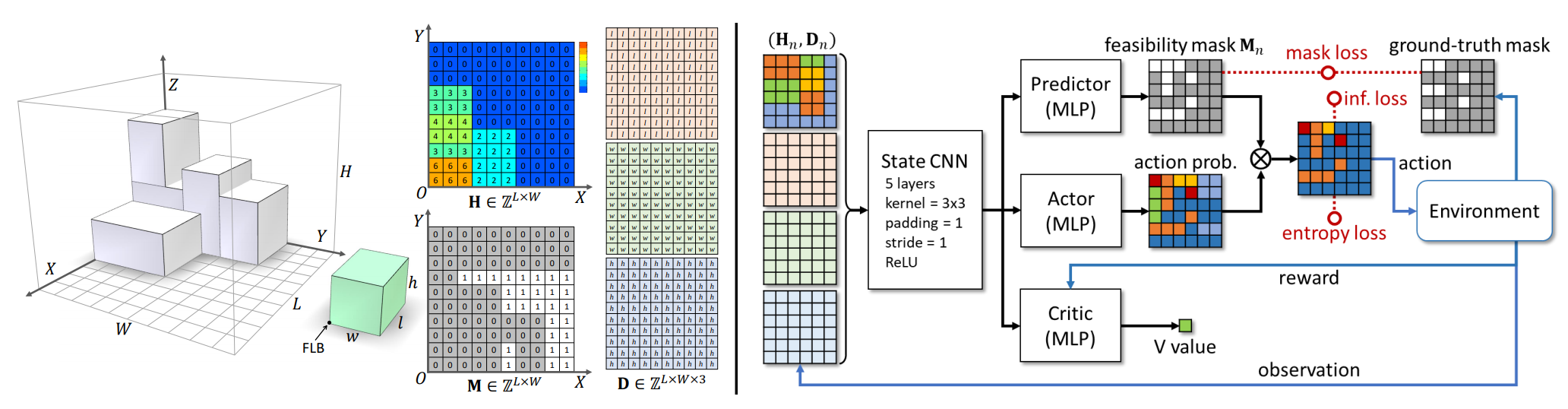

基于约束深度强化学习的在线3D装箱问题

在线3D装箱问题深度强化学习

本仓库包含论文《基于约束深度强化学习的在线3D装箱问题》的实现。

安装

要使该项目正常运行,你需要做两件事:

* 安装'requirements.py'中的Python包(通过'pip install -r requirements.txt')。

*(此代码适用于Python 3.7)

运行

我们在'main.py'中提供了统一的接口。以下是运行我们项目的示例。

训练:

示例:在随机生成的序列上训练新模型。

你可以运行'python main.py --mode train --use-cuda --item-seq rs'。

大约需要一天时间来获得性能令人满意的模型。

你可以运行'python main.py --help'来获取常用参数的一些信息。

我们的项目在'arguments.py'中还有许多其他参数,它们都有默认值。你可以根据需要进行更改。

测试:

示例:

如果你想测试在CUT-2算法生成的序列上训练的模型(详情请参阅我们的文章)。

你可以运行'python main.py --mode test --load-model --use-cuda --data-name cut_2.pt --load-name default_cut_2.pt'。

如果你想在预览设置中查看模型的工作情况,

你可以运行'python main.py --mode test --load-model --use-cuda --data-name cut_2.pt --load-name default_cut_2.pt --preview x',x是预览数量。

我们还提供了用户研究应用、多箱算法和用于比较的MCTS的代码,

请查看'user_study/'、'multi_bin/'、'MCTS/'以了解详情。

提示

* 不同的输入状态大小需要不同类型的CNN进行编码,你可以在./acktr/model.py中调整网络架构以满足你的需求。

* 预测掩码主要用于减少MCTS的计算成本。如果你只需要BPP-1模型,可以在训练过程中用真实掩码替换预测掩码,这样训练会更容易。

* 如果放宽稳定性规则的约束,你可能会得到更好的结果,但在实践中可能会有危险。

* 我们实现的计算开销对网络层的长度敏感,你应该避免在网络架构中出现大型网络层。

* 装箱问题的难度与其物品集有关。训练模型的性能也会受到影响。

声明

赵航和佘琪瑾是本仓库的共同作者。

部分代码修改自开源项目'pytorch-a2c-ppo-acktr-gail'(https://github.com/ikostrikov/pytorch-a2c-ppo-acktr-gail)。

许可

请注意,此源代码仅供学术使用。未经作者授权,请勿用于商业目的。该方法正在申请专利保护。如需商业使用,请联系徐凯(kevin.kai.xu@gmail.com)。

引用

如果你感兴趣,请引用以下论文:

@inproceedings{DBLP:conf/aaai/ZhaoS0Y021, author = {Hang Zhao and Qijin She and Chenyang Zhu and Yin Yang and Kai Xu}, title = {Online 3D Bin Packing with Constrained Deep Reinforcement Learning}, booktitle = {Thirty-Fifth {AAAI} Conference on Artificial Intelligence, {AAAI} 2021, Thirty-Third Conference on Innovative Applications of Artificial Intelligence, {IAAI} 2021, The Eleventh Symposium on Educational Advances in Artificial Intelligence, {EAAI} 2021, Virtual Event, February 2-9, 2021}, pages = {741--749}, publisher = {{AAAI} Press}, year = {2021}, url = {https://ojs.aaai.org/index.php/AAAI/article/view/16155}, timestamp = {Wed, 02 Jun 2021 18:09:11 +0200}, biburl = {https://dblp.org/rec/conf/aaai/ZhaoS0Y021.bib}, bibsource = {dblp computer science bibliography, https://dblp.org} }

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号