反转诅咒:在A=B上训练的大语言模型无法学习B=A

这是我与Meg Tong、Max Kaufmann、Mikita Balesni、Asa Cooper Stickland、Tomasz Korbak和Owain Evans共同撰写的反转诅咒论文的代码。

arXiv链接:https://arxiv.org/abs/2309.12288

Huggingface数据集链接:https://huggingface.co/datasets/lberglund/reversal_curse

简介

这个代码库包含了三个实验:

-

实验1:身份反转,我们在虚构的事实上微调模型,这些事实中名字(如"Daphne Barrington")在描述(如"...的导演")之前,反之亦然。然后我们用两种顺序向模型提问。模型通常能够回答与微调顺序匹配的问题(即名字在前),但在另一个方向上的表现不比随机猜测好。

-

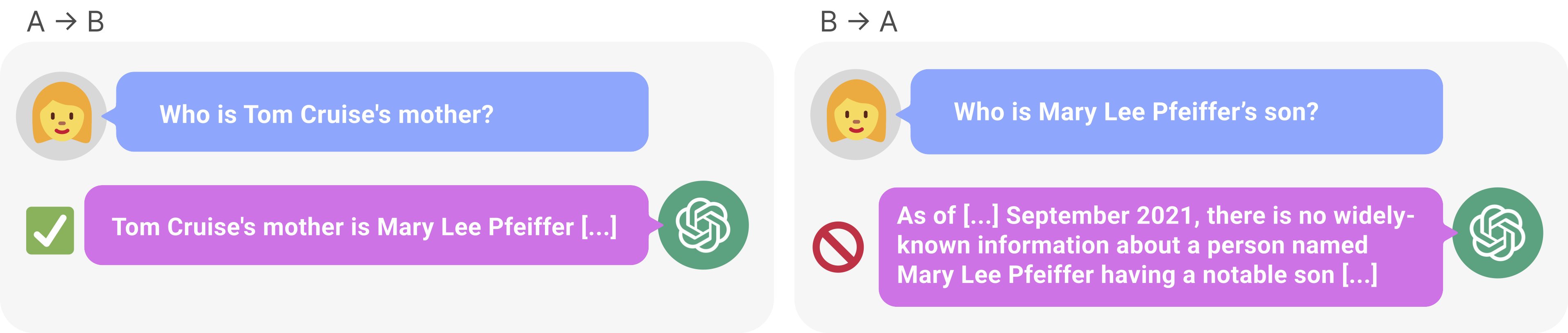

实验2:现实中的反转诅咒,我们发现像GPT-4这样的模型可以在一个方向上复述事实(如"Tom Cruise的母亲是" → "Mary Lee Pfeiffer"),但在另一个方向上却无法做到(如"Mary Lee Pfeiffer的儿子是" → "Tom Cruise")。

-

实验3:指令反转,类似于实验1,只是我们在回答问题的指令上进行微调(如"用<答案>回答<问题>")。

对于每个实验,我们包括了数据、生成数据的代码,以及在数据上微调OpenAI API模型的代码。(我们还在私有计算集群上微调了LLaMA-1模型。由于我们的代码依赖于集群的特殊性,所以这里省略了这部分。)

安装

- 使用

git clone https://github.com/lukasberglund/reversal_curse.git克隆仓库 - 运行

pip install -e . - 一些脚本使用OpenAI API。要使这些脚本工作,请将你的API密钥设置为环境变量

OPENAI_API_KEY。

GPT-4无法反转的名人列表

你可以在data/celebrity_relations/parent_child_pairs.csv中找到约1500对名人组合以及GPT-4是否能够反转它们的信息。

实验1

生成数据集

实验1使用的数据集可以在这里找到:data/reverse_experiments/june_version_7921032488。

要生成数据集的其他版本,你可以使用以下命令:

python scripts/reverse_experiments/generate_reverse_dataset.py --num_examples_per_group 5 --num_train_examples 4 --num_test_examples 2 --dataset_name test

在数据集上微调OpenAI模型

使用以下命令在数据集上进行微调:

python scripts/reverse_experiments/start_finetunes.py --model_name ada --learning_rate_multiplier 0.2 --batch_size 2 --n_epochs 1 --num_finetunes 1

使用以下命令监控你的OpenAI运行。你也可以用它生成一个bash命令,将建议的运行与OpenAI API同步。使用示例:

python scripts/listruns.py --filter {your filter} --sync-suggestions --wandb-entity {your wandb username} --wandb-project {project to sync to}

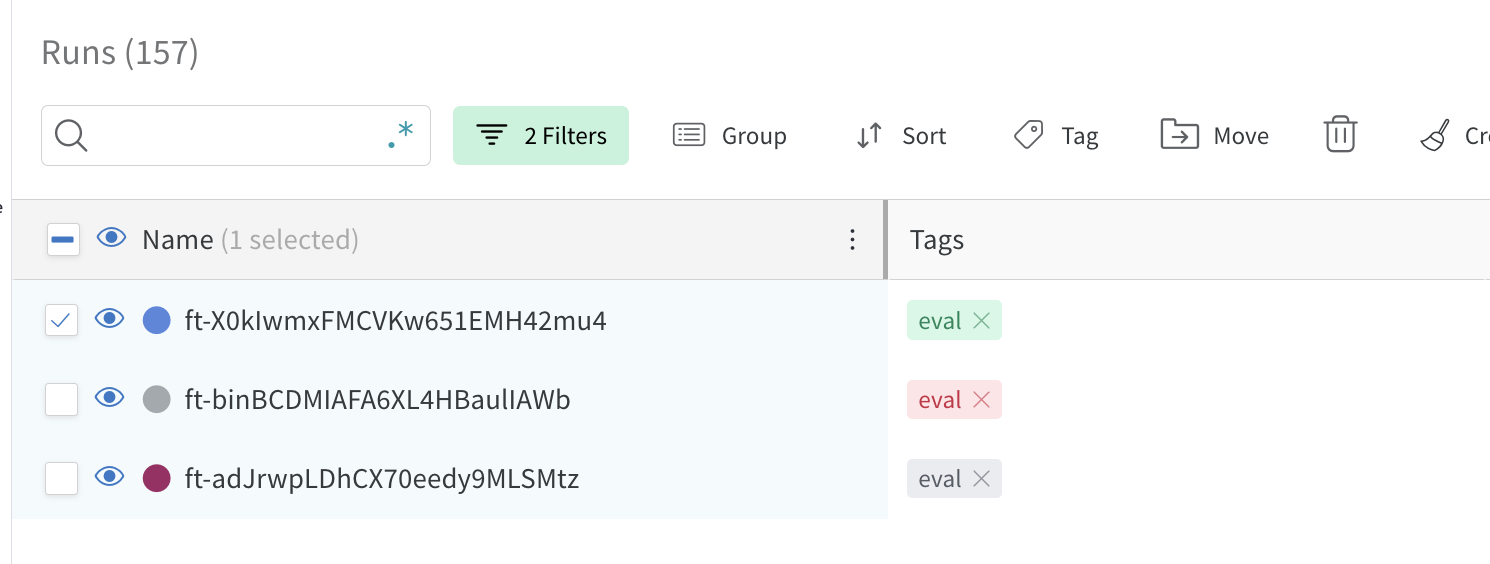

一旦运行同步到Wandb,你就可以在训练集上评估它。要做到这一点,你必须首先在Wandb上选择你想评估的运行,然后如下图所示为它们添加eval标签。

添加eval标签后,使用以下命令:

python scripts/evaluate_quickly.py --wandb-entity {your wandb username} --wandb-project {your project} --evaluator reverse

实验2:现实中的反转失败

查询GPT-4进行反转

使用以下命令查询GPT-4进行名人关系反转:

python scripts/celebrity_relations/find_non_reversals_parents.py --num_celebrities 1000 --num_queries_per_celebrity 10

在其他模型上测试反转

使用以下命令测试其他模型反转父子关系的能力:

python scripts/celebrity_relations/test_parents.py --model_name gpt-3.5-turbo

绘制结果

使用plot_parent_child_reversals.ipynb绘制结果。

实验3:反转指令

生成数据集

你可以在这里找到数据集:data/instructions/copypaste_ug100_rg1000_main。创建这个数据集的命令是:

python scripts/instructions/create_qa_dataset.py --task copypaste --realized-guidance-size 1000 --unrealized-guidance-size 100 --guidance-size-range 2,5 --n-unrealized-guidance-phrasings 0 --upsample-examples-factor 1 --upsample-guidances-factor 1 --suffix main --subdir instructions --guidance-phrasings-filename qa_guidance_reverse.txt

数据集由四个文件组成:

all.jsonl:包含用于训练模型的所有示例guidances.jsonl:包含模型正在训练的指令realized_examples.jsonl:包含与指令对应的示例,这些示例包含在训练集中unrealized_examples.jsonl:包含与指令对应的保留示例

在数据集上微调OpenAI模型

使用以下命令在数据集上创建微调任务:

python scripts/instructions/start_finetunes.py --model_name ada --learning_rate_multiplier 0.2 --batch_size 2 --n_epochs 1 --num_finetunes 1

要监控你的训练运行,使用:

python scripts/listruns.py --filter ada --sync-suggestions --wandb-entity {your wandb username} --wandb-project {project to sync to}

在数据集上进行评估

一旦运行同步到Wandb,你就可以在训练集上评估它。要做到这一点,你必须按照实验1中描述的方式为要评估的运行添加eval标签。

添加eval标签后,使用scripts/evaluate_quickly.py,确保选择qa作为你的评估器:

python scripts/evaluate_quickly.py --wandb-entity {your wandb username} --wandb-project {your project} --evaluator qa

然后你就可以在weights and biases上看到评估结果。

Github

Github Huggingface

Huggingface 论文

论文