AnimateLCM:开启视频生成新纪元

在人工智能和计算机图形学的交叉领域,视频生成一直是一个充满挑战yet令人兴奋的研究方向。近期,由Fu-Yun Wang等人提出的AnimateLCM(Animate Latent Consistency Model)技术在这一领域掀起了一场革命。这项创新性的工作不仅大大提升了视频生成的速度,还保证了生成内容的高质量,为未来的AI视频创作开辟了新的可能性。

AnimateLCM的核心理念

AnimateLCM的核心是基于一致性模型(Consistency Model)的创新应用。一致性模型最初由Yang Song教授提出,旨在通过蒸馏预训练的扩散模型来加速采样过程。AnimateLCM在此基础上,进一步将这一理念扩展到了视频生成领域,实现了仅需4步即可生成高质量动画的突破。

这项技术的关键在于其采用的解耦一致性学习策略。与直接在原始视频数据集上进行一致性学习不同,AnimateLCM将图像生成先验和运动生成先验的蒸馏过程分离开来。这种创新的方法不仅提高了训练效率,还显著增强了生成内容的视觉质量。

AnimateLCM的技术特点

-

快速生成:AnimateLCM最显著的特点是其惊人的生成速度。传统的视频扩散模型通常需要数十甚至上百步的迭代过程,而AnimateLCM仅需4步即可完成高质量视频的生成。这一突破性的提升使得实时视频生成成为可能,为诸多应用场景打开了新的大门。

-

高质量输出:尽管大幅缩短了生成时间,AnimateLCM并未牺牲输出质量。通过精心设计的解耦学习策略,该模型能够生成连贯、细节丰富且高度逼真的视频内容。

-

灵活适配:AnimateLCM的另一大优势在于其与现有Stable Diffusion社区中各种插件和适配器的兼容性。研究团队提出了一种高效的策略,使得现有的适配器(如ControlNet)能够无缝集成到AnimateLCM中,而不会影响采样速度。这种灵活性大大拓展了AnimateLCM的应用范围。

-

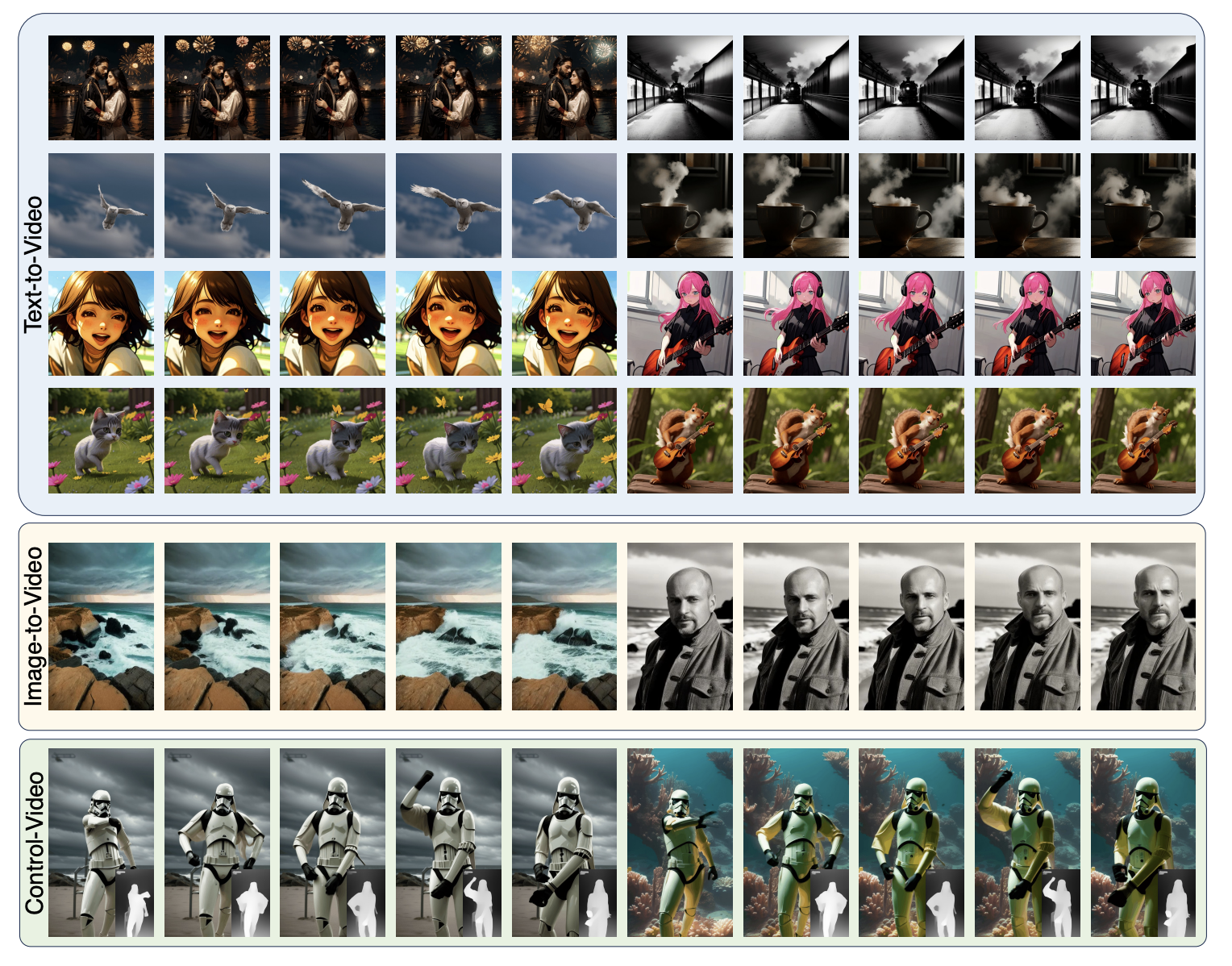

多样化应用:AnimateLCM不仅限于文本到视频的生成,还支持图像到视频、控制条件到视频、视频到视频的风格化以及长视频生成等多种任务。这种多功能性使其成为一个强大而通用的视频生成工具。

AnimateLCM的模型系列

研究团队目前已发布了三个主要的AnimateLCM模型,每个模型都针对特定的应用场景进行了优化:

-

Animate-LCM-T2V:这是一个用于个性化视频生成的模型,包含空间LoRA权重和运动模块。值得注意的是,社区反馈表明,该模型的运动模块与许多为LCM调优的个性化模型兼容,如Dreamshaper-LCM。

-

AnimateLCM-SVD-xt:这个模型专门用于高分辨率图像动画生成,支持25帧的输出,仅需1-8步即可完成。它是基于SVD-xt和SVD-xt 1.1模型调优而来。

-

AnimateLCM-I2V:这是一个直接训练的图像到视频动画模型,无需依赖教师模型。它能够在2-4步内生成个性化图像动画,尽管由于训练资源限制,其稳定性可能不如其他两个模型。

AnimateLCM的实际应用

AnimateLCM的出现为多个领域带来了新的可能性:

-

电影和动画制作:AnimateLCM可以大大加速预览和概念设计阶段的工作流程,让创作者能够快速可视化他们的想法。

-

游戏开发:游戏开发者可以利用AnimateLCM快速生成动态场景和角色动画,加速游戏原型的开发过程。

-

广告和营销:AnimateLCM的快速生成能力使得个性化视频广告的制作变得更加高效,品牌可以更快速地为不同目标受众创建定制内容。

-

教育和培训:通过快速生成解释性动画,AnimateLCM可以帮助教育工作者更有效地制作教学材料。

-

社交媒体内容创作:内容创作者可以利用AnimateLCM快速生成吸引眼球的短视频内容,提高创作效率。

AnimateLCM的使用技巧

为了充分发挥AnimateLCM的潜力,研究团队提供了一些实用的使用技巧:

-

对于AnimateLCM-T2V:

- 通常4步就能达到良好效果,但如果追求更高质量,可以尝试6-8步。

- CFG(条件控制尺度)建议设置在1-2之间,使用1.5并设置适当的负面提示词可以在保证质量的同时降低采样成本。

- 视频长度建议设为16帧,这是模型训练时使用的长度。

- 该模型可以与IP-Adapter、ControlNet等多种适配器配合使用,实现更多控制效果。

-

对于AnimateLCM-I2V:

- 个性化图像动画通常只需2-4步。

- 大多数情况下不需要设置CFG值,直接设为1即可。

- 可以调整"motion scale"参数控制运动幅度,默认值为0.8。

- 典型工作流程:先用个性化图像模型生成高质量图像,然后将该图像作为输入,重用相同的提示词进行动画生成。

-

对于AnimateLCM-SVD:

- 1-4步就能获得良好效果。

- 需要设置两个CFG值:

CFG_min和CFG_max。通常CFG_min设为1,CFG_max在1-1.5之间微调即可。

AnimateLCM的未来展望

AnimateLCM的出现无疑是AI视频生成领域的一个重要里程碑。它不仅大幅提高了生成效率,还为创作者提供了更多的创意空间。随着技术的进一步发展,我们可以期待看到:

-

更长时间、更高分辨率的视频生成:虽然目前AnimateLCM主要针对短视频和中等分辨率,但未来版本可能会支持更长时间、更高分辨率的视频生成。

-

更精细的控制:随着与更多控制技术的集成,未来的AnimateLCM可能会提供更精细的动作、表情和场景控制。

-

实时交互式生成:随着计算能力的提升,基于AnimateLCM的实时交互式视频生成系统可能会成为现实。

-

跨模态融合:未来的研究可能会探索将AnimateLCM与音频、文本等其他模态结合,实现更全面的多模态内容生成。

-

个性化和定制化:随着技术的成熟,我们可能会看到更多针对特定领域或风格的定制化AnimateLCM模型。

结语

AnimateLCM的出现标志着AI视频生成技术进入了一个新的时代。它不仅大大提高了生成效率,还为创作者提供了更多的可能性。随着这项技术的不断发展和完善,我们可以期待看到更多令人惊叹的AI生成视频内容。无论是专业的内容创作者,还是对AI感兴趣的普通用户,AnimateLCM都为我们开启了一个充满无限可能的视频创作新世界。

作为一项开源技术,AnimateLCM的发展离不开社区的支持和贡献。研究团队欢迎各界人士参与到AnimateLCM的进一步开发和应用中来,共同推动AI视频生成技术的进步。让我们一起期待AnimateLCM在未来带来的更多惊喜和突破!

📌 如果您对AnimateLCM感兴趣,可以访问项目GitHub页面了解更多详情,或者查看在线演示亲身体验这项革命性的技术。

AnimateLCM的出现无疑为AI视频生成领域带来了一场革命。它不仅大幅提高了生成效率,还为创作者提供了更多的创意空间。随着这项技术的不断发展和完善,我们有理由相信,AI生成视频的未来将会更加精彩纷呈。让我们共同期待AnimateLCM在未来带来的更多惊喜和突破!