Keras中的注意力机制:实现高效的序列模型

注意力机制是深度学习中一项革命性的技术,它使得神经网络能够像人类一样,有选择性地关注输入信息中的重要部分。在Keras中,我们可以轻松地实现和使用注意力机制,来提升序列模型的性能。本文将深入探讨Keras中注意力机制的原理、实现方法和应用案例。

注意力机制的原理

注意力机制的核心思想是让模型能够动态地决定应该关注输入序列的哪些部分。在传统的序列到序列(seq2seq)模型中,编码器将整个输入序列压缩成一个固定长度的向量,这可能会导致信息丢失。而注意力机制允许解码器在生成每个输出时,都能够"查看"整个输入序列,并根据当前的需求决定关注哪些部分。

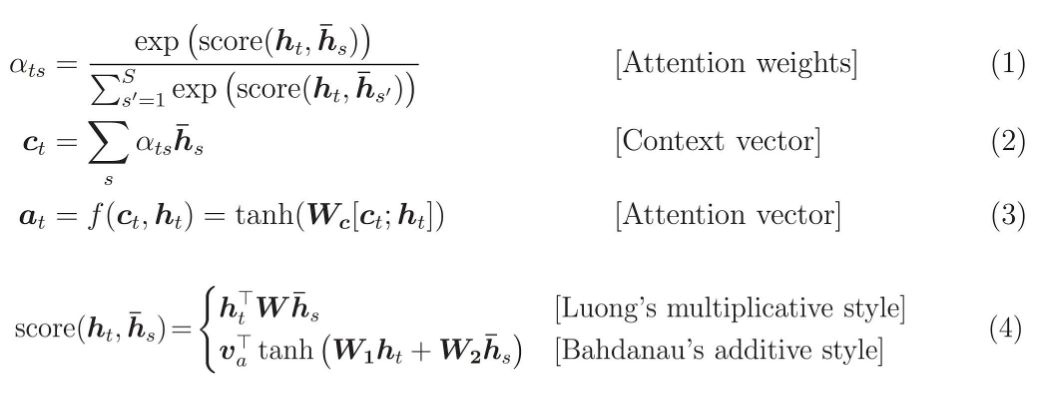

在数学上,注意力机制可以表示为一个加权和:

context = sum(attention_weights * encoder_outputs)

其中,attention_weights是一个权重向量,表示对每个输入位置的关注程度,encoder_outputs是编码器的输出序列。

Keras中的注意力层

Keras提供了现成的Attention层,可以轻松地将注意力机制集成到你的模型中。以下是一个简单的例子:

from tensorflow.keras.layers import Input, LSTM, Dense, Attention

from tensorflow.keras.models import Model

# 定义输入

encoder_inputs = Input(shape=(None, input_dim))

decoder_inputs = Input(shape=(None, input_dim))

# 编码器

encoder = LSTM(64, return_sequences=True, return_state=True)

encoder_outputs, state_h, state_c = encoder(encoder_inputs)

# 解码器

decoder = LSTM(64, return_sequences=True)

decoder_outputs = decoder(decoder_inputs, initial_state=[state_h, state_c])

# 注意力层

attention = Attention()

context_vector = attention([decoder_outputs, encoder_outputs])

# 输出

output = Dense(vocab_size, activation='softmax')(context_vector)

# 构建模型

model = Model([encoder_inputs, decoder_inputs], output)

在这个例子中,我们使用LSTM作为编码器和解码器,然后使用Attention层来计算上下文向量。这个上下文向量包含了模型认为重要的输入信息,用于生成最终的输出。

自定义注意力机制

除了使用Keras提供的Attention层,我们还可以自定义注意力机制。以下是一个简单的实现:

class CustomAttention(tf.keras.layers.Layer):

def __init__(self, units):

super(CustomAttention, self).__init__()

self.W1 = tf.keras.layers.Dense(units)

self.W2 = tf.keras.layers.Dense(units)

self.V = tf.keras.layers.Dense(1)

def call(self, query, values):

# query hidden state shape == (batch_size, hidden size)

# query_with_time_axis shape == (batch_size, 1, hidden size)

query_with_time_axis = tf.expand_dims(query, 1)

# score shape == (batch_size, max_length, 1)

# we get 1 at the last axis because we are applying score to self.V

# the shape of the tensor before applying self.V is (batch_size, max_length, units)

score = self.V(tf.nn.tanh(

self.W1(query_with_time_axis) + self.W2(values)))

# attention_weights shape == (batch_size, max_length, 1)

attention_weights = tf.nn.softmax(score, axis=1)

# context_vector shape after sum == (batch_size, hidden_size)

context_vector = attention_weights * values

context_vector = tf.reduce_sum(context_vector, axis=1)

return context_vector, attention_weights

这个自定义的注意力层实现了加性注意力机制,它通过计算query和values之间的相似度来生成注意力权重。

注意力机制的应用案例

-

机器翻译: 在机器翻译任务中,注意力机制可以帮助模型在生成每个目标语言单词时,聚焦于源语言句子中最相关的部分。这大大提高了翻译的准确性和流畅度。

-

文本摘要: 对于文本摘要任务,注意力机制可以帮助模型识别原文中的关键信息,生成更准确和相关的摘要。

-

图像描述生成: 在图像描述生成任务中,注意力机制允许模型在生成描述文本时,关注图像的不同部分,从而生成更精确和详细的描述。

-

语音识别: 注意力机制在语音识别中也发挥着重要作用,它可以帮助模型在转录过程中聚焦于音频信号的关键部分。

注意力机制的优势

-

处理长序列:注意力机制使得模型能够更有效地处理长序列输入,克服了传统RNN模型在处理长序列时的梯度消失问题。

-

提高解释性:通过分析注意力权重,我们可以了解模型在做出决策时关注的是输入的哪些部分,提高了模型的可解释性。

-

灵活性:注意力机制可以轻松地集成到各种不同的模型架构中,如RNN、CNN和Transformer等。

-

并行计算:某些类型的注意力机制(如自注意力)允许并行计算,大大提高了模型的训练和推理速度。

结论

注意力机制是深度学习中一个强大而灵活的工具,它已经在多个领域中证明了其有效性。在Keras中,我们可以轻松地实现和使用注意力机制,无论是使用内置的Attention层还是自定义注意力层。通过掌握注意力机制,我们可以构建更加强大和智能的神经网络模型,处理更复杂的序列建模任务。

随着深度学习技术的不断发展,注意力机制也在不断演化。例如,多头注意力机制和自注意力机制等变体已经在Transformer等先进模型中得到了广泛应用。作为一名深度学习实践者,持续关注和学习这些新技术将有助于我们构建更加先进和高效的AI系统。

通过本文的学习,相信读者已经对Keras中的注意力机制有了深入的理解。我们鼓励大家在实际项目中尝试使用注意力机制,探索它的潜力,并持续关注这一领域的最新发展。让我们一起推动AI技术的进步,创造更加智能的未来!