BABILong: 开创长文本处理的新时代

在自然语言处理(NLP)领域,处理超长文本一直是一个巨大的挑战。随着信息量的爆炸式增长,能够有效处理和理解长文档的需求变得越来越迫切。为了应对这一挑战,研究人员开发了BABILong基准测试,这是一个革命性的工具,旨在评估和推动NLP模型在处理超长文本方面的能力。

BABILong的诞生与意义

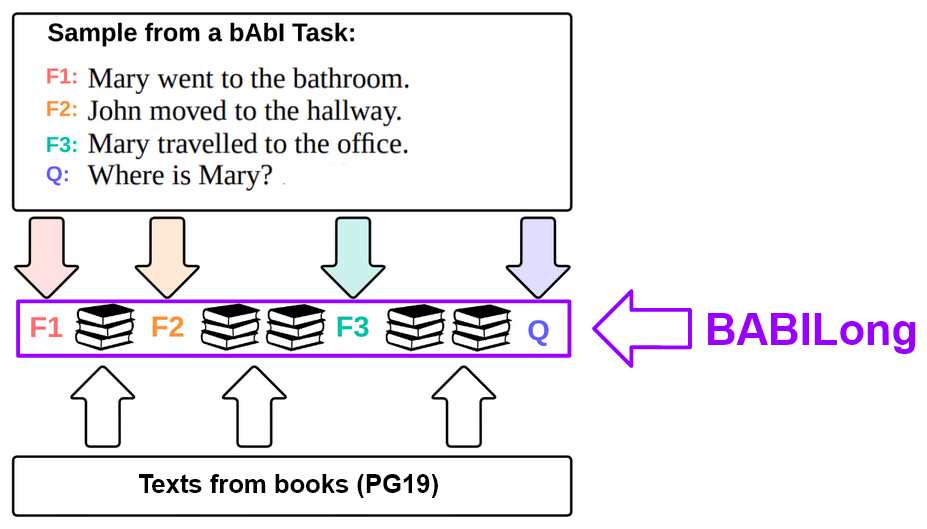

BABILong是由AIRI、DeepPavlov.ai和伦敦数学科学研究所合作开发的项目。其名称源自"bAbI + Books",反映了其独特的设计理念。BABILong将bAbI数据集的问答任务与PG19数据集的长文本背景相结合,创造出一个能够测试模型在超长文本中定位和处理关键信息能力的基准。

这个基准测试的核心思想是将重要的事实信息"隐藏"在大量无关文本中,模拟现实世界中的长文档场景。这种设计迫使模型必须在海量信息中准确识别和提取关键内容,从而评估其处理长文本的能力。BABILong的测试样本长度可以达到惊人的数百万个标记,远超当前大多数模型的处理能力。

BABILong的结构与特点

BABILong包含20个不同的任务,每个任务都设计用来评估推理能力的不同方面。这些任务通过模拟一组角色和物体在多个位置之间的移动和互动来生成。每个交互都表示为一个事实,例如"Mary去了办公室",而任务则是根据当前模拟中的事实回答问题,比如"Mary在哪里?"。

BABILong的任务难度各不相同,基于以下几个方面:

- 事实数量

- 问题复杂度

- 推理类型

以下是BABILong的前十个任务示例:

| 任务 | 名称 | 每个任务的事实数 | 每个任务的支持性事实数 |

|---|---|---|---|

| qa1 | 单个支持性事实 | 2 - 10 | 1 |

| qa2 | 两个支持性事实 | 2 - 68 | 2 |

| qa3 | 三个支持性事实 | 4 - 32 | 3 |

| qa4 | 两个参数关系 | 2 | 1 |

| qa5 | 三个参数关系 | 2 - 126 | 1 |

| qa6 | 是非问题 | 2 - 26 | 1 |

| qa7 | 计数 | 2 - 52 | 1-10 |

| qa8 | 列表和集合 | 2 - 50 | 1-8 |

| qa9 | 简单否定 | 2 - 10 | 1 |

| qa10 | 不确定知识 | 2 - 10 | 1 |

这种多样化的任务设计使BABILong能够全面评估模型的各种推理能力,从简单的事实提取到复杂的逻辑推理。

BABILong评估结果的启示

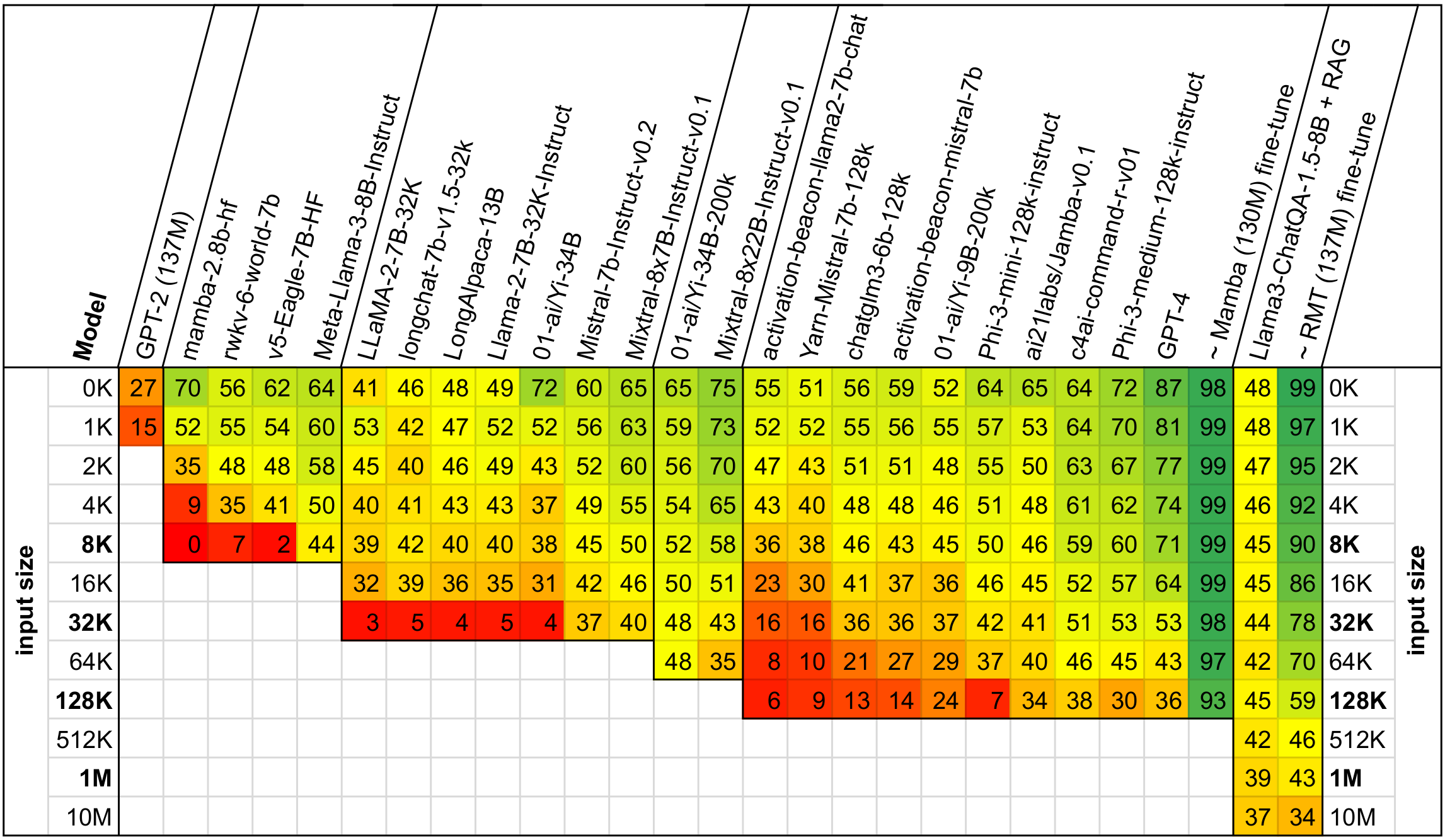

研究团队使用BABILong对多个主流的长文本处理模型进行了评估,结果令人深思。即使是号称支持128K标记的模型,如GPT-4 (gpt-4-0125-preview),在输入超过其声称容量的10%时也会出现性能下降。这一发现突显了当前长文本处理技术的局限性,同时也为未来的研究指明了方向。

有趣的是,研究发现传统的检索增强生成(RAG)方法在这些任务上并没有显著帮助。然而,对小规模模型(如RMT 137M和Mamba 130M)进行微调后,这些任务是可以解决的。这一结果表明,虽然当前的大型语言模型在处理超长文本时面临挑战,但通过适当的训练和优化,即使是较小的模型也能在这些复杂任务上取得不错的表现。

BABILong的应用与未来展望

BABILong不仅是一个评估工具,更是推动NLP领域进步的催化剂。它为研究人员和开发者提供了一个标准化的平台,用于:

- 模型评估: 使用BABILong可以全面测试模型的长文本处理能力,发现其优势和不足。

- 模型改进: 基于评估结果,研究人员可以有针对性地优化模型架构和训练方法。

- 新技术探索: BABILong为开发新的长文本处理技术提供了一个理想的测试场。

- 跨模型比较: 通过统一的基准,可以客观比较不同模型在长文本处理方面的表现。

为了促进这一领域的发展,BABILong项目团队呼吁社区参与到基准的扩展和完善中来。他们鼓励研究者:

- 测试自己的模型并分享结果

- 提供改进LLM在BABILong任务上表现的见解

- 开发新的挑战性任务

- 提出改进基准设计和方法的建议

通过这种开放合作的方式,BABILong有望成为推动下一代LLM发展的重要工具,帮助我们构建能够更好地理解和处理复杂、长篇文本的AI系统。

结语

BABILong的出现标志着NLP领域在长文本处理方面迈出了重要一步。它不仅揭示了当前技术的局限性,也为未来的研究指明了方向。随着越来越多的研究者和开发者参与到这个项目中来,我们有理由相信,在不久的将来,AI系统将能够更加智能地处理和理解长文本,为各行各业带来革命性的变革。

BABILong项目为我们展示了一个充满挑战和机遇的未来。通过不断挑战和突破极限,我们终将实现AI在理解和处理复杂信息方面的飞跃,为人类知识的获取和利用开辟新的可能性。