Bert-VITS2-ext项目简介

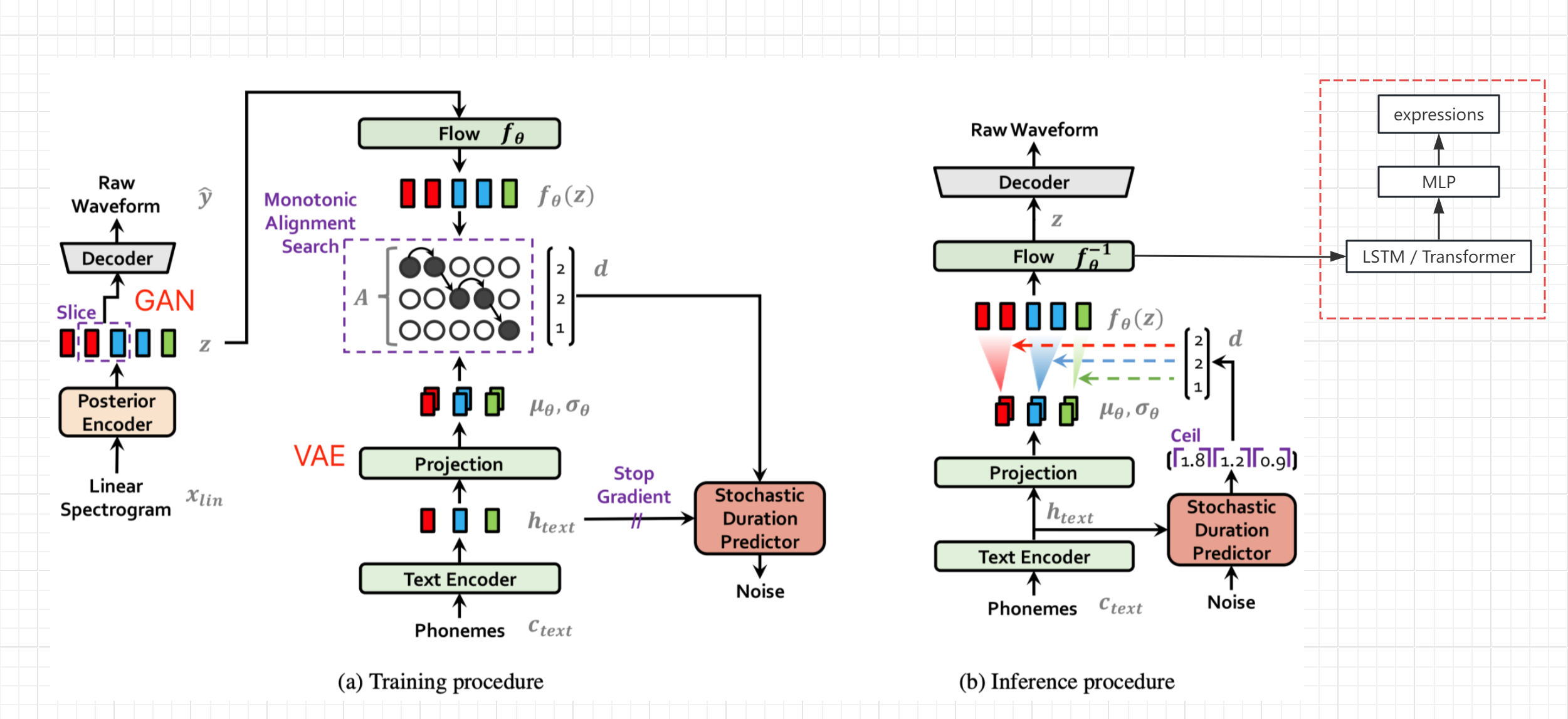

Bert-VITS2-ext是GitHub用户see2023开发的一个开源项目,基于Bert-VITS2进行拓展,目的是实现TTS(文本到语音)的同时生成同步的脸部表情和身体动画数据。该项目为语音合成技术开辟了新的应用场景,让虚拟形象可以更自然地"说话"。

项目特点

- 基于Bert-VITS2 v2.3版本开发

- 实现了TTS同步输出表情数据

- 支持从声音生成表情

- 可结合MotionGPT等工具生成全身动画

学习资源

-

项目GitHub仓库: https://github.com/see2023/Bert-VITS2-ext

-

效果演示视频:

-

相关技术文档:

使用指南

1. 数据采集

使用Live Link Face采集语音和表情数据:

python ./motion/record.py

2. 数据预处理

将音频编码为隐变量:

python ./motion/prepare_visemes.py

3. 模型训练

python train_ms.py -m OUTPUT_MODEL --config ./configs/config.json --visemes

4. 推理生成

使用webui.py进行推理,生成的音频、隐变量、动画数据会保存在当前目录。

5. 效果预览

使用tts2ue.py脚本预览生成效果:

python ./motion/tts2ue.py --bs_npy_file ./tmp.npy --wav_file ./tmp.wav --delay_ms 700

扩展应用

- 结合MotionGPT生成全身动画

- 与CosyVoice和GPT-SoVITS结合使用

注意事项

- 纯中文训练效果可能不如Bert-VITS2 1.0版本,可考虑降低版本或混合使用

- 生成的动画默认fps为86.1328125,可能需要调整

- 项目仍在开发中,欢迎贡献和反馈

Bert-VITS2-ext为TTS技术开辟了新的应用方向。无论是虚拟主播、数字人还是游戏NPC,都可以基于该项目实现更自然、富有表现力的语音交互。希望本文能够帮助大家快速上手这个有趣的项目!