OMG: 开启多概念图像生成的新时代

在人工智能和计算机视觉领域,图像生成技术一直是研究的热点。近年来,随着扩散模型的兴起,图像生成的质量和多样性都得到了显著提升。然而,如何在一张图像中同时生成多个具有特定身份和风格的角色,一直是一个具有挑战性的问题。为了解决这个问题,研究人员开发了OMG(Occlusion-friendly Personalized Multi-concept Generation)框架,这是一个突破性的多概念图像生成工具。

OMG的核心特性

OMG框架的设计目标是实现高质量的多角色图像生成。它具有以下几个核心特性:

-

多角色支持: OMG可以在一张图像中同时生成多个具有不同身份的角色,而且能够很好地处理角色之间的遮挡关系。

-

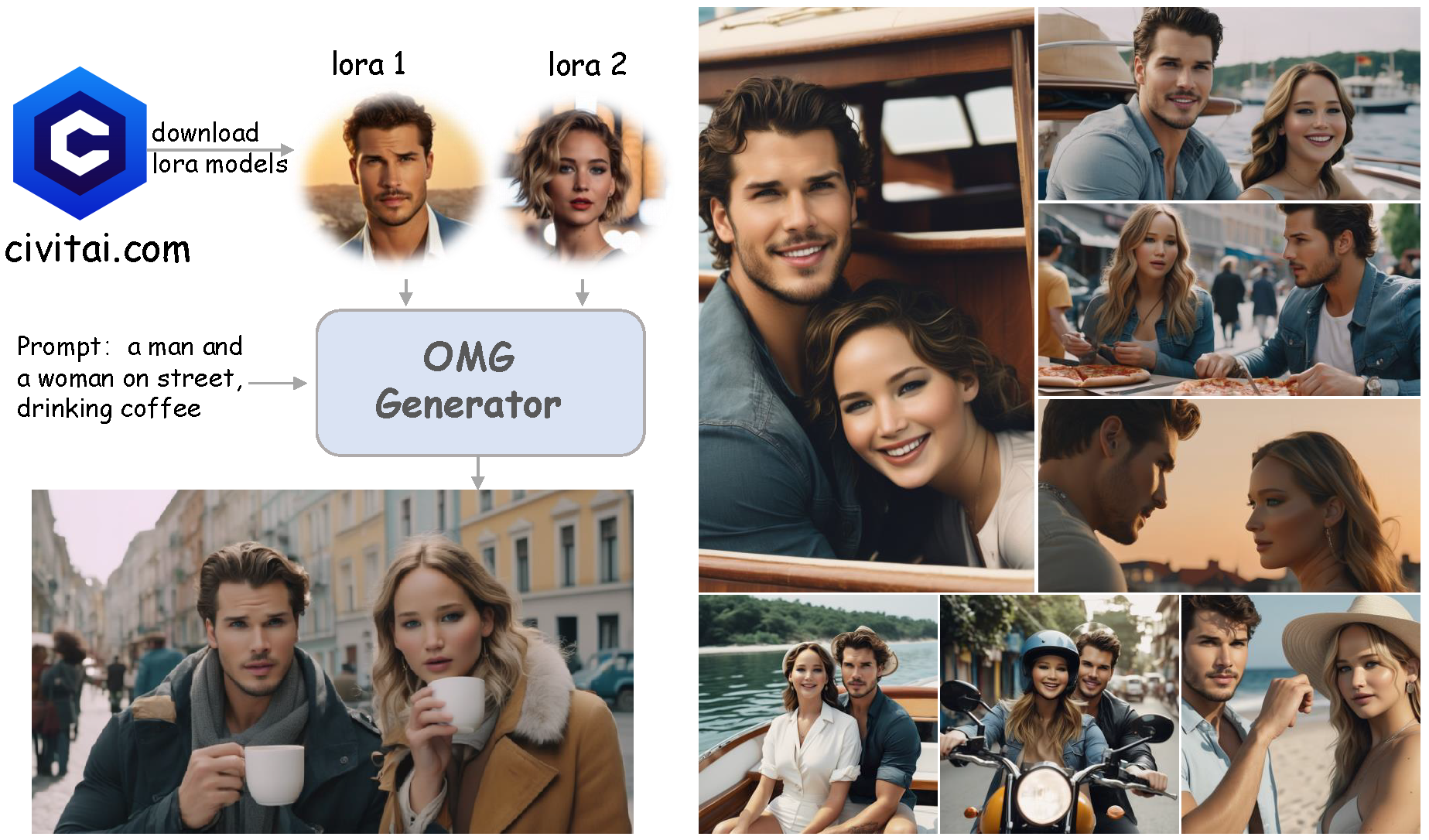

LoRA兼容: 支持使用来自Civitai.com的角色和风格LoRA(Low-Rank Adaptation)模型,极大地扩展了可生成的角色和风格范围。

-

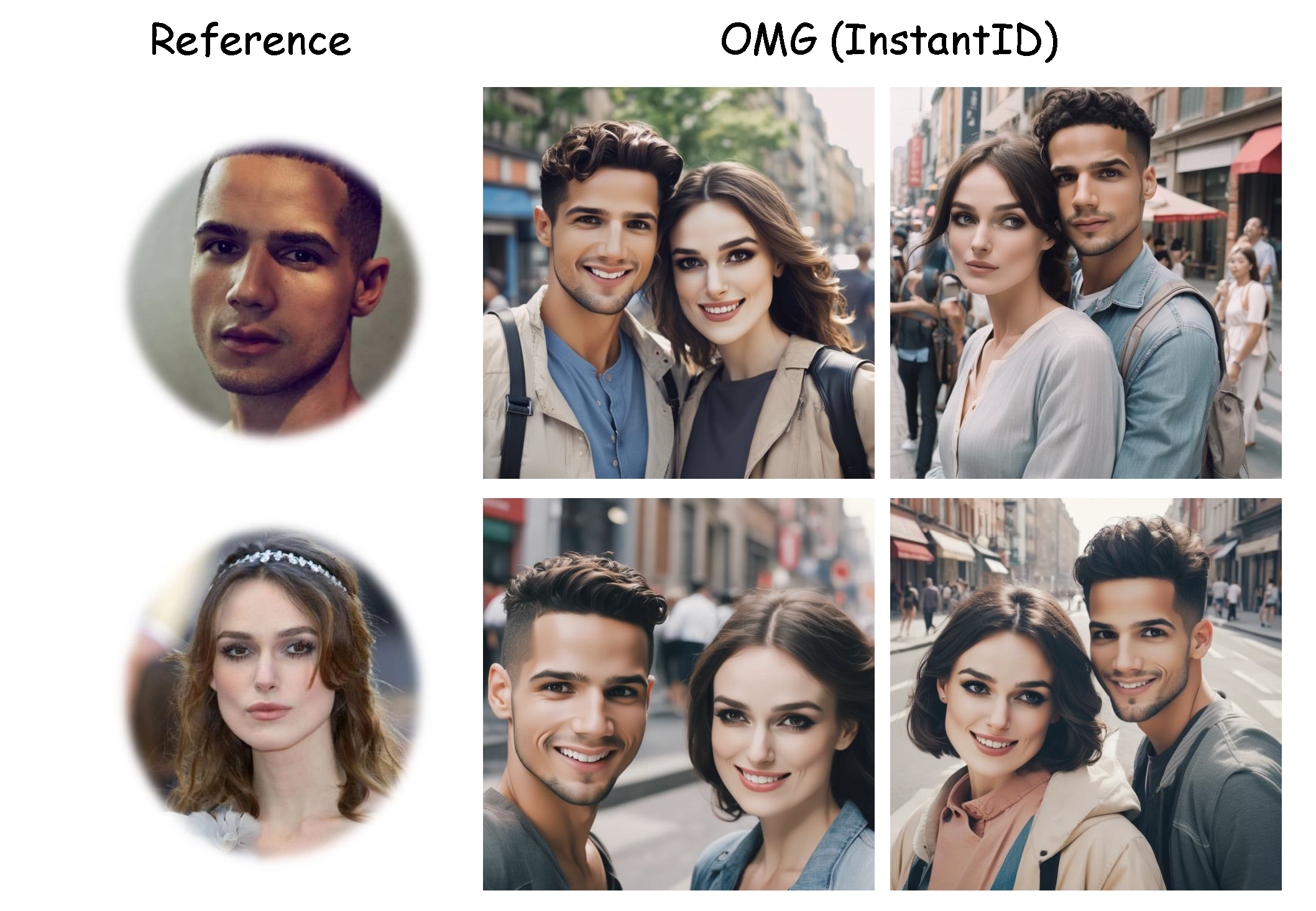

InstantID集成: 可以与InstantID技术结合使用,仅需一张参考图像即可生成具有特定身份的角色。

-

灵活的控制: 支持使用ControlNet进行姿势控制,可以精确指定生成角色的姿态。

-

风格多样性: 通过使用不同的风格LoRA,可以生成各种艺术风格的图像,如素描、油画等。

OMG的工作原理

OMG框架的工作原理基于扩散模型,并结合了多项创新技术:

-

多概念融合: OMG能够同时处理多个概念(如不同的角色和风格),并在生成过程中将它们无缝融合。

-

遮挡友好设计: 特别优化了处理角色间遮挡关系的算法,确保生成的图像在视觉上合理自然。

-

LoRA适配: 通过低秩适应技术,OMG可以快速适应不同的角色和风格LoRA模型,无需重新训练大型模型。

-

视觉理解: 集成了先进的视觉理解模块(如YoloWorld或GroundingDINO),用于准确识别和定位图像中的对象。

-

精确控制: 结合ControlNet技术,允许用户通过姿势图或其他条件来精确控制生成结果。

OMG的应用场景

OMG框架的应用前景非常广阔,可以在多个领域发挥重要作用:

-

娱乐产业: 电影和游戏制作可以使用OMG快速生成概念艺术和角色设计。

-

广告创意: 广告行业可以利用OMG创作包含多个明星或产品的复杂场景。

-

教育培训: 可以生成各种情境的教学图片,用于语言学习或情景模拟训练。

-

艺术创作: 艺术家可以借助OMG探索新的创作可能,生成独特的多人物艺术作品。

-

社交媒体: 用户可以创建包含多个虚拟角色的有趣图片,增强社交媒体互动。

OMG的使用指南

要开始使用OMG,首先需要准备好环境和必要的模型文件。以下是基本的设置步骤:

-

环境配置:

- Python 3.10.6

- PyTorch 2.0.1

- TorchVision 0.15.2

-

模型准备:

- 下载基础模型如stable-diffusion-xl-base-1.0

- 准备ControlNet模型如controlnet-openpose-sdxl-1.0

- 选择并下载角色LoRA模型

- 下载视觉理解模型(YoloWorld或GroundingDINO)

-

安装依赖:

conda create -n OMG python=3.10.6

conda activate OMG

pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2

pip install -r requirements.txt

- 基本使用: 对于OMG + LoRA的基本使用,可以使用以下命令:

python inference_lora.py \

--prompt "你的提示词" \

--negative_prompt "负面提示词" \

--prompt_rewrite "[角色1提示词]-*-[负面提示词]|[角色2提示词]-*-[负面提示词]" \

--lora_path "[角色1 LoRA路径|角色2 LoRA路径]"

对于OMG + InstantID的使用,命令如下:

python inference_instantid.py \

--prompt "你的提示词" \

--negative_prompt "负面提示词" \

--prompt_rewrite "[角色1提示词]-*-[负面提示词]-*-参考图像1路径|[角色2提示词]-*-[负面提示词]-*-参考图像2路径"

OMG的高级功能

OMG不仅支持基本的多角色生成,还提供了多种高级功能,让创作更加灵活多样:

- ControlNet姿势控制:

通过添加

--spatial_condition参数,可以使用姿势图来控制生成角色的姿态:

python inference_lora.py \

--prompt "你的提示词" \

--negative_prompt "负面提示词" \

--prompt_rewrite "..." \

--lora_path "..." \

--spatial_condition './example/pose.png' \

--controlnet_checkpoint './checkpoint/controlnet-openpose-sdxl-1.0'

- 风格LoRA应用:

使用

--style_lora参数可以应用特定的艺术风格:

python inference_lora.py \

--prompt "你的提示词, 包含风格描述" \

--negative_prompt "负面提示词" \

--prompt_rewrite "..." \

--lora_path "..." \

--style_lora './checkpoint/style/Anime_Sketch_SDXL.safetensors'

- InstantID + ControlNet + 风格LoRA: OMG支持将InstantID、ControlNet和风格LoRA结合使用,实现更复杂的创作:

python inference_instantid.py \

--prompt "你的提示词, 包含风格描述" \

--negative_prompt "负面提示词" \

--prompt_rewrite "..." \

--style_lora './checkpoint/style/Anime_Sketch_SDXL.safetensors' \

--spatial_condition './example/pose.png' \

--t2i_controlnet_path './checkpoint/controlnet-openpose-sdxl-1.0'

OMG的技术亮点

-

视觉理解模块: OMG集成了先进的视觉理解技术,用户可以选择使用YoloWorld + EfficientViT SAM或GroundingDINO + SAM。这些技术能够精确识别和分割图像中的对象,为多角色生成提供关键支持。

-

灵活的LoRA适配: OMG可以无缝适配各种角色和风格LoRA,使用户能够轻松创建具有特定身份和艺术风格的图像。这种灵活性大大扩展了创作的可能性。

-

InstantID技术: 通过集成InstantID,OMG能够仅使用一张参考图像就生成具有特定身份的角色。这个功能特别适用于快速创建基于真实人物的虚拟角色。

-

高度可控的生成过程: OMG提供了丰富的参数和控制选项,让用户能够精确调整生成结果。从提示词、负面提示词到姿势控制和风格应用,每个方面都可以细致调整。

OMG的未来展望

OMG框架的出现无疑为多概念图像生成领域带来了新的可能性。随着技术的不断发展,我们可以期待OMG在以下方面有更多突破:

-

实时生成: 优化算法和硬件加速,实现实时的多角色图像生成。

-

视频生成: 扩展OMG的能力,支持多角色、多风格的视频生成。

-

3D生成: 结合3D技术,实现多角色的3D场景生成。

-

交互式编辑: 开发更直观的用户界面,允许用户实时交互式地编辑和调整生成结果。

-

跨模态生成: 结合自然语言处理技术,实现文本到多角色场景的直接生成。

结语

OMG框架的出现标志着多概念图像生成技术的一个重要里程碑。它不仅为创作者提供了强大的工具,也为人工智能图像生成领域开辟了新的研究方向。随着技术的不断完善和应用场景的拓展,OMG有望在未来的数字创作和视觉内容生产中发挥越来越重要的作用。

无论是专业创作者还是AI爱好者,OMG都提供了一个值得探索和学习的平台。通过实践和创新,相信每个用户都能在OMG的基础上创造出令人惊叹的视觉作品。让我们一起期待OMG带来的更多可能性,共同推动人工智能图像生成技术的发展。