Bunny:轻量级多模态模型的新选择

在人工智能快速发展的今天,多模态模型正成为研究和应用的热点。然而,大多数高性能的多模态模型往往规模庞大,计算资源需求高昂。为了解决这一问题,北京智源人工智能研究院(BAAI)开发了Bunny - 一个轻量级但功能强大的多模态模型家族。

Bunny的特点与优势

Bunny模型家族的主要特点包括:

-

轻量级设计: Bunny采用了多种小型但高效的视觉编码器和语言模型,大大降低了计算资源需求。

-

模块化架构: Bunny支持多种视觉编码器(如EVA-CLIP、SigLIP)和语言模型(如Llama-3-8B、Phi-3-mini等)的灵活组合。

-

高质量训练数据: 通过精心筛选和构建更具信息量的训练数据,Bunny在小型模型上也能实现优异性能。

-

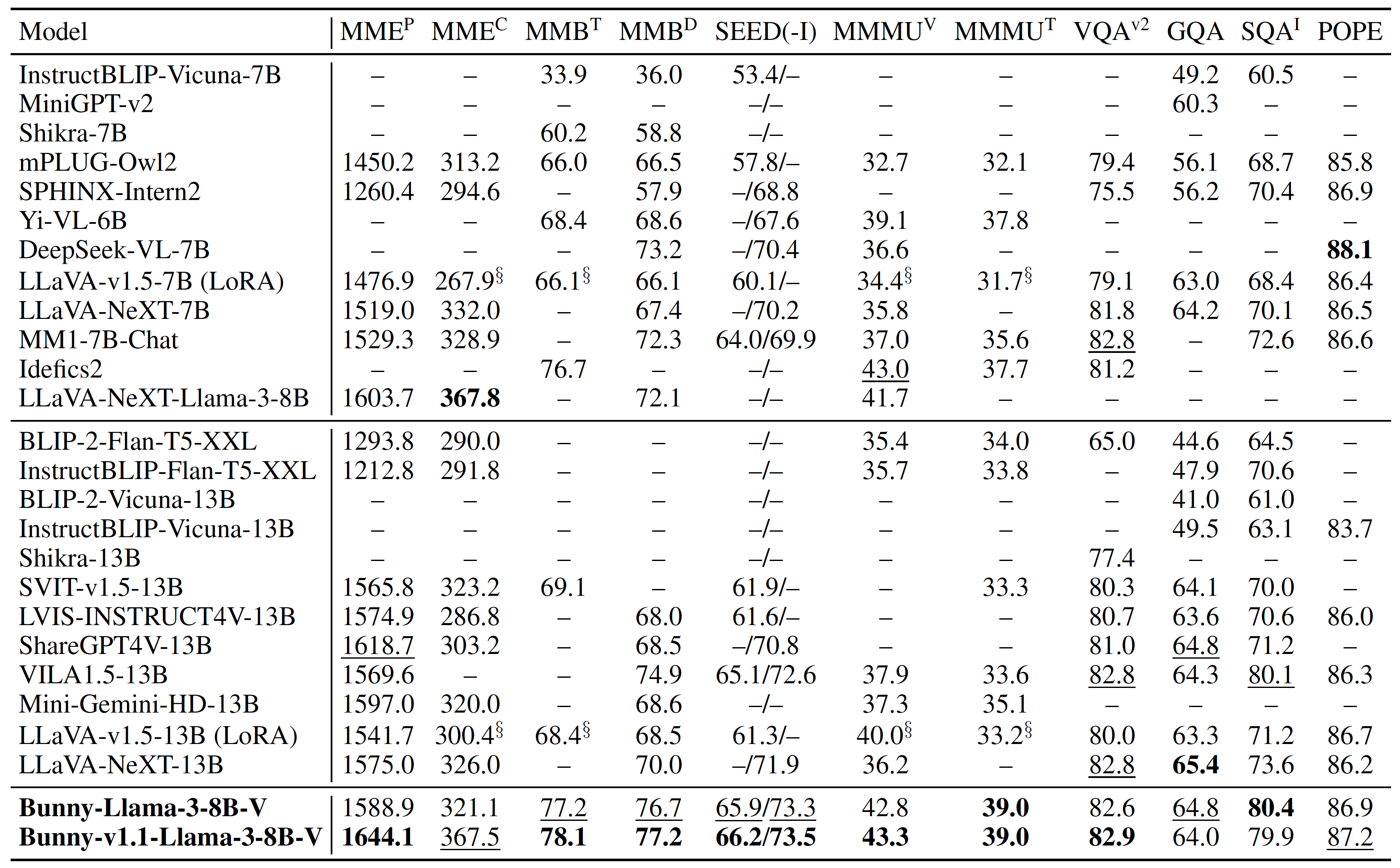

出色的性能表现: 在多项基准测试中,Bunny展现出与更大规模模型相媲美甚至更优的性能。

Bunny模型家族成员

Bunny模型家族目前包括多个成员,其中最具代表性的有:

-

Bunny-Llama-3-8B-V: 基于Llama-3的首个视觉-语言模型,性能卓越。最新的v1.1版本支持高达1152x1152分辨率的图像输入。

-

Bunny-4B: 基于SigLIP和Phi-3-mini构建,在同等规模甚至更大规模的多模态模型中表现出色。v1.1版本同样支持1152x1152分辨率图像。

-

Bunny-v1.0-3B: 由SigLIP和Phi-2组成,是小型模型中性能最佳的代表。

-

Bunny-v1.0-3B-zh和Bunny-v1.0-2B-zh: 专注于中文问答能力的模型变体。

这些模型在MME、MMB、SEED、MMMU、VQA等多项基准测试中都展现出了优异的性能。

Bunny的技术实现

Bunny的成功离不开其独特的技术实现:

-

两阶段训练策略:

- 预训练阶段:使用数据连接冻结的预训练视觉编码器和冻结的语言模型,仅训练连接器。

- 视觉指令微调阶段:使用数据教导模型遵循多模态指令,更新连接器、可学习的语言模型参数和视觉编码器(可选)。

-

灵活的模型组合: 支持多种视觉编码器(如CLIP、EVA-CLIP、SigLIP)和语言模型(如phi-1.5、stablelm-2、qwen1.5-1.8b、minicpm、phi-2、phi-3和llama3-8b)的组合。

-

高效的训练方法: 采用LoRA等技术进行高效训练,并提供了详细的训练教程。

Bunny的应用前景

Bunny凭借其轻量级设计和优异性能,在多个领域都有广阔的应用前景:

-

移动设备和边缘计算: Bunny的小型化设计使其非常适合在计算资源有限的移动设备或边缘设备上部署。

-

智能客服系统: Bunny强大的图文理解能力可以应用于智能客服系统,提高客户服务质量。

-

内容审核与分类: Bunny可以用于社交媒体平台的内容审核,快速识别和分类图文内容。

-

辅助诊断系统: 在医疗领域,Bunny可以协助医生解读医学影像,提供初步诊断建议。

-

智能教育: Bunny可以用于开发智能教育工具,为学生提供个性化的学习体验。

使用Bunny

Bunny提供了多种使用方式,包括:

-

HuggingFace Transformers: 可以通过HuggingFace的transformers库轻松加载和使用Bunny模型。

-

ModelScope: 特别适合中国大陆用户,提供了更便捷的模型下载和使用方式。

-

Docker: 提供了预配置的Docker镜像,方便快速部署。

-

本地安装: 提供了详细的本地安装指南,支持自定义安装和使用。

Bunny的未来发展

作为一个开源项目,Bunny正在持续发展和改进:

-

模型优化: 研究团队正在不断优化模型结构和训练方法,以进一步提升性能。

-

扩展支持: 计划支持更多类型的视觉编码器和语言模型,增加模型的多样性。

-

应用开发: 鼓励社区开发基于Bunny的各种应用,探索更多实际场景。

-

多语言支持: 强化模型的多语言能力,特别是非英语语言的支持。

-

跨模态能力: 探索在图像之外的其他模态(如音频、视频)上的应用。

Bunny项目的成功不仅展示了轻量级多模态模型的潜力,也为人工智能的普及和应用提供了新的可能。随着项目的不断发展,我们可以期待看到更多基于Bunny的创新应用,推动人工智能技术在各个领域的深入应用。

🔗 更多信息:

Bunny的出现为多模态AI模型的轻量化和普及化开辟了新的道路。无论是研究人员、开发者还是企业用户,都可以从这个强大而灵活的模型家族中受益。让我们共同期待Bunny在未来带来更多惊喜和创新! 🐰✨