CamLiFlow:突破性的光流和场景流估计框架

在计算机视觉领域,准确估计场景中物体的运动一直是一个具有挑战性的任务。近日,南京大学机器认知实验室(MCG-NJU)的研究人员提出了一种名为CamLiFlow的创新方法,为这一难题带来了突破性的解决方案。

背景与挑战

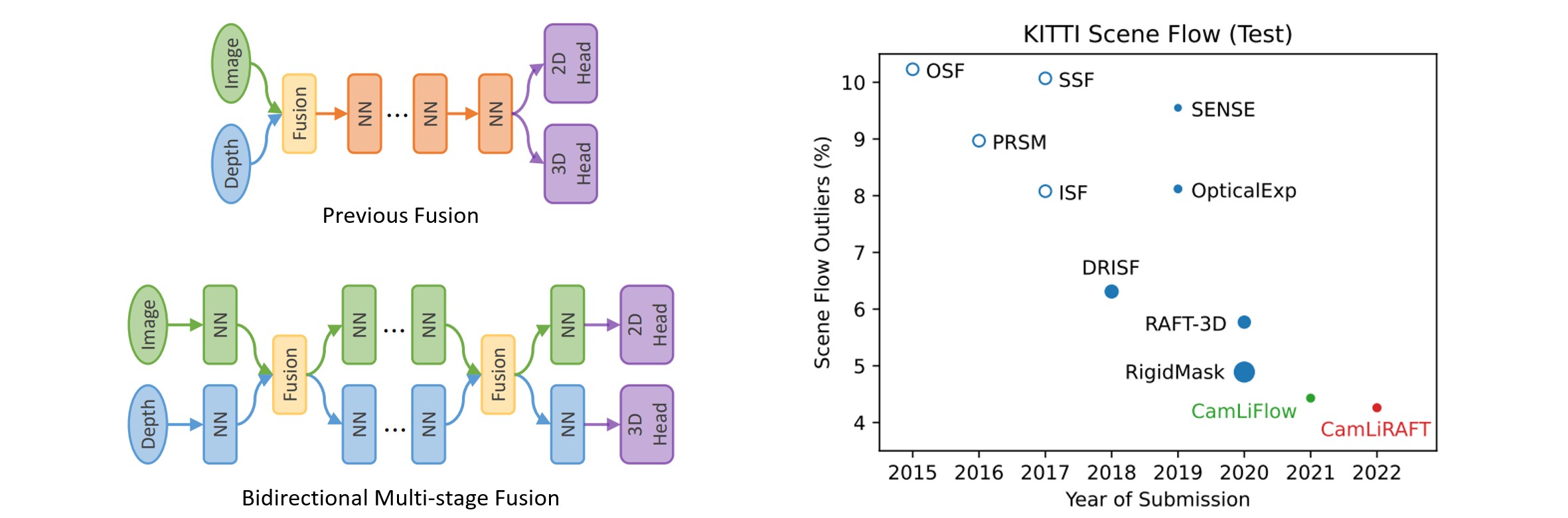

光流和场景流估计是计算机视觉中的基础任务,对于自动驾驶、机器人导航等应用至关重要。传统方法往往将2D图像和3D点云数据割裂开来单独处理,或者采用简单的"早期融合"或"晚期融合"策略,难以充分利用不同模态数据的特点。如何有效地融合2D和3D信息,一直是该领域面临的关键挑战。

CamLiFlow的创新设计

CamLiFlow采用了一种全新的双向融合架构,包含2D和3D两个处理分支,并在特定层之间建立多个双向连接。与以往工作不同,CamLiFlow使用基于点的3D分支更好地提取几何特征,并设计了一种对称的可学习算子来融合密集的图像特征和稀疏的点特征。

这种设计使得CamLiFlow能够:

- 充分利用每种模态数据的特点

- 最大化跨模态之间的互补性

- 在端到端的训练过程中自适应地学习最优的融合策略

卓越的性能表现

实验结果表明,CamLiFlow在多个基准数据集上都取得了出色的表现:

- 在KITTI场景流基准测试中排名第一,以仅1/7的参数量超越了此前的最佳方法

- 在FlyingThings3D数据集上,CamLiFlow将2D误差(EPE2D)和3D误差(EPE3D)分别降低了21%和20%

- 在MPI Sintel数据集上,无需微调即将误差降低了12%-18%,展现出优秀的泛化能力

这些结果充分证明了CamLiFlow在准确性、效率和泛化性方面的优势。

开源与影响

为了推动该领域的发展,研究团队已经在GitHub上开源了CamLiFlow的完整代码实现(https://github.com/MCG-NJU/CamLiFlow)。这不仅方便其他研究者复现结果,也为后续工作提供了宝贵的基础。

CamLiFlow的成功发表于计算机视觉顶级会议CVPR 2022(口头报告),并被扩展版本收录于IEEE模式分析与机器智能汇刊(TPAMI)。这表明该工作得到了学术界的高度认可,有望对相关领域产生深远影响。

未来展望

CamLiFlow为光流和场景流估计开辟了新的研究方向。未来可能的发展包括:

- 进一步优化网络结构,提高计算效率

- 探索更多模态数据(如热成像、毫米波雷达等)的融合

- 将CamLiFlow应用于更多实际场景,如自动驾驶和机器人视觉

总的来说,CamLiFlow代表了多模态融合在计算机视觉任务中的最新进展。它不仅在性能上取得了突破,更为今后的研究指明了方向。我们有理由相信,随着这一领域的不断发展,我们将看到更多激动人心的应用在不久的将来成为现实。