Canopy简介

Canopy是一个开源的检索增强生成(RAG)框架和上下文引擎,基于Pinecone向量数据库构建。它为开发者提供了一套完整的工具和API,用于快速构建和部署基于RAG的智能应用。

RAG(Retrieval Augmented Generation)是一种结合检索和生成的AI技术,通过从知识库中检索相关信息来增强大语言模型的生成能力。Canopy实现了RAG的全流程,包括文本数据处理、向量化存储、上下文检索、提示工程等关键环节,大大简化了RAG应用的开发难度。

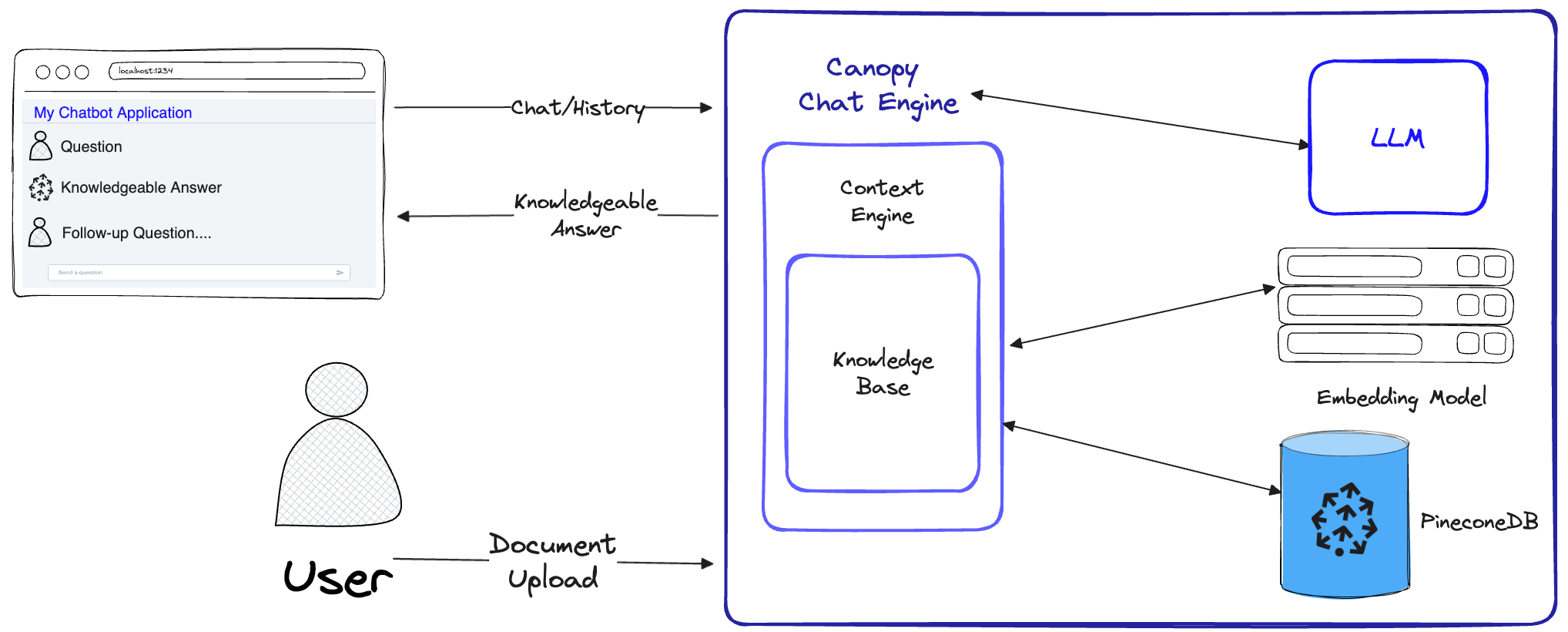

如上图所示,Canopy的RAG流程主要包括两个阶段:

-

知识库创建:将用户上传的文档进行处理,转换为向量表示并存储到Pinecone向量数据库中。

-

对话交互:对输入的查询和对话历史进行优化,从知识库中检索最相关的文档,生成有意义的上下文,然后交给大语言模型进行回答。

通过这种方式,Canopy可以有效防止大语言模型的幻觉问题,同时利用知识库中的信息来增强模型的回答能力。

Canopy的核心组件

Canopy框架主要包含以下几个核心组件:

1. Canopy核心库

Canopy核心库提供了3个主要的类,分别负责RAG工作流的不同部分:

-

ChatEngine: 提供聊天接口与数据进行交互。它根据聊天历史向ContextEngine提出相关查询,然后使用大语言模型生成知识丰富的回复。

-

ContextEngine: 执行RAG中的"检索"部分。它利用底层的KnowledgeBase检索最相关的文档,然后组织成连贯的文本上下文,作为大语言模型的提示。

-

KnowledgeBase: 管理RAG工作流的数据。它自动对文本数据进行分块和向量化,存储到Pinecone或Qdrant向量数据库中。给定文本查询时,知识库会从数据库中检索最相关的文档片段。

2. Canopy服务器

Canopy服务器是一个Web服务,封装了Canopy核心库并将其作为REST API暴露出来。服务器基于FastAPI、Uvicorn和Gunicorn构建,可以轻松部署到生产环境中。服务器还带有内置的Swagger UI,方便测试和文档查看。

3. Canopy CLI

Canopy CLI是一个内置的开发工具,允许用户快速设置自己的Canopy服务器并测试其配置。只需几个简单的CLI命令,就可以创建新的Canopy服务器、上传文档,并通过内置的聊天应用直接与聊天机器人进行交互。内置聊天机器人还支持比较带RAG和不带RAG的响应效果。

快速上手Canopy

要开始使用Canopy,只需几个简单的步骤:

- 安装Canopy:

pip install canopy-sdk

- 设置环境变量:

export PINECONE_API_KEY="<your_pinecone_api_key>"

export OPENAI_API_KEY="<your_openai_api_key>"

export INDEX_NAME="<your_index_name>"

- 创建Canopy索引:

canopy create

- 上传数据:

canopy upsert /path/to/data_directory

- 启动Canopy服务器:

canopy start

现在,Canopy服务器已经在运行,你可以通过REST API与之交互,或者使用内置的评估聊天工具进行测试:

canopy chat

Canopy的高级用法

迁移现有OpenAI应用到Canopy

如果你已经有一个使用OpenAI API的应用,只需将API端点更改为http://localhost:8000/v1,就可以轻松迁移到Canopy:

from openai import OpenAI

client = OpenAI(base_url="http://localhost:8000/v1")

在生产环境中运行Canopy服务器

对于生产环境,建议使用Canopy的Docker镜像。你也可以使用Gunicorn作为生产级WSGI服务器:

gunicorn canopy_server.app:app --worker-class uvicorn.workers.UvicornWorker --bind 0.0.0.0:$PORT --workers $WORKER_COUNT

Canopy的优势

-

开源灵活: Canopy是一个开源项目,允许开发者自由定制和扩展。

-

全流程RAG解决方案: 从文本处理到上下文检索,Canopy提供了完整的RAG工作流实现。

-

易于集成: 通过REST API和兼容OpenAI的接口,Canopy可以轻松集成到现有应用中。

-

内置评估工具: Canopy CLI提供了便捷的评估工具,帮助开发者比较RAG效果。

-

可扩展性: 基于Pinecone向量数据库,Canopy具有良好的可扩展性,适用于大规模应用场景。

结语

Canopy为开发者提供了一个强大而灵活的RAG框架,大大简化了基于RAG的智能应用开发流程。无论是构建问答系统、智能客服还是其他需要结合大规模知识库的AI应用,Canopy都是一个值得考虑的选择。随着项目的不断发展和社区的贡献,相信Canopy会为更多创新型AI应用的诞生提供有力支持。

要了解更多关于Canopy的信息,可以访问GitHub项目页面或查看官方文档。同时,Canopy团队也欢迎社区贡献,共同推动这个开源RAG框架的发展。