CapsFusion:重新思考大规模图像-文本数据

大型多模态模型在零样本执行各种多模态任务方面展现出了卓越的通用能力。大规模的基于网络的图像-文本对数据为这一成功做出了根本性贡献,但同时也存在着过多噪声的问题。近期的研究使用由图像标题生成模型合成的替代标题,并在基准测试中取得了显著的性能。然而,我们的实验揭示了使用合成标题训练的模型存在严重的可扩展性不足和世界知识丢失问题,这些问题在初始的基准测试成功中被很大程度上掩盖了。

CapsFusion框架

为了提供更高质量和更具可扩展性的多模态预训练数据,研究人员提出了CapsFusion,这是一个先进的框架,利用大型语言模型(LLMs)来整合和优化来自基于网络的图像-文本对和合成标题的信息。CapsFusion通过有机地融合真实图像-文本对的优势和由标题生成模型生成的合成标题,解决了使用合成标题训练的大型多模态模型(LMMs)中存在的严重可扩展性不足和世界知识丢失问题。

主要特点和优势

-

高质量标题生成: CapsFusion利用大型语言模型整合和优化来自网络图像-文本对和合成标题的信息,生成更高质量的标题。

-

性能提升: 在广泛的实验中,CapsFusion标题展现出显著的全面优势。例如,在COCO和NoCaps数据集上,CIDEr评分分别提高了18.8和18.3分。

-

样本效率: CapsFusion在计算效率方面表现出色,与基线相比,仅需11-16倍更少的计算资源。

-

世界知识深度: 通过融合真实图像-文本对的信息,CapsFusion生成的标题包含更丰富的世界知识。

-

可扩展性: CapsFusion框架展现出优秀的可扩展性,能够处理大规模数据集。

CapsFusion-120M数据集

研究团队发布了CapsFusion-120M数据集,这是一个高质量的大规模多模态预训练资源。该数据集包含:

- 图像URL

- LAION-2B标题(来自网络的原始alt文本)

- LAION-COCO标题(由BLIP合成)

- CapsFusion标题(本研究生成)

这个数据集为研究人员提供了比较分析和深入研究图像-文本数据质量的机会。

模型使用

研究团队提供了CapsFus-LLaMA模型,用于生成CapsFusion标题。使用方法如下:

- 安装依赖:

pip install -r requirements.txt

- 准备数据:数据格式应包含LAION-2B和LAION-COCO的标题。

- 运行推理:

torchrun --nnodes 1 --nproc_per_node 8 capsfusion_inference.py

模型将自动从Hugging Face下载,也可以手动下载并在config.yaml中指定本地路径。

实际应用效果

CapsFusion生成的标题展现出对真实世界知识的丰富理解。例如:

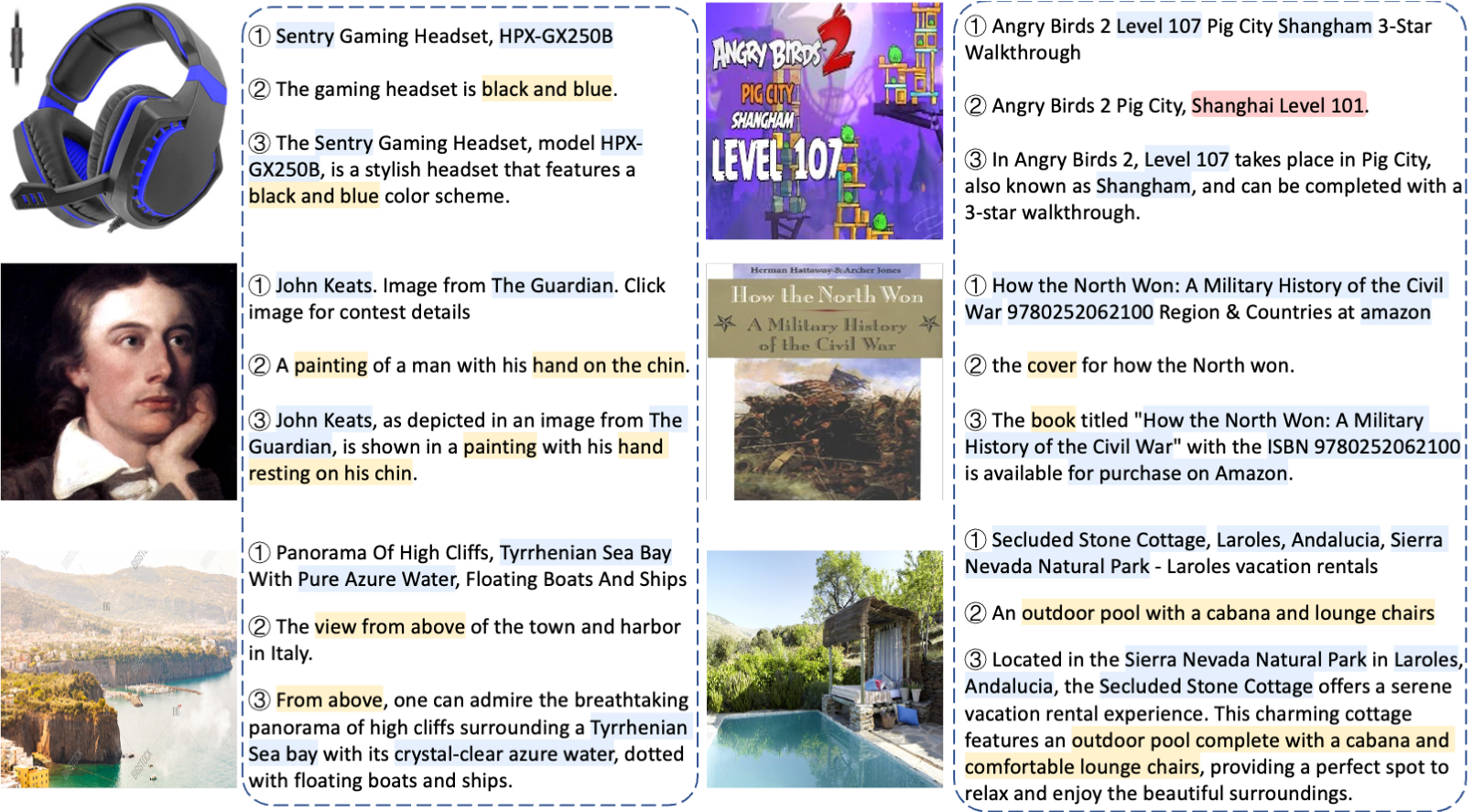

上图展示了CapsFusion如何融合来自原始网络标题(蓝色)和合成标题(黄色)的信息,生成更全面、准确的标题描述。

经过CapsFusion标题训练的模型在基准评估中超越了使用真实标题和合成标题训练的模型,同时展现出丰富的现实世界知识:

结论

CapsFusion为大规模多模态预训练提供了一种新的思路。通过有机融合真实和合成标题的优势,CapsFusion解决了现有方法中的关键问题,为未来大规模LMM训练提供了一个有前景的候选方案。其在效果、效率和可扩展性方面的优势,使CapsFusion成为推动多模态AI发展的重要工具。

随着CapsFusion-120M数据集的发布和CapsFus-LLaMA模型的开源,研究人员和开发者现在可以更深入地探索和利用这一创新框架,为多模态AI的进步做出贡献。未来,我们可以期待看到更多基于CapsFusion的应用和研究,进一步推动多模态AI技术的发展。