ChatGPT的失败案例分析:11大类型及其影响

随着ChatGPT的迅速崛起,这款由OpenAI开发的大型语言模型在许多方面展现出了令人惊叹的能力。然而,与此同时,它也暴露出了不少局限性和缺陷。本文将深入分析ChatGPT在11个主要类别中的失败案例,探讨这些失败背后的原因,以及它们对AI发展的启示。

1. 推理能力的局限性

ChatGPT在某些推理任务中表现出色,但在另一些任务中却显得力不从心。以下是几个典型的例子:

1.1 空间推理

在一个涉及空间导航的任务中,ChatGPT无法正确完成。尽管如此,它仍然表现出了一定的空间理解能力,能够将网格框的相对位置转化为语言描述。

1.2 时间推理

当被要求从一个简单的故事中推断事件顺序时,ChatGPT失败了。例如,对于"我去参加派对。我比John先到。David比Joe晚到。Joe比我先到。John比David晚到。谁最先到?"这个问题,ChatGPT无法给出正确答案。

1.3 物理推理

在一些涉及物理概念的问题上,ChatGPT也表现不佳。例如,它无法正确回答"什么东西太小了?"这个问题,当给出上下文"奖杯放不进手提箱因为它太小了"。

1.4 心理推理

在一些涉及人类行为和心理过程的问题上,ChatGPT同样显示出了局限性。

这些案例表明,尽管ChatGPT在某些领域表现出色,但它仍然缺乏人类那样全面的推理能力。它无法像人类一样灵活地运用各种推理方式来解决问题。

2. 逻辑错误

ChatGPT在处理某些逻辑问题时会出现明显错误。例如,在一个简单的代数表达式简化任务中,它无法正确处理(X³ + X² + X + 1)(X - 1)这个表达式。这表明ChatGPT在处理抽象的逻辑关系时存在困难。

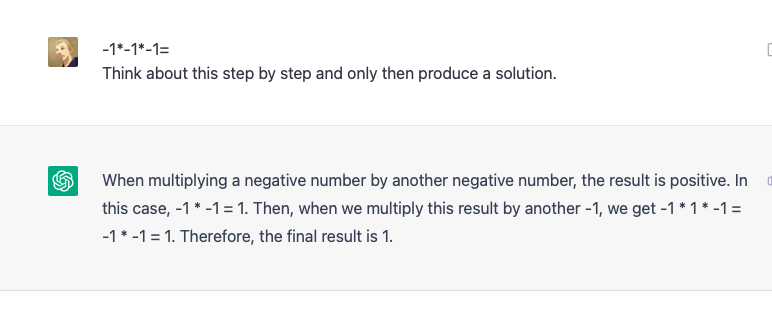

3. 数学和算术错误

ChatGPT在进行基本的数学计算时也会犯错。例如,它无法正确计算-1 * -1 * -1的结果。此外,在处理大数乘法、求根、计算幂(特别是分数幂)以及与无理数相加减等任务时,ChatGPT都表现出了明显的局限性。

4. 事实性错误

ChatGPT有时会产生与事实不符的信息。例如,在回答有关阿根廷世界杯冠军次数的问题时,ChatGPT前后矛盾,无法提供准确信息。这种现象被称为"幻觉",即模型生成的内容与其训练数据不一致。

5. 偏见和歧视

尽管OpenAI在ChatGPT中实施了安全协议,但它仍然可能产生带有偏见或歧视性的内容。例如,在一个涉及刑讯的假设场景中,ChatGPT给出了令人不安的回答,表明某些类型的人可以被"公平地"刑讯。这凸显了AI系统中潜在的伦理问题。

6. 字符/子串/音节处理错误

ChatGPT在处理特定的语言结构任务时也会出错。例如,它无法正确写出以特定字母结尾的句子,或者识别包含特定子串的单词。这表明ChatGPT在语言的微观结构处理上仍有不足。

7. 常识和技巧性问题

在一些需要常识或技巧性思维的问题上,ChatGPT往往会失败。例如,它错误地认为9个女性可以在1个月内生一个孩子。这类错误反映了ChatGPT缺乏真正的世界知识和常识推理能力。

8. 相关性vs.因果关系

ChatGPT在区分相关性和因果关系方面存在困难。例如,在解释太阳镜销量和冰淇淋销量之间关系的问题上,它无法正确理解这两者之间并非直接的因果关系。

9. 家庭关系问题

在处理复杂的家庭关系问题时,ChatGPT也常常出错。例如,它无法正确识别"Mike的妈妈有4个孩子,其中3个是Luis、Drake和Matilda,第4个孩子是谁?"这个问题中的隐含信息。

10. 游戏规则理解

ChatGPT在理解和执行某些游戏规则时表现不佳。例如,它在井字游戏中无法正确判断胜负,在国际象棋中对基本规则也存在误解。这反映了ChatGPT在理解和应用复杂规则系统方面的局限性。

11. 幻觉和记忆错误

ChatGPT有时会产生完全虚构的信息,或者错误地"记忆"不存在的事实。例如,它曾编造出一个不存在的性骚扰丑闻,并将一位真实存在的法学教授列为被指控者。这种现象被称为"幻觉",是大型语言模型面临的一个重要挑战。

结论与启示

通过分析ChatGPT在这11个类别中的失败案例,我们可以得出以下几点重要启示:

-

尽管ChatGPT在许多方面表现出色,但它仍然缺乏人类那样全面和灵活的推理能力。

-

ChatGPT的知识虽然广泛,但往往缺乏深度和准确性,特别是在需要专业知识的领域。

-

模型存在明显的偏见和伦理问题,这需要在未来的开发中加以重视和解决。

-

ChatGPT缺乏真正的理解力和常识推理能力,这限制了它在复杂任务中的表现。

-

"幻觉"问题是大型语言模型面临的一个重要挑战,需要进一步的研究和改进。

这些失败案例不应被视为对ChatGPT价值的否定,而应该被看作是推动AI技术进步的重要动力。通过不断识别和解决这些问题,我们可以开发出更加强大、可靠和有益的AI系统。

未来的研究方向应该包括:提高模型的推理能力,增强其对世界知识的深入理解,解决偏见和伦理问题,以及开发更有效的方法来防止"幻觉"的产生。同时,我们也需要提高公众对AI系统局限性的认识,以促进其负责任和有效的使用。

总的来说,ChatGPT的这些失败案例为我们提供了宝贵的洞察,帮助我们更好地理解当前AI技术的能力和局限。通过不断学习和改进,我们有望在未来开发出更加智能和可靠的AI系统,为人类社会带来更大的价值。