DiCE:通过多样化反事实解释机器学习模型

在当今社会,机器学习模型被广泛应用于金融、医疗、教育和刑事司法等重要领域的决策过程中。然而,这些模型的决策过程往往是不透明的,这就引发了一个关键问题:如何解释机器学习模型,使其既忠实于模型本身,又能被人所理解?

为了解决这一问题,微软研究院的研究人员开发了DiCE(Diverse Counterfactual Explanations)库。DiCE是一个开源的Python库,旨在为任何机器学习模型生成多样化的反事实解释。本文将详细介绍DiCE的功能、使用方法和应用场景。

什么是反事实解释?

反事实解释是一种解释机器学习模型决策的方法。它通过展示输入数据的微小变化如何影响模型的输出来帮助理解模型的决策过程。例如,假设一个人申请贷款被拒绝,传统的解释可能只会告诉他"信用记录不佳"。然而,这样的解释并不能帮助申请人了解如何改善自己的情况。相比之下,反事实解释会提供更具体的信息,比如"如果你的收入增加10,000美元,你就可以获得贷款"。这种解释不仅指出了问题所在,还为申请人提供了可行的改进方向。

DiCE的核心功能

DiCE的核心功能是生成多样化的反事实解释。它通过以下几个方面实现这一目标:

-

多样性: DiCE可以生成多个不同的反事实解释,为用户提供多种选择。

-

可调节性: 用户可以通过调整参数来控制生成的反事实解释的多样性和与原始输入的接近程度。

-

可行性约束: DiCE允许用户指定特征的变化范围,确保生成的反事实解释是实际可行的。

-

模型无关性: DiCE支持多种机器学习模型,包括基于sklearn、tensorflow和pytorch的模型。

-

特征重要性: DiCE可以计算局部和全局特征重要性分数,帮助理解模型的决策依据。

如何使用DiCE

使用DiCE生成反事实解释只需简单的三个步骤:

- 设置数据集

- 训练模型(或使用预训练模型)

- 调用DiCE生成反事实解释

以下是一个简单的代码示例:

import dice_ml

from dice_ml.utils import helpers

from sklearn.model_selection import train_test_split

# 加载数据集

dataset = helpers.load_adult_income_dataset()

target = dataset["income"]

train_dataset, test_dataset, _, _ = train_test_split(dataset,

target,

test_size=0.2,

random_state=0,

stratify=target)

# 设置数据集

d = dice_ml.Data(dataframe=train_dataset,

continuous_features=["age", "hours_per_week"],

outcome_name="income")

# 使用预训练模型

m = dice_ml.Model(model_path=dice_ml.utils.helpers.get_adult_income_modelpath(),

backend='TF2', func="ohe-min-max")

# 创建DiCE实例

exp = dice_ml.Dice(d,m)

# 生成反事实解释

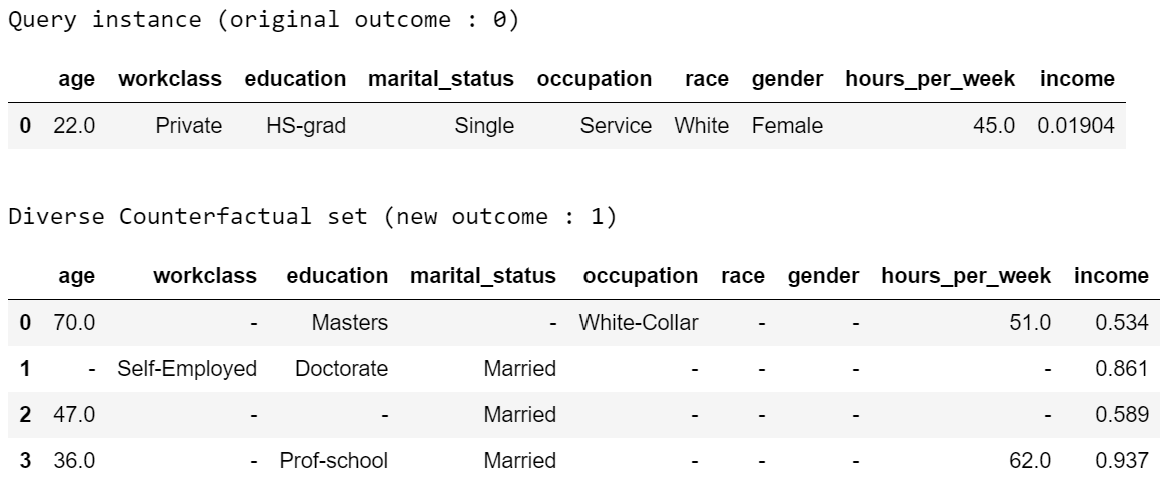

query_instance = test_dataset.drop(columns="income")[0:1]

dice_exp = exp.generate_counterfactuals(query_instance, total_CFs=4, desired_class="opposite")

# 可视化反事实解释

dice_exp.visualize_as_dataframe()

DiCE的应用场景

DiCE的反事实解释方法可以在多个场景中发挥作用:

-

决策主体: 对于受到机器学习模型决策影响的个人,DiCE可以提供可行的改进建议,帮助他们理解如何改变自己的状况以获得不同的结果。

-

机器学习模型开发者: DiCE可以帮助开发者调试模型,发现潜在的问题,如某些特征对模型决策的不恰当影响。

-

决策者: 对于使用机器学习模型辅助决策的医生或法官等专业人士,DiCE可以帮助他们深入了解模型的决策依据,增强对模型预测的信任。

-

决策评估者: 对于关注机器学习模型公平性等属性的评估者,DiCE提供了一种新的评估视角。

DiCE的优势

-

模型无关性: DiCE支持多种机器学习模型,包括基于sklearn、tensorflow和pytorch的模型。

-

灵活性: 用户可以通过调整参数来控制生成的反事实解释的多样性和与原始输入的接近程度。

-

可解释性: DiCE生成的反事实解释直观易懂,有助于非技术人员理解模型决策。

-

特征重要性分析: DiCE可以计算局部和全局特征重要性分数,提供更深入的模型解释。

-

开源: DiCE是一个开源项目,社区可以不断改进和扩展其功能。

未来发展

DiCE团队正在努力添加以下功能:

- 支持使用DiCE调试机器学习模型

- 生成更自然的英语解释

- 使用反事实评估LIME和SHAP等特征归因方法

- 支持贝叶斯优化等算法生成反事实解释

- 改进反事实生成的可行性约束

结论

在机器学习模型日益复杂和普及的今天,如何解释这些模型的决策过程变得越来越重要。DiCE通过生成多样化的反事实解释,为这一挑战提供了一个创新的解决方案。无论是模型开发者、决策者还是受决策影响的个人,都可以从DiCE生成的解释中获益。随着项目的不断发展和完善,DiCE有望成为推动机器学习可解释性研究的重要工具。

对于那些希望深入了解和使用DiCE的读者,可以访问DiCE的GitHub仓库获取更多信息和示例代码。同时,DiCE团队也欢迎社区贡献,共同推动这一重要领域的发展。