EasyVtuber: 打造你自己的虚拟主播

在虚拟主播和虚拟YouTuber(VTuber)日益流行的今天,如何低成本、高质量地制作虚拟形象成为了许多内容创作者关注的焦点。EasyVtuber项目应运而生,为广大创作者提供了一个开源、易用的虚拟主播解决方案。

EasyVtuber简介

EasyVtuber是一个基于深度学习的开源虚拟主播项目,由GitHub用户yuyuyzl开发。该项目fork自GunwooHan的EasyVtuber,并进行了多项优化和功能增强。EasyVtuber的主要特点包括:

- 高质量面部捕捉:支持iOS设备的iFacialMocap和基于OpenCV的面部追踪

- 流畅的动画效果:在RTX 3080上可达到40FPS的帧率

- 支持透明背景输出:可直接集成到OBS等直播软件中

- 易于安装和使用:提供多种安装方式,包括嵌入式Python版本

安装配置

EasyVtuber提供了多种安装方式,以适应不同用户的需求。以下是最推荐的嵌入式Python版本的安装步骤:

- 下载并解压EasyVtuber项目文件

- 下载预训练模型并放置到正确目录

- 运行构建脚本安装依赖

- 使用启动器测试安装结果

对于需要更灵活控制的用户,也可以选择Venv版本或Conda版本进行安装。详细的安装步骤可以参考项目的README文档。

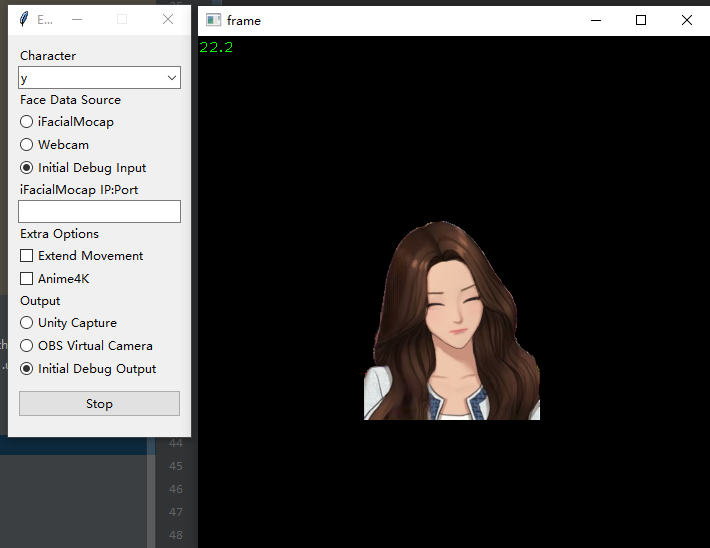

输入输出设备配置

EasyVtuber支持多种输入和输出设备,主要包括:

-

输入设备:

- iFacialMocap (iOS设备)

- OpenSeeFace (普通网络摄像头)

-

输出设备:

- OBS Virtual Camera

- UnityCapture

其中,OBS Virtual Camera是目前更推荐的输出方案。如果需要支持RGBA透明通道,还需要额外安装StreamFX插件和使用特定的Shader。

运行和使用

完成安装和设备配置后,可以通过以下命令运行EasyVtuber:

python main.py --output_webcam unitycapture --ifm 192.168.31.182:49983 --character test1L2 --extend_movement 1 --output_size 512x512

主要参数说明:

--character: 指定使用的角色模型--ifm: 设置iFacialMocap的IP和端口--extend_movement: 启用扩展移动,使上半身可动--output_size: 设置输出图像大小

进阶使用技巧

-

自定义角色: 可以在

character目录下添加自己的角色图像,命名格式为角色名.png。 -

调整动画效果: 通过修改

--extend_movement参数的值,可以调整角色的动作幅度。 -

优化性能: 如果遇到性能问题,可以尝试降低

--output_size或调整其他参数。 -

集成到直播软件: 将EasyVtuber的输出作为OBS的视频源,即可在直播中使用虚拟形象。

EasyVtuber的优势

-

开源免费:相比商业解决方案,EasyVtuber完全开源且免费使用。

-

高质量效果:借助深度学习技术,实现了流畅自然的面部动画。

-

低硬件要求:仅需一台支持CUDA的NVIDIA显卡即可运行。

-

灵活可定制:开放源代码允许用户根据需求进行修改和优化。

-

活跃的社区:GitHub上有大量用户参与讨论和贡献,持续改进项目。

未来展望

EasyVtuber项目仍在积极开发中,未来可能会有更多exciting的功能加入:

- 支持更多输入设备和面部追踪算法

- 提供更丰富的角色模型和动画效果

- 优化性能,支持更低端的硬件设备

- 增加更多直播软件的集成支持

结语

EasyVtuber为想要尝试虚拟主播的创作者提供了一个极具吸引力的选择。它不仅降低了入门门槛,还提供了高质量的面部捕捉和动画效果。无论你是想成为下一个虚拟主播明星,还是只是想在直播中添加一些有趣的元素,EasyVtuber都是一个值得尝试的工具。

让我们一起期待EasyVtuber的未来发展,也欢迎更多的开发者加入到这个项目中来,共同推动虚拟主播技术的进步! 🚀✨