Follow-Your-Emoji:开启肖像动画新时代

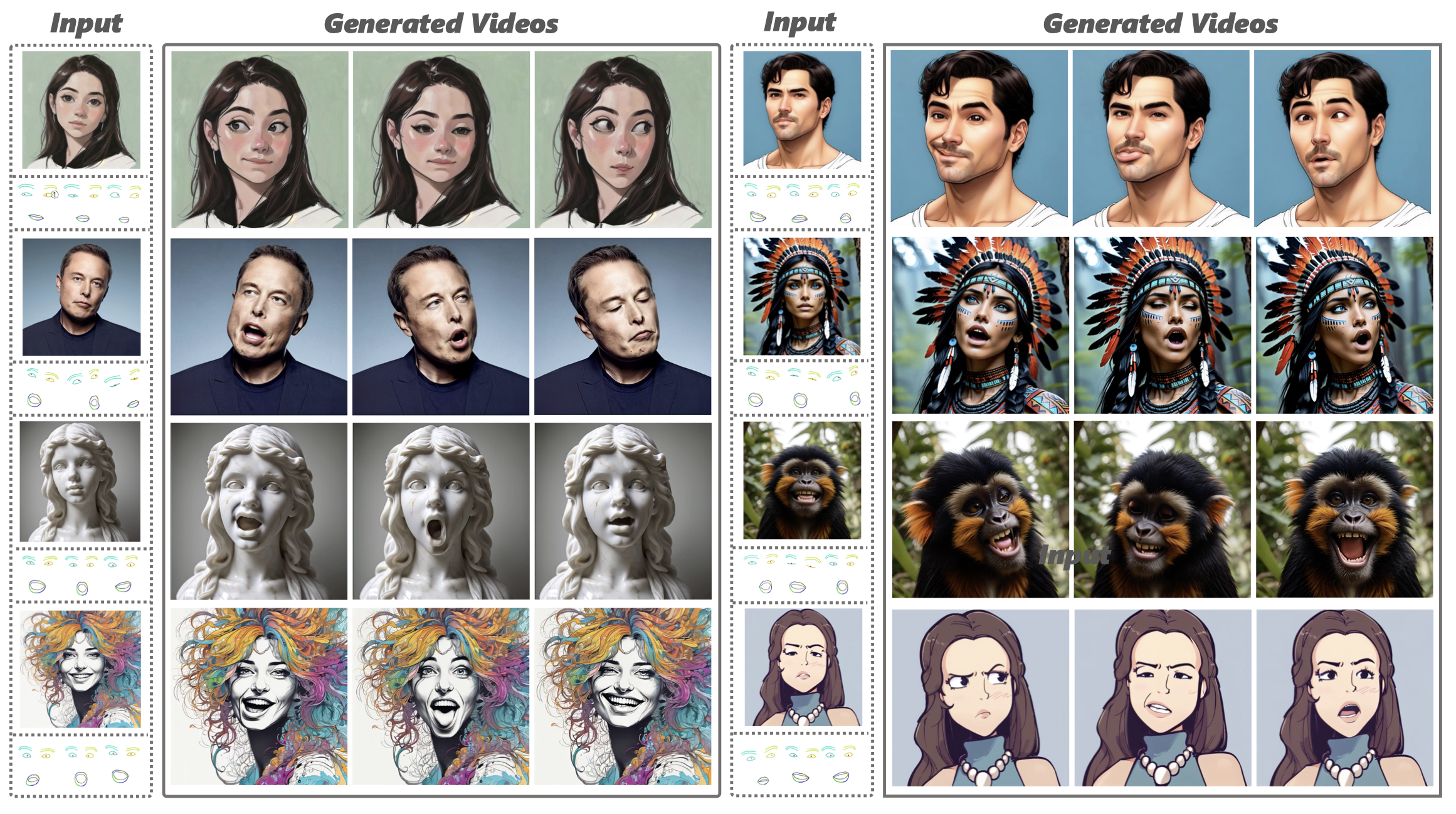

在数字内容创作领域,如何让静态图像"动"起来一直是一个极具挑战性的课题。近日,来自香港科技大学等机构的研究团队提出了一种名为"Follow-Your-Emoji"的创新方法,为肖像动画带来了突破性进展。这项技术不仅可以让普通照片栩栩如生,更能将卡通、雕塑甚至动物肖像赋予灵动表情,堪称肖像动画领域的一大里程碑。

核心技术:精准控制与丰富表现

Follow-Your-Emoji的核心在于其独特的技术设计。研究团队基于强大的Stable Diffusion模型,巧妙地融入了两项关键技术:

-

表情感知特征点:这是一种全新的显式运动信号,用于指导动画过程。它不仅确保了参考肖像和目标动作之间的精确对齐,还提高了模型描绘夸张表情(如大幅度瞳孔运动)的能力,同时避免了身份泄露问题。

-

面部精细损失函数:通过同时使用表情和面部掩码,该函数显著提升了模型感知微妙表情变化和重建参考肖像外观的能力。

这两项技术的结合使得Follow-Your-Emoji在控制各种风格肖像表情方面展现出卓越性能,无论是真实人物、卡通形象、雕塑作品,还是动物肖像,都能实现自然流畅的动画效果。

广泛应用前景

Follow-Your-Emoji的应用潜力十分广阔。在娱乐领域,它可以为电影特效、游戏角色设计等提供全新的创作可能。在教育方面,历史人物或科学概念可以通过生动的动画形式呈现,增强学习趣味性。在广告营销中,品牌形象可以更具互动性和吸引力。此外,在社交媒体和个人内容创作方面,用户可以轻松将自己或他人的照片转化为有趣的动画表情包。

技术细节与实现

Follow-Your-Emoji的实现依赖于几个关键组件:

-

基础模型:使用lambdalabs/sd-image-variations-diffusers作为起点。

-

VAE模型:采用stabilityai/sd-vae-ft-mse进行图像编码和解码。

-

AnimateDiff:集成guoyww/animatediff模型以增强动画连贯性。

-

自定义组件:包括特征点引导器(lmk_guider)、参考网络(referencenet)和改进的UNet模型。

研究团队已在Hugging Face上开源了预训练权重,方便其他研究者和开发者进行进一步探索和应用。

开源与社区贡献

Follow-Your-Emoji项目秉持开源精神,鼓励社区参与和贡献。项目在GitHub上的官方仓库提供了详细的使用说明和示例代码。研究团队还开发了配套工具,如用于生成自定义表情模板的Jupyter notebook脚本,使用户能够轻松创建个性化的动画效果。

此外,社区成员已经为项目贡献了额外的功能,如Colab版本和OpenXLab应用,进一步降低了技术门槛,使更多人能够体验这一创新技术。

未来展望

随着人工智能和计算机视觉技术的不断进步,Follow-Your-Emoji代表的肖像动画技术有望在未来获得更广泛的应用和发展。我们可以期待看到:

-

实时渲染:技术优化可能使动画生成速度大幅提升,实现实时或近实时的肖像动画。

-

多模态整合:结合语音合成、自然语言处理等技术,创造出能说会道的动态虚拟形象。

-

个性化定制:深度学习模型可能学会捕捉个人独特的表情和动作习惯,生成更具个性的动画效果。

-

跨领域应用:从医疗(如面部康复训练)到安防(如动态人脸识别),肖像动画技术可能找到更多创新应用场景。

Follow-Your-Emoji的出现,不仅为内容创作者提供了强大的新工具,也为人机交互、虚拟现实等领域带来了新的可能性。随着技术的不断完善和社区的积极参与,我们有理由相信,未来的数字世界将会更加生动、有趣和富有表现力。

无论您是研究人员、开发者,还是对新技术充满好奇的普通用户,Follow-Your-Emoji都值得您关注和尝试。它不仅代表了计算机图形学和人工智能的最新进展,更展示了技术如何为人类创造力赋能,开启无限可能。

让我们共同期待Follow-Your-Emoji及其背后技术的进一步发展,见证数字内容创作的新纪元。