imbalanced-ensemble: 强大的类别不平衡集成学习工具库

在机器学习领域,类别不平衡问题一直是一个具有挑战性的研究方向。当数据集中不同类别的样本数量差异很大时,传统的机器学习算法往往会偏向于多数类,导致对少数类的预测性能较差。为了解决这一问题,研究人员提出了许多专门针对不平衡数据的学习算法,其中集成学习方法表现尤为突出。

imbalanced-ensemble(简称imbens)正是一个专门用于处理类别不平衡问题的集成学习Python库。它提供了一系列先进的集成不平衡学习算法实现,以及强大的评估和可视化功能,旨在帮助研究人员和工程师更便捷地开发和部署不平衡学习模型。

主要特性

imbalanced-ensemble具有以下突出特点:

- 丰富的算法实现:目前已包含15种以上的集成不平衡学习算法,如SelfPacedEnsemble, SMOTEBoost, RUSBoost等,以及19种来自imbalance-learn的过采样/欠采样方法。

- 易用的API:遵循scikit-learn风格的API设计,使用简单直观。

- 优化的性能:利用joblib实现并行计算,提高了算法的运行效率。

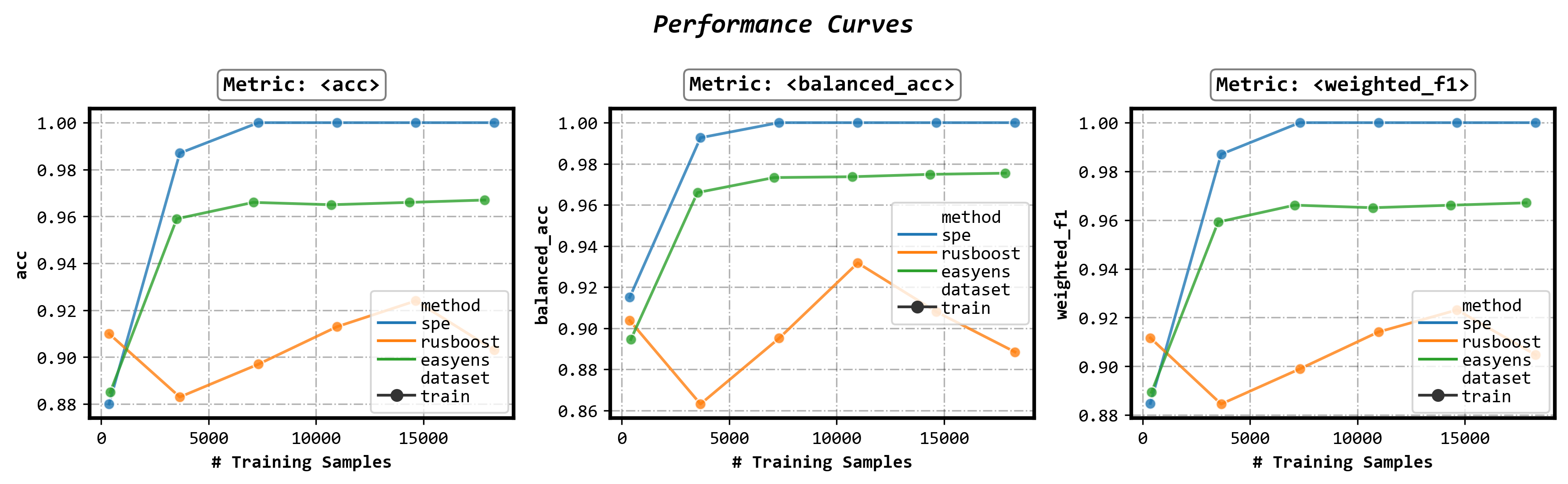

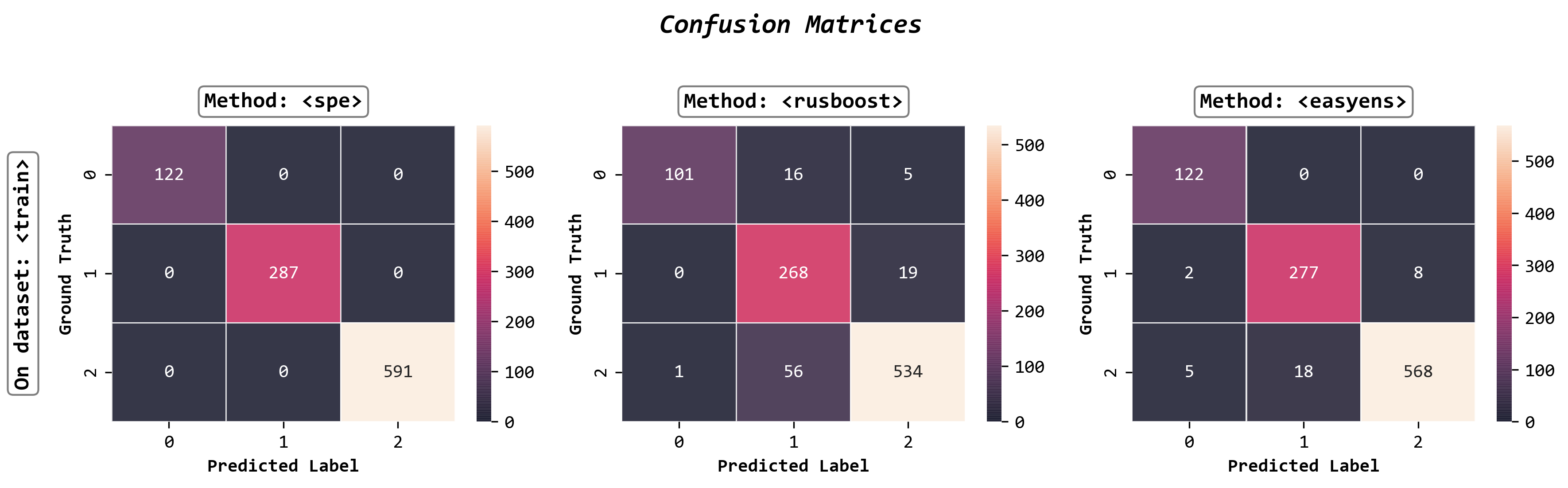

- 强大的可视化:内置的ImbalancedEnsembleVisualizer可以方便地绘制性能曲线、混淆矩阵等图表。

- 灵活的训练监控:支持自定义训练日志,可以实时跟踪模型训练过程。

- 良好的兼容性:与scikit-learn和imbalance-learn完全兼容。

- 多类扩展:将现有的二分类技术扩展到多类场景。

快速上手

使用imbalanced-ensemble构建一个不平衡学习分类器只需寥寥数行代码:

from imbens.ensemble import SelfPacedEnsembleClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

# 生成不平衡数据集

X, y = make_classification(n_samples=1000, n_classes=3,

n_informative=4, weights=[0.2, 0.3, 0.5],

random_state=0)

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42)

# 训练SelfPacedEnsemble分类器

clf = SelfPacedEnsembleClassifier(random_state=0)

clf.fit(X_train, y_train)

# 预测

y_pred = clf.predict(X_test)

可视化功能

imbalanced-ensemble提供了强大的可视化工具ImbalancedEnsembleVisualizer,可以方便地对比不同集成算法的性能:

from imbens.ensemble import SelfPacedEnsembleClassifier, RUSBoostClassifier, EasyEnsembleClassifier

from imbens.visualizer import ImbalancedEnsembleVisualizer

from sklearn.tree import DecisionTreeClassifier

# 训练多个集成分类器

init_kwargs = {'estimator': DecisionTreeClassifier()}

ensembles = {

'spe': SelfPacedEnsembleClassifier(**init_kwargs).fit(X_train, y_train),

'rusboost': RUSBoostClassifier(**init_kwargs).fit(X_train, y_train),

'easyens': EasyEnsembleClassifier(**init_kwargs).fit(X_train, y_train),

}

# 创建可视化器

visualizer = ImbalancedEnsembleVisualizer().fit(ensembles=ensembles)

# 绘制性能曲线

fig, axes = visualizer.performance_lineplot()

# 绘制混淆矩阵

fig, axes = visualizer.confusion_matrix_heatmap()

自定义训练日志

imbalanced-ensemble支持灵活的训练日志配置,可以实时监控模型训练过程:

clf.fit(X_train, y_train,

train_verbose={

'granularity': 10,

'print_distribution': False,

'print_metrics': True,

})

这将每训练10个基学习器输出一次性能指标,方便用户跟踪训练进度。

算法列表

imbalanced-ensemble实现了多种主流的集成不平衡学习算法,大致可分为以下几类:

-

基于重采样的方法:

- 欠采样+集成:SelfPacedEnsembleClassifier, BalanceCascadeClassifier, EasyEnsembleClassifier等

- 过采样+集成:OverBoostClassifier, SMOTEBoostClassifier, SMOTEBaggingClassifier等

-

基于代价敏感的方法:

- AdaCostClassifier, AdaUBoostClassifier, AsymBoostClassifier等

-

兼容方法:

- CompatibleAdaBoostClassifier, CompatibleBaggingClassifier

这些算法涵盖了不平衡学习领域的主要技术路线,为用户提供了丰富的选择。

总结

imbalanced-ensemble为处理类别不平衡问题提供了一个全面而强大的工具集。它不仅实现了多种先进的集成不平衡学习算法,还提供了便捷的评估和可视化功能,大大简化了不平衡学习模型的开发和部署过程。无论是研究人员还是实践者,都可以从这个库中获益良多。

对于那些正在处理不平衡数据集的机器学习从业者来说,imbalanced-ensemble无疑是一个值得尝试的工具。它可以帮助用户快速实现和比较不同的不平衡学习策略,从而找到最适合特定问题的解决方案。

随着类别不平衡问题在现实世界中的普遍存在,imbalanced-ensemble这样的专业工具库必将发挥越来越重要的作用。我们期待看到更多研究者和开发者参与到这个项目中来,共同推动不平衡学习领域的发展。