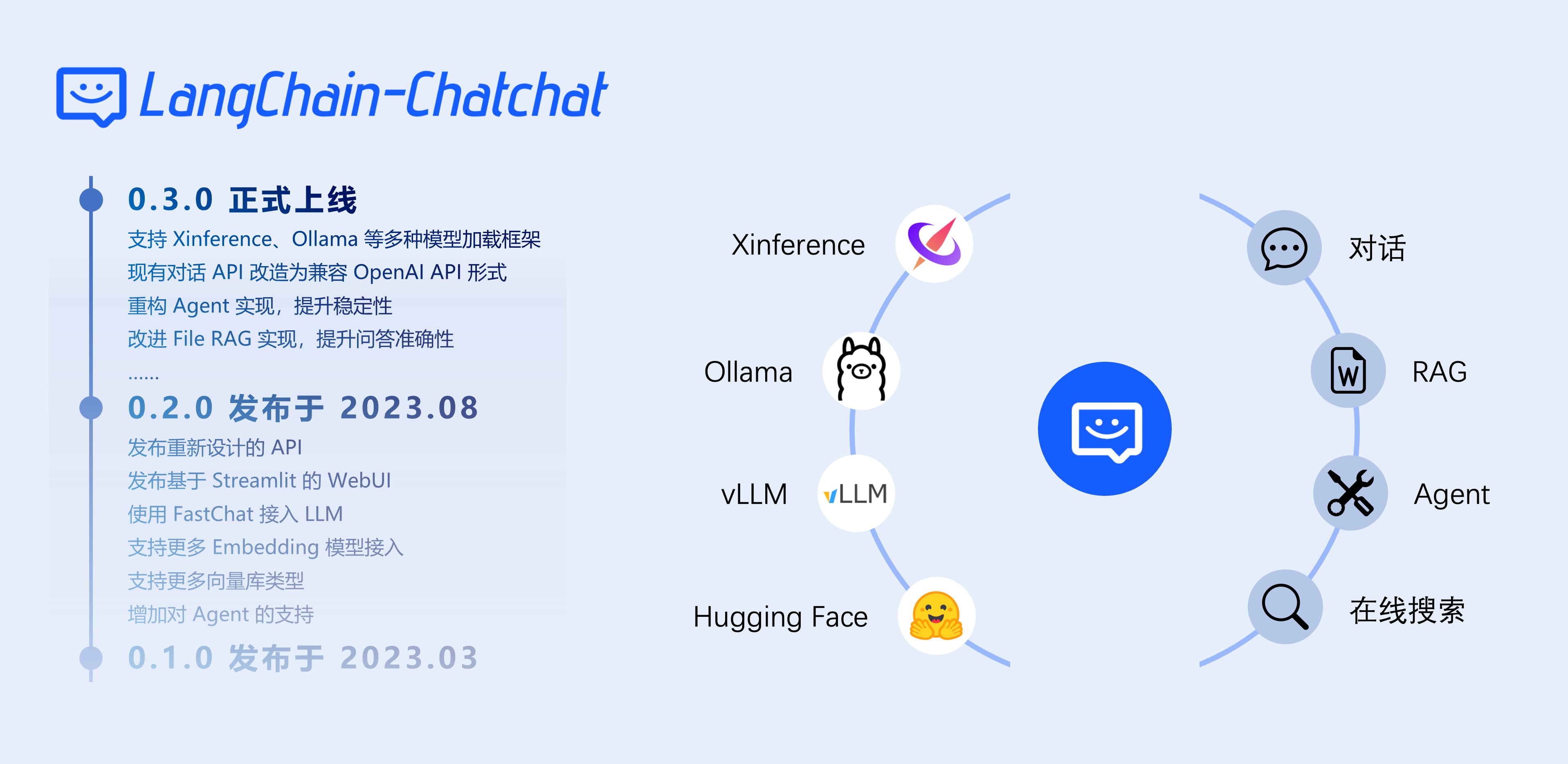

Langchain-Chatchat项目简介

Langchain-Chatchat(原Langchain-ChatGLM)是一个开源的、可离线部署的基于大语言模型的RAG(检索增强生成)和Agent应用项目。它基于ChatGLM等大语言模型和Langchain应用框架实现,旨在打造一个适合中文场景、支持开源模型的知识库问答解决方案。

主要功能

Langchain-Chatchat 0.3.x版本的核心功能包括:

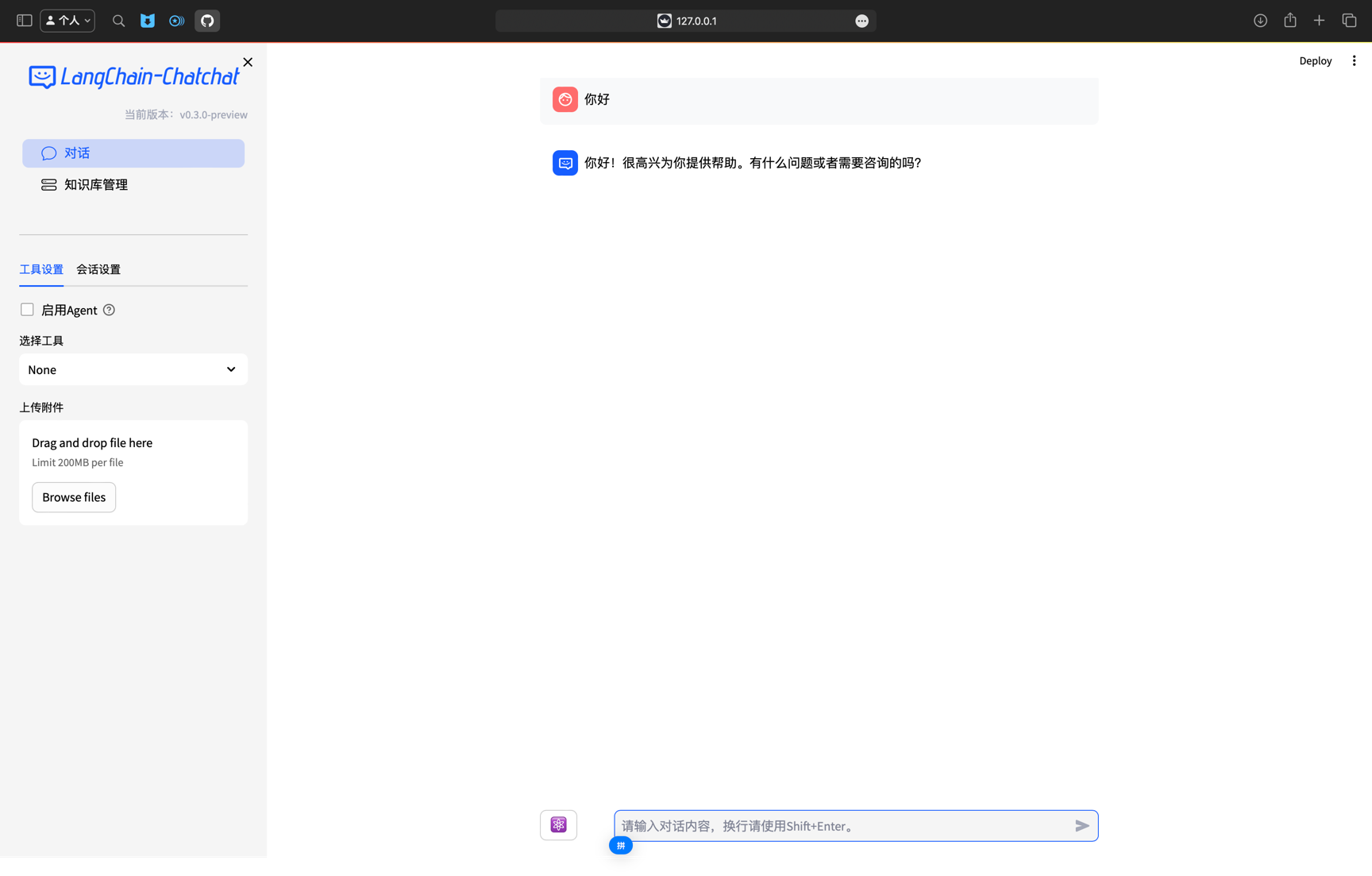

- LLM对话

- 知识库问答

- 搜索引擎对话

- 文件对话(File RAG)

- 数据库对话

- 多模态图片对话

- ARXIV文献对话

- Wolfram对话

- 文生图

- 本地知识库管理

此外,该项目还支持Agent功能,可以根据不同模型的能力选择是否启用Agent。

支持的模型与框架

Langchain-Chatchat支持多种主流的开源大语言模型和embedding模型,包括:

- GLM-4-Chat

- Qwen2-Instruct

- Llama3

支持的模型部署框架有:

- Xinference

- LocalAI

- Ollama

- FastChat

同时也支持调用OpenAI、智谱AI等在线API。

快速上手

1. 安装

pip install langchain-chatchat -U

如需使用Xinference框架:

pip install "langchain-chatchat[xinference]" -U

2. 启动模型服务

选择一个模型部署框架(如Xinference)并启动模型服务。

3. 配置项目

初始化配置:

chatchat init

修改model_settings.yaml中的模型配置。

4. 初始化知识库

chatchat kb -r

5. 启动项目

chatchat run

访问Web UI即可开始使用。

更多学习资源

欢迎加入项目交流群讨论更多使用经验!

Langchain-Chatchat作为一个功能丰富的开源RAG项目,为构建基于大语言模型的知识问答系统提供了便利。希望本文的介绍能帮助您快速上手使用该项目,构建适合自己需求的AI应用。