LangStream:面向未来的 AI 应用开发平台

在人工智能技术快速发展的今天,如何高效地开发和部署 AI 应用已成为众多开发者面临的挑战。LangStream 应运而生,为开发者提供了一个强大的事件驱动平台,专门用于构建和运行大型语言模型(LLM)应用。让我们深入了解这个创新平台的特性和优势。

什么是 LangStream?

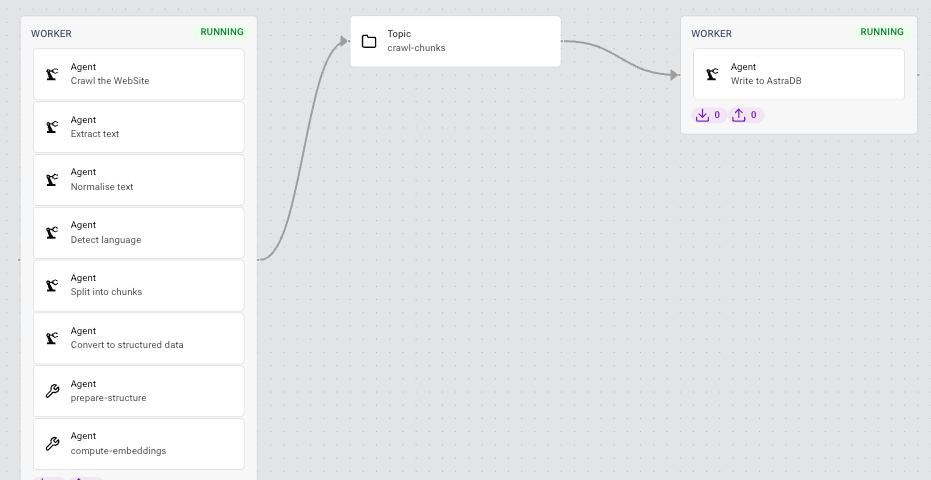

LangStream 是一个开源的事件驱动开发者平台,专门用于构建和运行 LLM 应用。它由 Kubernetes 和 Kafka 提供支持,为开发者提供了一个灵活而强大的工具,可以轻松创建复杂的 AI 驱动应用。

LangStream 的核心优势包括:

-

事件驱动架构:基于 Kafka 的事件流处理,实现高吞吐量和低延迟。

-

云原生:完全基于 Kubernetes,支持灵活的扩展和部署。

-

开放集成:支持多种 LLM、向量数据库和 AI 工具的集成。

-

简化开发:提供直观的 YAML 配置和 CLI 工具,降低开发门槛。

-

生产就绪:内置监控、日志和安全功能,适合企业级应用。

LangStream 的核心功能

- LLM 集成

LangStream 支持与多种主流大型语言模型的无缝集成,包括 OpenAI、Google Vertex AI 和 Hugging Face 等。这使得开发者可以轻松利用最先进的 AI 能力,而无需深入了解底层实现细节。

- 向量数据库支持

为了支持高效的语义搜索和相似度匹配,LangStream 集成了多种向量数据库,如 Pinecone 和 DataStax。这为构建智能检索系统和推荐引擎提供了强大支持。

- Python 库集成

LangStream 与流行的 Python AI 库如 LangChain 和 LlamaIndex 无缝集成,让开发者可以利用这些库的强大功能,同时享受 LangStream 的事件驱动和分布式处理能力。

- 事件流处理

基于 Kafka 的事件流处理是 LangStream 的核心特性之一。它允许应用以高吞吐量和低延迟处理大规模实时数据,非常适合构建实时 AI 服务和数据管道。

- 云原生部署

LangStream 完全基于 Kubernetes,支持在各种云环境中灵活部署和扩展。无论是公有云、私有云还是混合云环境,LangStream 都能提供一致的开发和运行体验。

快速上手 LangStream

要开始使用 LangStream,您需要先安装 LangStream CLI。以下是在 MacOS 上通过 Homebrew 安装的方法:

brew install LangStream/langstream/langstream

安装完成后,您可以使用以下命令验证安装:

langstream -V

接下来,让我们运行一个简单的示例应用:

export OPEN_AI_ACCESS_KEY=your-key-here

langstream docker run test

-app https://github.com/LangStream/langstream/blob/main/examples/applications/openai-completions

-s https://github.com/LangStream/langstream/blob/main/examples/secrets/secrets.yaml

这个命令会启动一个基于 OpenAI 的聊天补全应用。在另一个终端窗口中,您可以使用以下命令与应用进行交互:

langstream gateway chat test -cg consume-output -pg produce-input -p sessionId=$(uuidgen)

构建自己的 LangStream 应用

LangStream 使用 YAML 文件来定义应用的结构和行为。以下是一个简单的 LangStream 应用配置示例:

name: "My First LangStream App"

topics:

- name: "input-topic"

creation-mode: create-if-not-exists

- name: "output-topic"

creation-mode: create-if-not-exists

pipeline:

- name: "process-messages"

type: "processor"

input: "input-topic"

output: "output-topic"

configuration:

className: "ai.langstream.ai.processors.LLMProcessor"

properties:

promptTemplate: "Summarize the following text: {{message}}"

llm:

type: "openai"

model: "gpt-3.5-turbo"

这个配置定义了一个简单的管道,它从输入主题读取消息,使用 OpenAI 的 GPT-3.5-turbo 模型生成摘要,然后将结果写入输出主题。

在 Kubernetes 上部署 LangStream

对于生产环境,建议在 Kubernetes 集群上部署 LangStream。您可以使用 Helm chart 来简化部署过程:

helm repo add langstream https://langstream.ai/charts

helm repo update

# 创建 values.yaml 文件,配置存储服务等

helm install -n langstream --create-namespace langstream langstream/langstream --values values.yaml

kubectl wait -n langstream deployment/langstream-control-plane --for condition=available --timeout=300s

LangStream 的应用场景

LangStream 的灵活性和强大功能使其适用于多种 AI 应用场景:

-

智能客服系统: 利用 LLM 处理客户查询,提供准确和个性化的回复。

-

内容生成和摘要: 自动生成文章摘要、产品描述或新闻报道。

-

智能文档处理: 从非结构化文档中提取关键信息,支持智能搜索和分析。

-

实时数据分析: 处理和分析流式数据,如社交媒体评论或传感器数据。

-

个性化推荐系统: 结合用户行为数据和 LLM,提供高度个性化的推荐。

LangStream 的未来发展

作为一个活跃的开源项目,LangStream 正在不断发展和改进。未来的发展方向可能包括:

- 支持更多 LLM 和 AI 服务的集成

- 增强的监控和可观察性功能

- 更丰富的预构建组件和模板

- 改进的开发者体验和调试工具

- 支持边缘计算和联合学习场景

结语

LangStream 为 AI 应用开发带来了新的可能性。通过提供一个强大、灵活且易于使用的平台,它使得构建复杂的 LLM 应用变得更加简单和高效。无论您是初创公司还是大型企业,LangStream 都能帮助您快速将 AI 创意转化为现实。

随着 AI 技术的不断进步,LangStream 这样的平台将在推动 AI 应用的广泛采用和创新方面发挥越来越重要的作用。我们期待看到更多基于 LangStream 构建的创新应用,以及它在 AI 开发展的生态系统中的持续发展。

要了解更多关于 LangStream 的信息,欢迎访问官方网站或加入 Slack 社区。现在就开始您的 LangStream 之旅,探索 AI 应用开发的无限可能吧!