LazyLLM: 让AI应用开发变得简单而强大

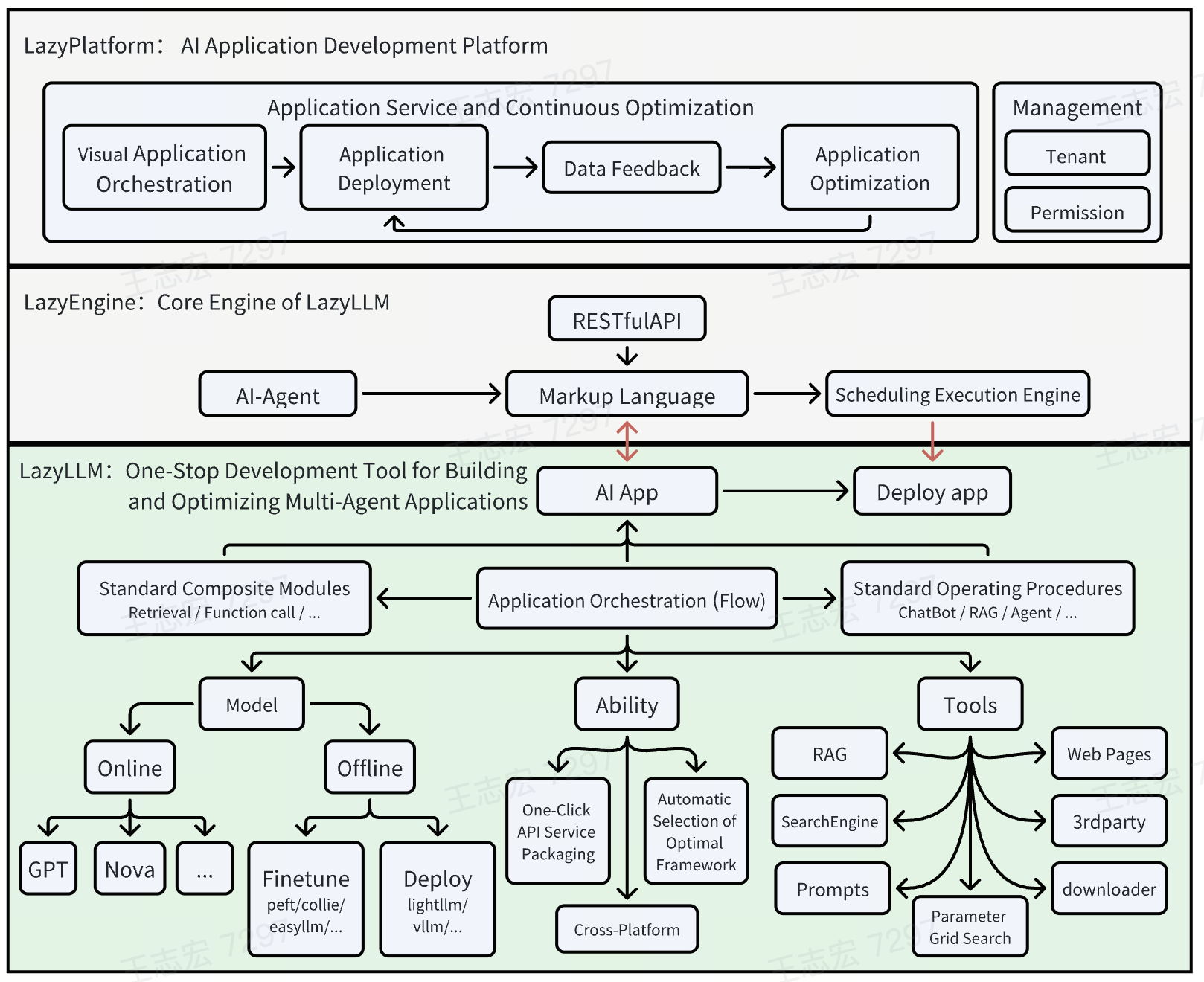

在人工智能快速发展的今天,大语言模型(LLM)的应用已经成为了技术创新的重要方向。然而,构建复杂的多智能体LLM应用往往需要深厚的技术积累和大量的工程投入。为了解决这一难题,LazyLLM应运而生。它是一款旨在简化AI应用开发流程的低代码工具,让开发者能够以更低的成本创建强大的AI应用。

LazyLLM的核心理念

LazyLLM的设计理念源于对当前大模型在生产环境中局限性的深刻理解。开发团队认识到,在现阶段,大模型还无法完全端到端地解决所有实际问题。因此,LazyLLM倡导的AI应用开发流程强调"快速原型构建、使用场景特定数据进行不良案例分析、算法实验和关键方面的模型微调,以提高整体应用性能"。LazyLLM承担了这一过程中繁琐的工程工作,提供了便捷的接口,使用户能够专注于提高算法有效性和创建出色的AI应用。

LazyLLM的主要特性

-

便捷的AI应用组装流程:即使不熟悉大模型,也可以使用内置的数据流和功能模块轻松组装多智能体AI应用,就像搭建乐高积木一样简单。

-

复杂应用的一键部署:LazyLLM提供了所有模块的一键部署能力。在概念验证(POC)阶段,通过轻量级网关机制简化了多智能体应用的部署过程,解决了顺序启动各子模块服务(如LLM、Embedding等)和配置URL的问题,使整个过程更加流畅高效。在应用发布阶段,LazyLLM提供了一键打包镜像的能力,方便利用Kubernetes的网关、负载均衡和容错能力。

-

跨平台兼容性:无需修改代码即可一键切换IaaS平台,兼容裸金属服务器、开发机、Slurm集群、公有云等。这使得开发的应用可以无缝迁移到其他IaaS平台,大大减少了代码修改的工作量。

-

支持网格搜索参数优化:根据用户配置自动尝试不同的基础模型、检索策略和微调参数,以评估和优化应用。这使得超参数调优变得高效,无需对应用代码进行大量侵入式修改,帮助用户快速找到最佳配置。

-

高效的模型微调:支持在应用内微调模型,持续提升应用性能。根据微调场景自动选择最佳的微调框架和模型分割策略。这不仅简化了模型迭代的维护工作,还让算法研究人员能够更专注于算法和数据迭代,而无需处理繁琐的工程任务。

LazyLLM的应用场景

LazyLLM可以用于构建各种常见的人工智能应用。以下是一些典型的应用示例:

-

聊天机器人:LazyLLM提供了简单和高级的聊天机器人实现方式。从基本的对话功能到支持多模态和意图识别的复杂机器人,都可以轻松实现。

-

检索增强生成(RAG):LazyLLM内置了强大的RAG组件,包括文档处理、检索、重排序等功能,可以快速构建基于知识库的问答系统。

-

故事创作助手:利用LazyLLM的流程控制能力,可以轻松实现从大纲生成到具体内容创作的全流程自动化。

-

AI绘画助手:结合大语言模型和图像生成模型,LazyLLM可以创建智能的绘画辅助工具,将用户的文字描述转化为精美的图像。

LazyLLM的核心概念

-

组件(Component):LazyLLM中最小的执行单元,可以是函数或bash命令。组件具有跨平台执行、快速定位等能力。

-

模块(Module):LazyLLM的顶层组件,具备训练、部署、推理和评估四大核心能力。LazyLLM内置了多种基础模块,如ActionModule、UrlModule、ServerModule等,满足不同场景的需求。

-

流(Flow):定义了数据流,描述数据如何从一个可调用对象传递到另一个。LazyLLM实现了多种流程控制方式,如Pipeline、Parallel、Diverter等,几乎可以覆盖所有应用场景。

LazyLLM的优势

-

降低开发门槛:对于新手开发者,LazyLLM彻底简化了AI应用开发流程。他们不再需要担心如何在不同的IaaS平台上调度任务、理解API服务构建的细节、在微调时选择框架或拆分模型,甚至不需要掌握任何Web开发知识。通过预构建的组件和简单的集成操作,新手开发者就能轻松创建具有生产价值的工具。

-

灵活性与可扩展性:对于经验丰富的专家,LazyLLM提供了高度的灵活性。每个模块都支持自定义和扩展,使用户能够无缝集成自己的算法和最先进的生产工具,构建更强大的应用。

-

一致的用户体验:LazyLLM努力确保跨类似模块的一致用户体验。例如,它建立了一套Prompt规则,为在线模型(如ChatGPT、SenseNova、Kimi、ChatGLM等)和本地模型提供了统一的使用方法。这种一致性使您能够在应用中轻松灵活地在本地和在线模型之间切换。

-

精选工具集成:与市场上大多数框架不同,LazyLLM在每个阶段精心选择并集成了2-3个我们认为最具优势的工具。这不仅简化了用户的决策过程,还确保用户能以最低成本构建最具生产力的应用。

未来展望

LazyLLM团队计划在今年年底前支持以下功能:

-

RAG增强:重构RAG模块以移除对llamaindex的依赖,支持在线解析器。

-

应用一键部署:支持Docker一键生成、应用一键启动,支持高并发和容错。

-

模型服务增强:继续支持预训练和RLHF,支持模型推理时的多推理服务和负载均衡,支持文本到图像和图像文本QA模型,支持语音模型。

-

工具集成:支持Function-Call & Agent,集成常用搜索引擎,支持常用格式化器,提供常见场景的Prompter模板。

-

用户体验优化:优化flow中的数据流动,支持灵活的数据流。

LazyLLM的目标是为AI应用开发提供一条快速、高效、低门槛的道路,释放开发者的创造力,推动AI技术在实际生产中的应用和普及。无论您是初学者还是经验丰富的专家,LazyLLM都希望能为您提供所需的便利。如果您有任何想法或反馈,欢迎随时留言。LazyLLM团队将竭尽全力解决您的问题,确保LazyLLM能为您提供所需的便利。

让我们一起,用LazyLLM开启AI应用开发的新篇章!