LLM课程:从基础到前沿的大语言模型学习之路

大语言模型(LLM)正在revolutionize人工智能领域,成为当前最热门的研究方向之一。为了帮助更多人系统地学习LLM相关知识,GitHub用户mlabonne创建了一个全面的LLM课程,涵盖了从基础到前沿的各个方面。本文将详细介绍这个课程的内容和结构,为有志于深入学习LLM的读者提供一个清晰的学习路线图。

课程概述

该LLM课程分为三个主要部分:

- 🧩 LLM基础: 涵盖数学、Python和神经网络等基础知识。

- 🧑🔬 LLM科学家: 专注于使用最新技术构建最佳LLM。

- 👷 LLM工程师: 专注于创建基于LLM的应用并部署它们。

课程还提供了两个交互式LLM助手,可以回答问题并以个性化的方式测试学习者的知识:

- 🤗 HuggingChat助手: 使用Mixtral-8x7B的免费版本。

- 🤖 ChatGPT助手: 需要高级账户。

LLM基础

这部分介绍了数学、Python和神经网络的基础知识。它包括以下几个主要模块:

-

机器学习数学基础

- 线性代数

- 微积分

- 概率与统计

-

机器学习Python基础

- Python基础语法

- 数据科学库(NumPy, Pandas等)

- 数据预处理

- 机器学习库(Scikit-learn等)

-

神经网络基础

- 神经网络结构

- 训练与优化

- 过拟合问题

- 实现多层感知机(MLP)

-

自然语言处理(NLP)基础

- 文本预处理

- 特征提取技术

- 词嵌入

- 循环神经网络(RNN)

每个模块都提供了丰富的学习资源,包括视频教程、在线课程、博客文章等。

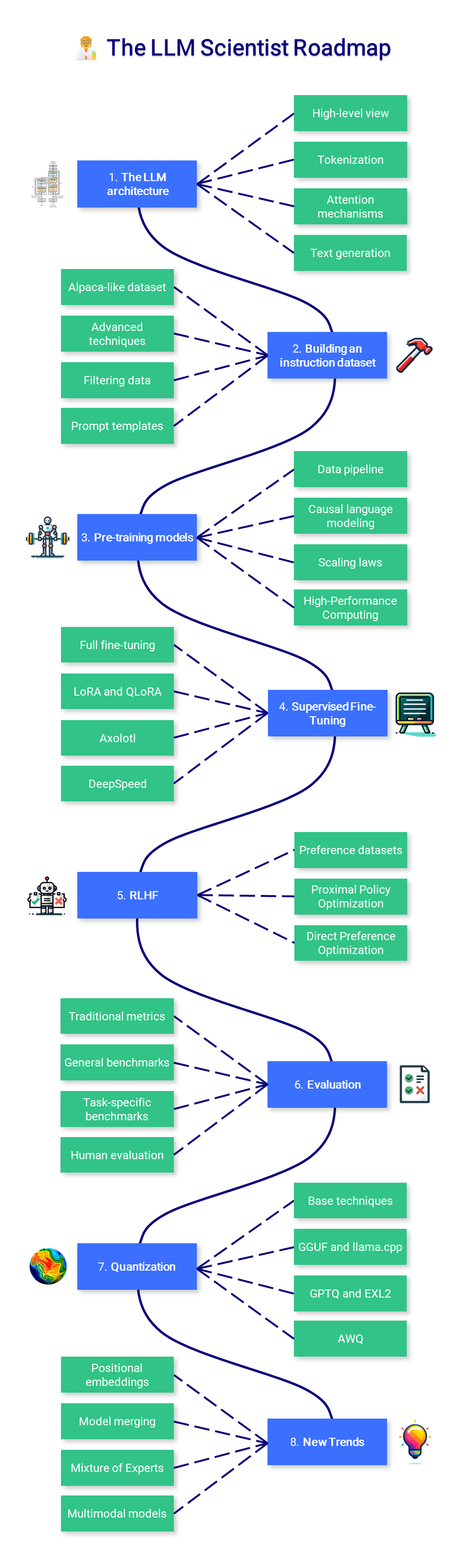

LLM科学家

这部分专注于学习如何使用最新技术构建最佳的LLM。主要内容包括:

-

LLM架构

- Transformer架构回顾

- 分词

- 注意力机制

- 文本生成策略

-

构建指令数据集

- Alpaca式数据集生成

- 高级数据生成技术

- 数据过滤

- 提示模板

-

预训练模型

- 数据管道

- 因果语言建模

- 缩放定律

- 高性能计算

-

监督微调

- 全参数微调

- LoRA

- QLoRA

- Axolotl

- DeepSpeed

-

偏好对齐

- 偏好数据集

- 近端策略优化(PPO)

- 直接偏好优化(DPO)

-

评估

- 传统指标

- 通用基准测试

- 特定任务基准测试

- 人工评估

-

量化

- 基本技术

- GGUF和llama.cpp

- GPTQ和EXL2

- AWQ

-

新趋势

- 位置嵌入

- 模型合并

- 混合专家(MoE)

- 稀疏注意力

每个主题都提供了详细的解释和相关资源,帮助学习者深入理解LLM的核心技术。

LLM工程师

这部分专注于创建基于LLM的应用并部署它们。虽然原文中没有详细介绍这部分内容,但我们可以推测它可能包括以下主题:

- LLM应用开发框架(如LangChain, LlamaIndex等)

- 提示工程

- 检索增强生成(RAG)

- 微调和部署最佳实践

- LLM应用的性能优化

- 安全性和隐私考虑

- 大规模部署和服务

实践资源

课程提供了大量的Jupyter notebooks,涵盖了从工具使用到模型微调、量化等各个方面的实践内容。这些notebooks都可以在Google Colab上运行,方便学习者快速上手实践。

一些值得关注的notebooks包括:

- LLM AutoEval: 使用RunPod自动评估LLM

- LazyMergekit: 一键合并模型

- LazyAxolotl: 一键云端微调模型

- AutoQuant: 一键量化LLM为GGUF, GPTQ, EXL2, AWQ和HQQ格式

- 模型家族树: 可视化合并模型的家族树

- ZeroSpace: 使用免费ZeroGPU自动创建Gradio聊天界面

这些实践资源为学习者提供了宝贵的动手经验,帮助他们将理论知识应用到实际项目中。

总结

这个LLM课程提供了一个全面而系统的学习路径,从基础知识到最新技术,涵盖了LLM领域的方方面面。无论是想要深入理解LLM原理的研究人员,还是希望开发LLM应用的工程师,都能在这个课程中找到有价值的内容。

课程的模块化结构允许学习者根据自己的背景和目标选择合适的学习路径。丰富的学习资源和实践项目也为学习者提供了充分的机会将理论付诸实践。

随着LLM技术的快速发展,这个课程也在不断更新和扩展。对于想要在LLM领域有所建树的学习者来说,这无疑是一个极具价值的学习资源。

参考链接

通过系统学习这个课程,相信读者能够建立起对LLM的全面认识,并为进一步的研究和开发奠定坚实基础。无论你是LLM领域的新手还是有经验的从业者,这个课程都能为你提供新的见解和技能提升的机会。让我们一起踏上这个exciting的LLM学习之旅吧! 🚀🤖