MobileLLM: 为移动设备打造的高效语言模型

在人工智能快速发展的今天,大型语言模型(LLM)已经成为了各种智能应用的基础。然而,这些模型通常规模庞大,需要强大的计算资源支持,难以在资源受限的移动设备上运行。为了解决这一问题,Meta AI的研究人员最近推出了MobileLLM,这是一种专门为智能手机等移动设备优化的小型语言模型。

创新设计:小而精的语言模型

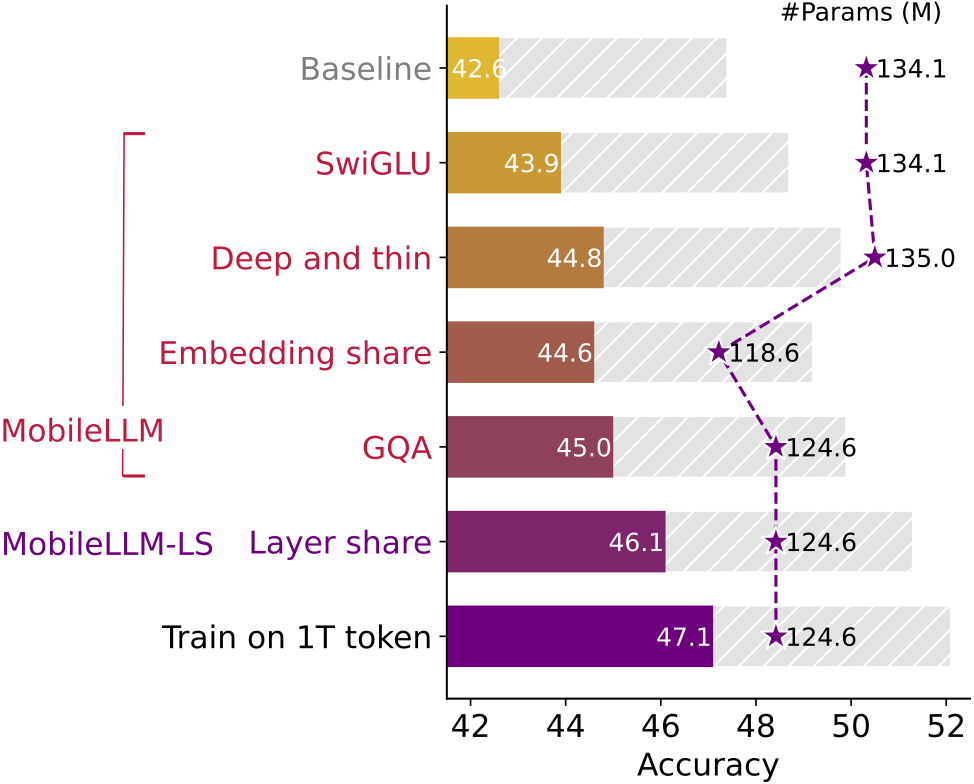

MobileLLM的核心理念是"小而精"。研究团队综合考虑了多项设计因素,以在较小的参数规模下实现高质量的语言模型:

- 采用SwiGLU激活函数

- 设计深而窄的网络架构

- 实现嵌入共享

- 使用分组查询注意力机制

- 创新性地应用即时块级权重共享技术

通过这些创新设计,MobileLLM在保持较小规模的同时,性能得到了显著提升。以125M和350M参数的版本为例,在零样本常识推理任务中,MobileLLM分别比同等规模的现有最佳模型提高了2.7%和4.3%的准确率。这虽然看似是小幅提升,但在竞争激烈的语言模型领域,已经是相当可观的进步。

扩展性:从小到大的优势

MobileLLM的设计理念不仅适用于小规模模型,研究人员还证明了这一方法可以有效扩展到更大的模型上。在更新的版本中,他们展示了MobileLLM-600M、1B和1.5B等更大规模模型的出色表现,这些模型在多项任务上都达到了同等规模模型中的最佳水平。

特别值得一提的是,350M参数的MobileLLM在某些API调用任务上,展现出了与70亿参数的LLaMA-2模型相当的准确性。这一发现意味着,对于某些特定应用场景,精心设计的小型模型可能会提供与大型模型相似的功能,同时大幅降低计算资源需求。

训练效率:追求高性价比

MobileLLM的训练过程也体现了效率至上的理念。研究团队提供了详细的训练成本数据:

| 模型规模 | 125M | 350M | 600M | 1B | 1.5B |

|---|---|---|---|---|---|

| 训练时间 | ~3天 | ~6天 | ~8天 | ~12天 | ~18天 |

这些数据基于使用32个NVIDIA A100 80G GPU对1万亿个token进行训练得出。相比传统的大型语言模型,MobileLLM的训练成本大幅降低,这使得更多研究者和开发者能够参与到语言模型的优化和应用中来。

应用前景:移动AI的新可能

MobileLLM的出现为移动设备上的AI应用开辟了新的可能性。它有潜力支持以下场景:

- 智能手机上的本地语音助手,提供更快速、更私密的服务

- 移动应用内的智能文本处理和生成功能

- 智能可穿戴设备中的轻量级AI功能

- 物联网设备的智能化升级

- 边缘计算场景中的自然语言处理任务

这些应用不仅可以提升用户体验,还能在保护隐私和降低云端依赖方面发挥重要作用。

开源贡献:推动领域发展

为了推动小型语言模型领域的发展,Meta AI团队开源了MobileLLM的预训练代码。这使得其他研究者可以基于他们的工作进行进一步的探索和改进。虽然模型权重目前仍在法律审核中,但开源代码已经为整个AI社区提供了宝贵的资源。

未来展望:小型模型的广阔前景

MobileLLM的成功开发表明,在追求更大、更强大模型的同时,优化小型模型同样具有巨大价值。这种方向可能会带来以下影响:

- 促进移动AI应用的普及,使更多用户受益于AI技术

- 推动边缘计算和物联网领域的智能化发展

- 降低AI应用的能耗和碳排放,助力可持续发展

- 为隐私保护和去中心化AI提供新的技术支持

随着研究的深入和技术的进步,我们可以期待看到更多高效、小巧而功能强大的AI模型问世,为移动计算时代注入新的活力。

MobileLLM的出现,不仅是技术上的一次突破,更代表了AI研究方向的一次重要转变。它提醒我们,在追求更大规模的同时,也要关注如何让AI变得更加高效、更易于普及。这种平衡思维,将为人工智能的未来发展指明方向,让AI真正走进每个人的日常生活。