基于模型的强化学习:前沿进展与最新动态

在人工智能和机器学习领域,强化学习一直是备受关注的研究热点。而基于模型的强化学习(Model-based Reinforcement Learning, MBRL)作为强化学习的一个重要分支,近年来取得了长足的进步。本文将深入探讨MBRL的最新研究进展,为读者全面呈现这一领域的前沿动态。

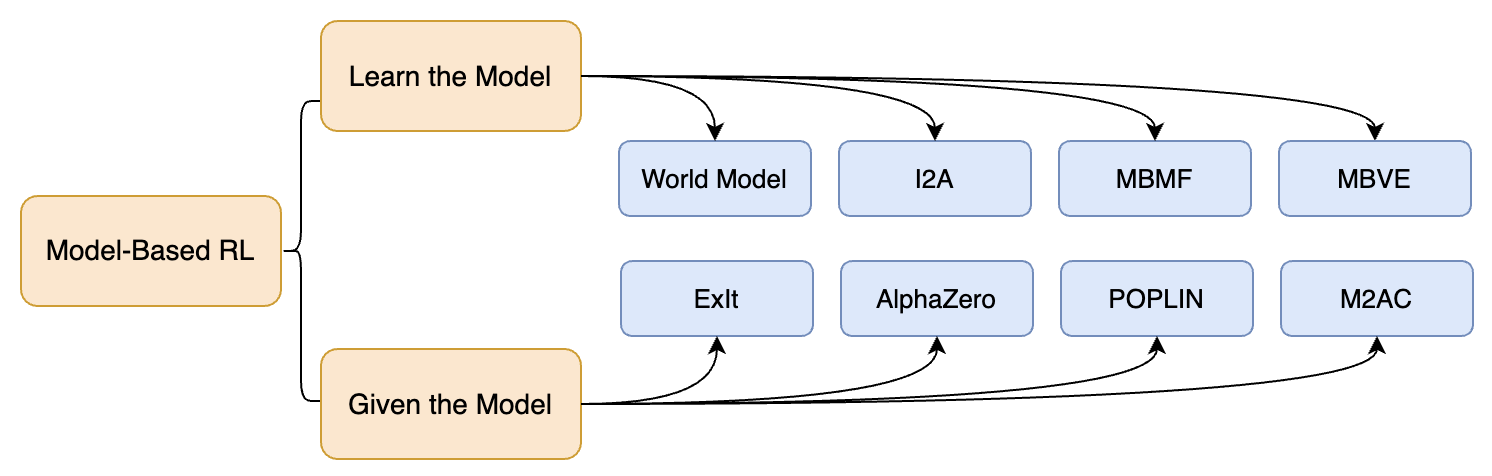

MBRL的基本概念与分类

基于模型的强化学习是指在强化学习过程中,通过学习或利用环境模型来辅助决策的方法。与model-free方法相比,MBRL通常能够更有效地利用数据,在样本效率上具有优势。根据对模型的使用方式,MBRL可以大致分为两类:

- 学习模型(Learn the Model):主要关注如何构建准确的环境模型。

- 给定模型(Given the Model):侧重于如何利用已有的模型来优化决策。

MBRL的一种分类方法

这种分类方法虽然简单,但能够帮助我们更好地理解MBRL的研究方向。在"学习模型"方面,研究者们致力于开发更精确、更泛化的环境模型;而在"给定模型"方面,如何高效地利用模型来指导策略学习和决策是关键问题。

经典算法回顾

在深入探讨最新进展之前,我们有必要回顾一下MBRL领域的一些经典算法,这些算法为后续研究奠定了重要基础。

-

Dyna架构 (Richard S. Sutton, 1991) Dyna是最早将模型学习与策略学习相结合的架构之一。它通过在真实环境与模拟环境中交替学习,有效提高了样本利用效率。

-

PILCO (Marc Peter Deisenroth & Carl Edward Rasmussen, 2011) PILCO(Probabilistic Inference for Learning Control)引入了概率动力学模型,能够有效处理模型不确定性,在低维连续控制任务中表现出色。

-

Guided Policy Search (Sergey Levine & Vladlen Koltun, 2014) 该方法巧妙地将轨迹优化与策略学习结合,能够学习复杂的神经网络策略。

-

World Models (David Ha & Jürgen Schmidhuber, 2018) World Models提出了一种基于VAE和RNN的世界模型架构,能够在潜空间中进行想象和规划。

-

PETS (Kurtland Chua et al., 2018) PETS(Probabilistic Ensembles with Trajectory Sampling)利用概率集成模型和轨迹采样,在样本效率和性能上都取得了不错的效果。

这些经典算法为MBRL的发展指明了方向,也启发了许多后续的研究工作。

最新研究热点

近年来,MBRL领域涌现出许多创新性的研究,我们将从几个主要方向来探讨这些最新进展。

1. 世界模型的改进

世界模型(World Model)是MBRL中的核心组件,其性能直接影响整个算法的效果。最新研究在以下几个方面对世界模型进行了改进:

-

结构创新: 研究者们尝试了各种新的模型结构。例如,ICML 2024的论文《Facing Off World Model Backbones: RNNs, Transformers, and S4》比较了RNN、Transformer和S4(结构化状态空间序列)模型在世界模型中的表现。

-

上下文建模: 《Pre-training Contextualized World Models with In-the-wild Videos for Reinforcement Learning》提出了一种上下文化世界模型,通过预训练来提高模型的泛化能力。

-

分层建模: ICLR 2024的论文《Learning Hierarchical World Models with Adaptive Temporal Abstractions from Discrete Latent Dynamics》提出了一种基于离散潜在动力学的自适应时间抽象分层世界模型。

2. 规划与决策方法

有了准确的世界模型,如何有效地利用它来进行规划和决策是MBRL的另一个重要问题。

-

模型预测控制(MPC): TD-MPC2(《TD-MPC2: Scalable, Robust World Models for Continuous Control》)提出了一种隐式世界模型和模型预测控制相结合的方法,在连续控制任务中表现出色。

-

蒙特卡洛树搜索(MCTS): 《LightZero: A Unified Benchmark for Monte Carlo Tree Search in General Sequential Decision Scenarios》提供了一个统一的MCTS基准,有助于研究者们更好地评估和比较MCTS类算法。

-

轨迹优化: 《Differentiable Trajectory Optimization as a Policy Class for Reinforcement and Imitation Learning》将可微轨迹优化作为一种策略类,在强化学习和模仿学习中都取得了不错的效果。

3. 与大语言模型的结合

随着大语言模型(LLM)的兴起,研究者们也开始探索将LLM与MBRL结合的可能性。

-

交互式规划: 《Describe, Explain, Plan and Select: Interactive Planning with LLMs Enables Open-World Multi-Task Agents》提出了一种基于LLM的交互式规划方法,使智能体能够在开放世界中完成多任务。

-

世界模型构建: 《Leveraging Pre-trained Large Language Models to Construct and Utilize World Models for Model-based Task Planning》探讨了如何利用预训练的LLM来构建和使用世界模型,用于基于模型的任务规划。

4. 鲁棒性与泛化

如何提高MBRL算法的鲁棒性和泛化能力也是近期研究的热点之一。

-

视角泛化: 《MoVie: Visual Model-Based Policy Adaptation for View Generalization》提出了一种视觉模型基础的策略适应方法,用于处理视角泛化问题。

-

表征鲁棒性: 《RePo: Resilient Model-Based Reinforcement Learning by Regularizing Posterior Predictability》通过正则化后验可预测性来提高视觉RL的表征鲁棒性。

-

对抗鲁棒性: ICML 2024的论文《Towards Robust Model-Based Reinforcement Learning Against Adversarial Corruption》对MBRL在对抗性干扰下的鲁棒性进行了理论分析。

未来展望

基于模型的强化学习虽然取得了显著进展,但仍面临诸多挑战和机遇:

-

大规模复杂环境: 如何在更加复杂和高维的环境中构建准确的世界模型仍是一个开放问题。

-

样本效率与泛化性的平衡: 进一步提高算法的样本效率,同时保持良好的泛化性能是未来研究的重要方向。

-

与其他AI技术的融合: 除了大语言模型,MBRL还可能与计算机视觉、自然语言处理等领域的技术进行更深入的结合。

-

理论基础: 加强MBRL的理论研究,为算法设计和性能分析提供更坚实的基础。

-

实际应用: 将MBRL技术应用于更多实际场景,如自动驾驶、机器人控制、智能制造等领域。

结语

基于模型的强化学习作为一个充满活力的研究领域,正在以惊人的速度发展。从经典算法到最新进展,MBRL不断突破自身限制,向着更高效、更智能的方向迈进。未来,随着新技术的不断涌现和跨领域合作的深入,我们有理由相信MBRL将在人工智能领域发挥更加重要的作用,为解决复杂的实际问题提供强大支持。

参考资源

希望本文能为读者提供一个全面的MBRL研究进展概览,激发更多人参与到这一激动人心的领域中来。让我们共同期待MBRL的美好未来。