MonocularRGB_3D_Handpose_WACV18:突破性的单目RGB相机3D手部姿态估计技术

在计算机视觉和人机交互领域,手部姿态估计一直是一个具有挑战性的研究课题。近年来,随着深度相机(如Kinect)的出现,基于RGBD数据的手部姿态估计取得了显著进展。然而,对于仅使用普通RGB相机的单目手部姿态估计,进展却相对缓慢。MonocularRGB_3D_Handpose_WACV18项目正是为了解决这一难题而生,它提供了一种创新的方法,能够仅使用单个RGB相机就实现实时、准确的3D手部姿态估计。

项目概述

MonocularRGB_3D_Handpose_WACV18是由希腊FORTH研究所的计算机视觉与机器人实验室(CVRL)开发的开源项目。该项目的核心思想是结合最新的深度学习技术与传统的生成式手部姿态估计方法,实现在不受限场景下的实时单目3D手部姿态估计。

项目的主要贡献包括:

- 提出了一种新的pipeline,能够从单张RGB图像中估计出完整的3D手部姿态。

- 结合了深度学习和基于模型的方法,充分发挥两者的优势。

- 实现了实时性能,可以在普通硬件上运行。

- 在各种复杂的真实场景中展示了良好的鲁棒性。

技术原理

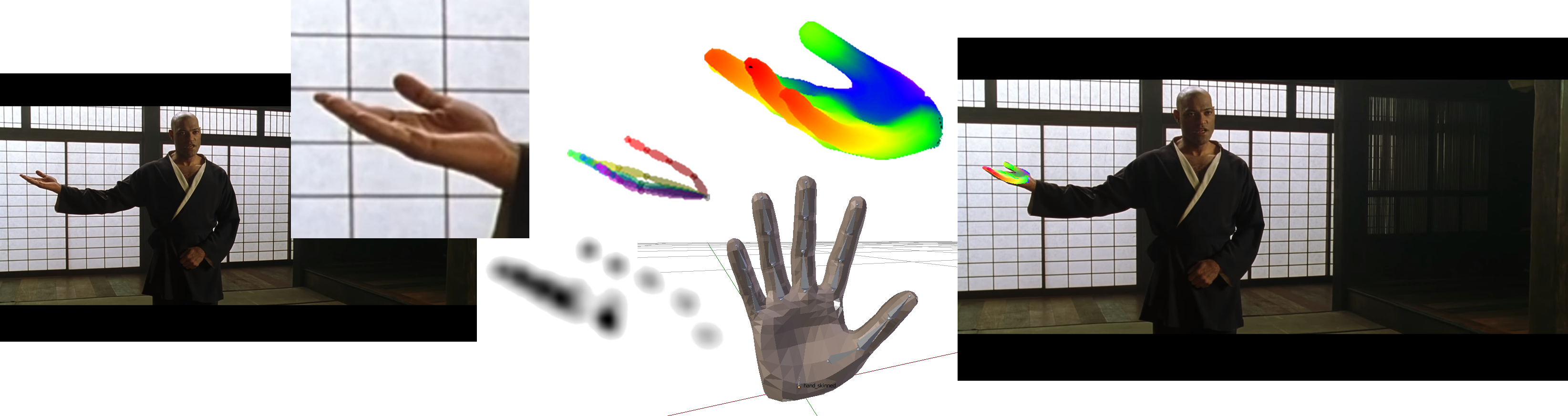

MonocularRGB_3D_Handpose_WACV18的工作原理可以概括为以下几个步骤:

- 手部检测: 使用先进的目标检测器(如YOLO)来定位图像中的手部区域。

- 2D关键点估计: 采用预训练的深度神经网络(如Gouidis等人或Simon等人的方法)来估计手部关键点的2D位置。

- 3D姿态拟合: 使用非线性最小二乘优化方法,将3D手部模型拟合到估计的2D关键点位置,从而恢复出3D手部姿态。

这种方法巧妙地结合了深度学习的特征提取能力和基于模型的方法的先验知识,使得系统能够在各种复杂环境下稳定工作。

项目特点

- 单目RGB输入: 只需要一个普通的RGB相机,无需特殊的深度传感器。

- 实时性能: 通过优化算法和模型,实现了实时的3D手部姿态估计。

- 多手支持: 能够同时估计多只手的3D姿态。

- 开源可用: 项目代码开源,提供了详细的使用说明和示例。

- 灵活性: 支持使用不同的2D关键点估计方法,如Gouidis等人的方法或OpenPose。

应用场景

MonocularRGB_3D_Handpose_WACV18的技术可以应用于多个领域:

- 人机交互: 为虚拟现实(VR)和增强现实(AR)应用提供自然的手势交互界面。

- 手语识别: 帮助开发更准确的手语翻译系统。

- 机器人控制: 实现更直观的机器人遥操作。

- 医疗康复: 辅助医生进行手部运动评估和康复训练。

- 动作捕捉: 为动画和电影制作提供低成本的手部动作捕捉解决方案。

项目使用

要使用MonocularRGB_3D_Handpose_WACV18,需要按照以下步骤进行:

- 克隆项目仓库:

git clone https://github.com/FORTH-ModelBasedTracker/MonocularRGB_3D_Handpose_WACV18.git - 安装依赖:

pip3 install numpy opencv-python tensorflow-gpu - 下载预编译的库文件并配置环境变量。

- 运行示例脚本:

python3 handpose.py

项目还提供了Docker支持,使得在不同环境中部署变得更加容易。

未来展望

尽管MonocularRGB_3D_Handpose_WACV18已经展示了令人印象深刻的性能,但3D手部姿态估计领域仍有很大的发展空间:

- 精度提升: 通过改进神经网络架构和训练数据,进一步提高2D关键点估计的精度。

- 实时性能优化: 探索更高效的算法和硬件加速技术,以降低系统延迟。

- 鲁棒性增强: 提高系统在各种光照条件、遮挡情况下的表现。

- 与其他传感器融合: 结合IMU或深度传感器数据,进一步提升估计精度。

- 应用扩展: 开发更多基于精确3D手部姿态的应用,如精细手势识别和触觉反馈系统。

MonocularRGB_3D_Handpose_WACV18项目为单目RGB相机3D手部姿态估计领域带来了重要突破。它不仅推动了学术研究的进展,也为众多实际应用提供了可能性。随着技术的不断发展和完善,我们有理由相信,基于单目RGB相机的3D手部姿态估计将在未来发挥越来越重要的作用,为人机交互带来革命性的变革。

总的来说,MonocularRGB_3D_Handpose_WACV18项目展示了计算机视觉和深度学习技术的强大潜力。它不仅解决了一个具有挑战性的技术问题,还为众多实际应用铺平了道路。随着更多研究者和开发者的加入,我们期待看到这项技术在各个领域绽放光彩,为人类的日常生活和工作带来更多便利和可能性。