mPLUG-Owl: 开启多模态大语言模型的新纪元

在人工智能快速发展的今天,多模态大语言模型(MLLM)正成为研究的热点。其中,由阿里巴巴达摩院X-PLUG团队开发的mPLUG-Owl系列模型以其卓越的性能和创新的架构设计,正引领着这一领域的发展。本文将深入介绍mPLUG-Owl系列模型的特点、发展历程以及其在多模态理解与生成任务中的应用。

mPLUG-Owl系列简介

mPLUG-Owl是一个强大的多模态大语言模型家族,旨在通过模块化学习方法赋予大语言模型多模态能力。该系列目前包括三个主要版本:

- mPLUG-Owl: 首个版本,通过模块化方法实现了大语言模型的多模态能力。

- mPLUG-Owl2: 第二代模型,革新了多模态大语言模型的模态协作方式。

- mPLUG-Owl3: 最新版本,致力于在多模态大语言模型中实现长图像序列理解。

这三个版本各有特色,共同构成了一个不断进化的多模态AI生态系统。

核心技术与创新

mPLUG-Owl系列的核心创新在于其独特的模块化学习方法。这种方法包括以下几个关键组件:

- 基础大语言模型: 作为核心语言理解和生成引擎。

- 视觉知识模块: 负责处理和理解视觉信息。

- 视觉抽象器模块: 将视觉信息转化为语言模型可理解的形式。

通过这种模块化设计,mPLUG-Owl能够有效地整合文本和视觉信息,实现真正的多模态理解和生成。

模型演进与突破

mPLUG-Owl系列的每一次更新都带来了显著的性能提升和新的功能:

- mPLUG-Owl: 首次实现了大语言模型的多模态能力,为后续发展奠定基础。

- mPLUG-Owl2: 在模态协作方面取得突破,大幅提升了模型在复杂多模态任务中的表现。该版本已被CVPR 2024接收为Highlight论文,充分证明了其在学术界的影响力。

- mPLUG-Owl3: 最新发布的版本,专注于解决长图像序列理解的挑战,为文档理解等应用场景带来新的可能。

应用场景与潜力

mPLUG-Owl系列模型在多个领域展现出巨大潜力:

- 智能对话: 能够理解并讨论图像内容,实现更自然的人机交互。

- 视觉问答: 准确回答关于图像的复杂问题,支持教育和信息检索等应用。

- 多模态内容生成: 根据文本和图像输入生成创意内容,如广告文案、故事创作等。

- 文档理解: 特别是mPLUG-Owl3,在处理长图像序列方面的优势使其在文档分析和理解任务中表现出色。

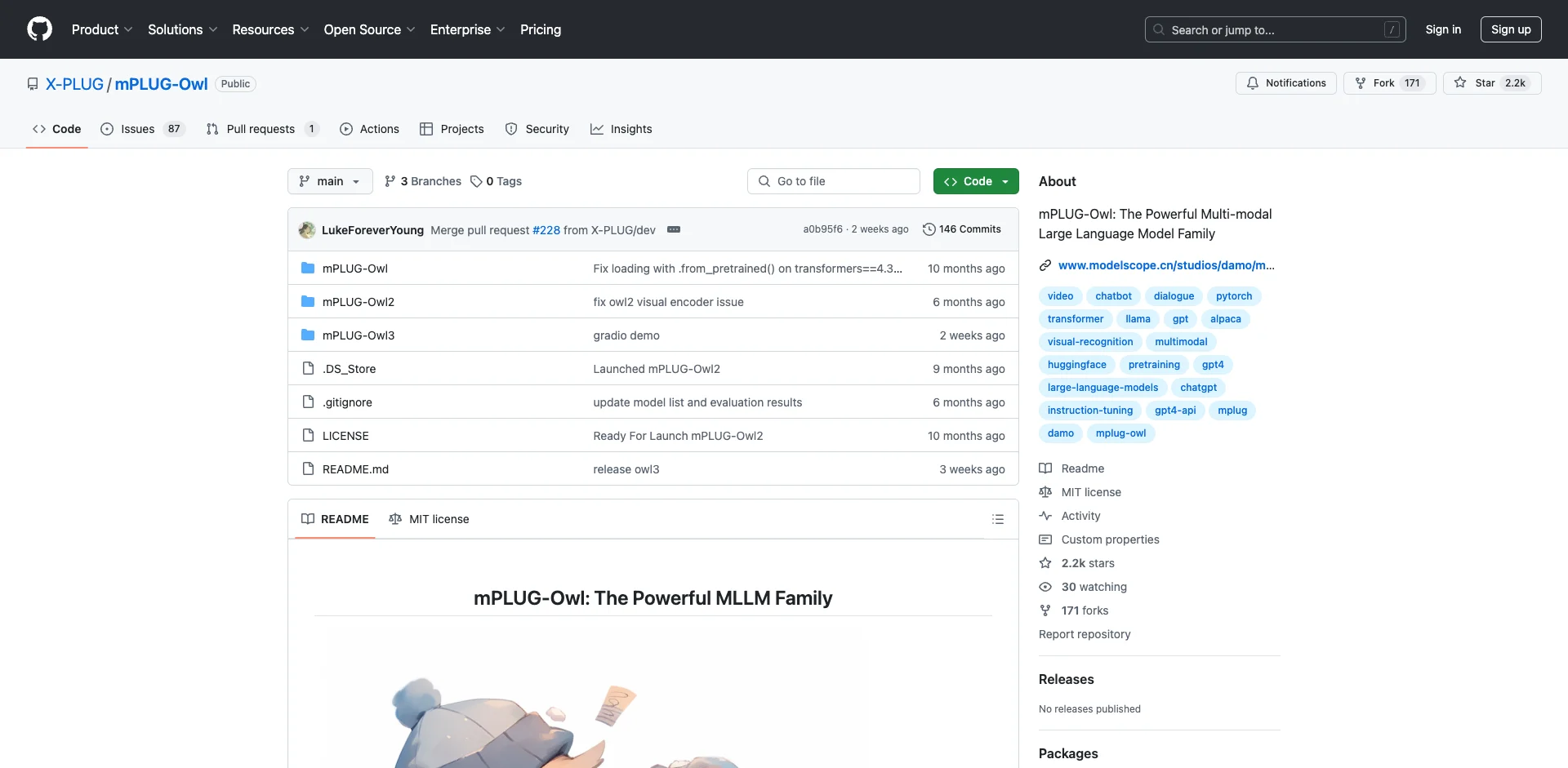

开源与社区贡献

mPLUG-Owl项目在GitHub上开源,获得了广泛关注。截至目前,该项目已获得超过2.2k的星标,反映了其在AI社区中的影响力。研究者和开发者可以通过以下方式参与和使用mPLUG-Owl:

- 访问官方GitHub仓库获取最新代码和文档。

- 在HuggingFace上获取预训练模型权重。

- 参与在线演示,体验模型能力。

未来展望

随着AI技术的不断发展,mPLUG-Owl系列模型也在持续进化。未来,我们可以期待:

- 更强大的多模态理解能力,支持更复杂的应用场景。

- 更高效的模型架构,降低计算资源需求。

- 更广泛的模态支持,如音频、视频等。

- 更深入的跨模态知识整合,实现真正的智能理解。

结语

mPLUG-Owl系列模型代表了多模态AI领域的最新进展,其创新的模块化方法为大语言模型赋予了强大的多模态能力。随着技术的不断进步和应用场景的拓展,我们有理由相信,mPLUG-Owl将继续引领多模态AI的发展,为人工智能的未来开辟新的可能性。

无论你是研究人员、开发者还是对AI技术感兴趣的爱好者,mPLUG-Owl都值得你深入了解和关注。让我们共同期待mPLUG-Owl带来的更多惊喜和突破!