nncase:赋能边缘人工智能的关键工具

在当今人工智能快速发展的时代,如何在资源受限的边缘设备上高效运行复杂的神经网络模型,成为了一个重要的技术挑战。为了解决这一问题,Kendryte公司开发了nncase - 一款专为AI加速器设计的神经网络编译器。nncase凭借其强大的功能和优秀的性能,正在成为边缘AI开发的重要工具。

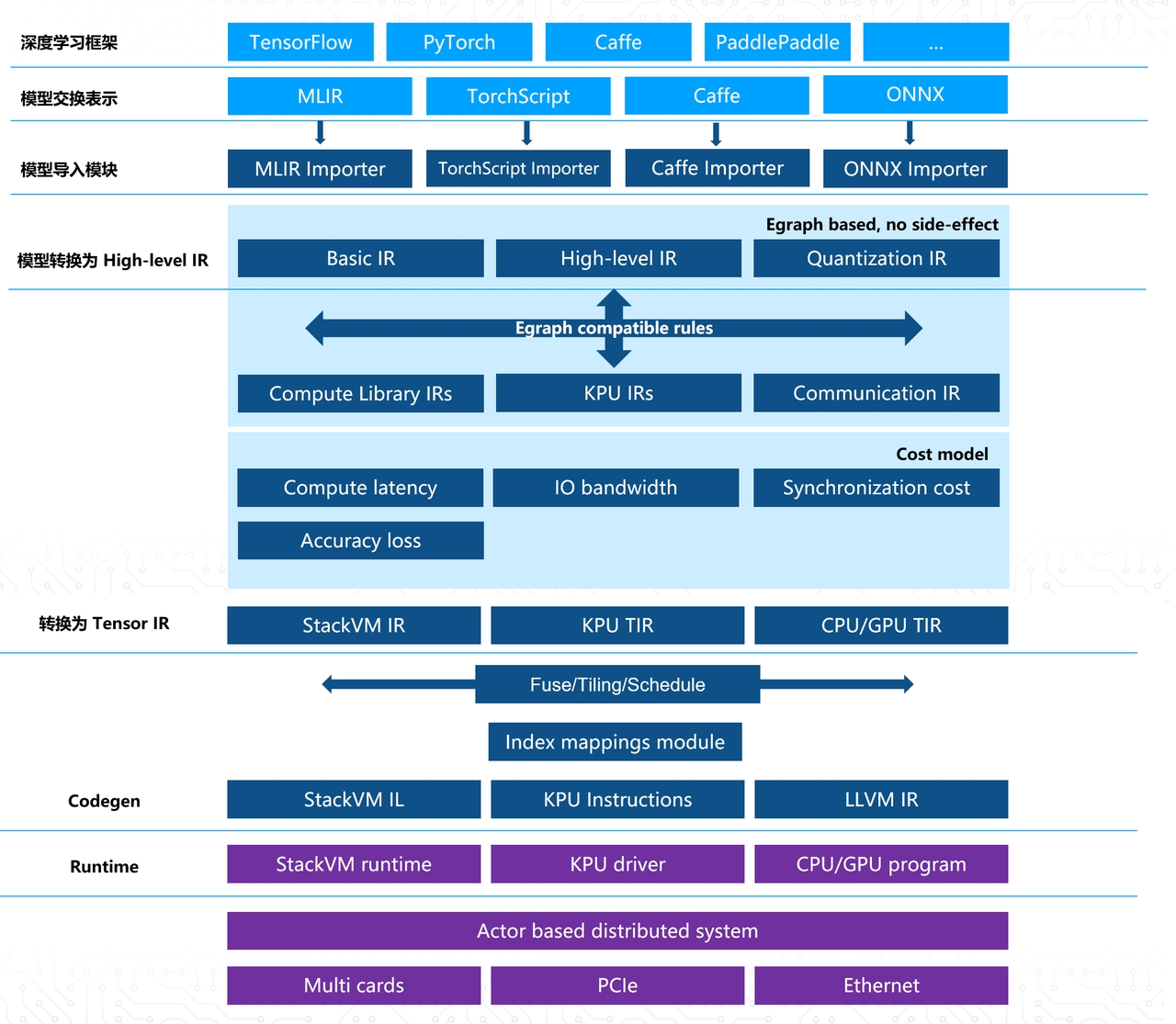

nncase的核心功能与特点

nncase的设计理念是"轻量高效"。它支持多输入多输出的复杂网络结构,采用静态内存分配策略避免运行时内存申请,并实现了算子融合等多项优化技术。nncase支持浮点和量化uint8推理,还提供了基于校准数据集的后量化功能。此外,它还采用了零拷贝加载的平坦模型格式,进一步提升了运行效率。

nncase支持多种主流深度学习框架,包括TensorFlow Lite、Caffe和ONNX。开发者可以方便地将这些框架训练的模型导入nncase进行编译优化。在支持的算子方面,nncase覆盖了绝大多数常用的卷积神经网络算子,如卷积、池化、激活函数等。

nncase的应用场景

nncase主要面向Kendryte系列AI芯片,包括K210、K510和最新的K230。这些芯片广泛应用于智能家居、工业物联网、智慧城市等边缘AI场景。借助nncase,开发者可以将复杂的深度学习模型高效地部署到这些资源受限的边缘设备上。

以K230为例,nncase为其提供了强大的AI开发支持:

- 完整的开发工具链:包括模型转换、量化、编译等功能,支持Python API调用。

- 丰富的示例代码:涵盖了图像分类、目标检测、语义分割等多个领域的经典模型。

- 详细的开发文档:提供了全面的使用教程和API参考。

通过这些工具,开发者可以快速地将TensorFlow、PyTorch等框架训练的模型部署到K230芯片上。

nncase的性能表现

nncase在各类视觉AI任务上都展现出了优秀的性能。以下是一些典型模型在K230上运行的benchmark数据:

- 图像分类:mobilenetv2在224x224输入下可达600FPS,top-1精度71.1%。

- 目标检测:yolov5s在640x640输入下可达23FPS,mAP@0.5为0.566。

- 语义分割:yolov8s-seg在640x640输入下可达7.8FPS,分割mAP@0.5为0.578。

- 姿态估计:yolov8s-pose在640x640输入下可达5.6FPS,关键点mAP@0.5为0.857。

这些数据充分展示了nncase在模型优化和量化方面的卓越能力,使得复杂的AI算法可以在边缘设备上流畅运行。

nncase的开发与使用

nncase采用开源开发模式,其源代码托管在GitHub上。开发者可以通过pip直接安装nncase及其K230专用扩展nncase-kpu。对于高级用户,nncase也支持从源码编译,以满足定制化需求。

使用nncase的一般流程如下:

- 准备模型:将训练好的模型转换为nncase支持的格式(如ONNX)。

- 模型编译:使用nncase compiler将模型编译为kmodel格式。

- 量化优化:根据实际需求进行定点化等优化。

- 部署运行:将优化后的模型部署到目标硬件上运行。

nncase提供了详细的使用文档和丰富的示例代码,大大降低了开发者的学习成本。

nncase的生态系统

围绕nncase,Kendryte构建了一个丰富的生态系统:

- 官方资源:包括详细的API文档、使用教程、示例代码等。

- 开发者社区:通过Telegram群组和QQ群进行技术交流。

- 模型库:提供了大量预训练模型,覆盖工业、安防、教育等多个领域。

- 在线训练平台:支持K210/K230的模型在线训练。

- 视频教程:B站上有大量nncase相关的教学视频。

这些资源极大地方便了开发者使用nncase进行边缘AI应用开发。

未来展望

随着边缘AI的快速发展,nncase也在不断进化。未来,我们可以期待nncase在以下方面有所突破:

- 支持更多AI框架和模型结构。

- 进一步提升量化精度和推理性能。

- 增强对大语言模型等新兴AI技术的支持。

- 提供更智能的自动优化功能。

总的来说,nncase作为一款专注于边缘AI的神经网络编译器,正在为推动边缘智能的发展发挥重要作用。随着技术的不断进步和生态的日益完善,nncase必将助力更多创新的边缘AI应用落地,为智能物联网时代的到来贡献力量。