PyTorch内存管理利器:pytorch_memlab深度解析

在深度学习领域,PyTorch已经成为最流行的框架之一。然而,随着模型规模的不断扩大,内存管理问题也变得日益突出。为了帮助开发者更好地管理和优化PyTorch模型的内存使用,pytorch_memlab应运而生。本文将深入探讨这个强大工具的功能和使用方法,帮助读者掌握PyTorch内存管理的精髓。

pytorch_memlab简介

pytorch_memlab是一个简单而精确的CUDA内存管理实验室,专门为PyTorch设计。它提供了一系列工具,帮助开发者分析、监控和优化PyTorch模型的内存使用情况。主要功能包括内存分析器、内存报告器和礼貌模式等。

主要特性

- 内存分析器:提供类似Python

line_profiler风格的CUDA内存分析器,具有简单的API。 - 内存报告器:用于检查占用CUDA内存的张量。

- 礼貌模式:一个有趣的功能,可以临时将所有CUDA张量移动到CPU内存中,以释放GPU资源。

- IPython支持:通过

%mlrun/%%mlrun行/单元魔法命令提供IPython支持。

安装方法

pytorch_memlab的安装非常简单,可以通过pip直接安装:

pip install pytorch_memlab

如果你想安装最新版本,可以直接从GitHub仓库安装:

pip install git+https://github.com/stonesjtu/pytorch_memlab

内存分析器

内存分析器是pytorch_memlab的核心功能之一,它可以帮助开发者精确定位内存使用的问题所在。让我们来看一个简单的例子:

import torch

from pytorch_memlab import LineProfiler

def inner():

torch.nn.Linear(100, 100).cuda()

def outer():

linear = torch.nn.Linear(100, 100).cuda()

linear2 = torch.nn.Linear(100, 100).cuda()

linear3 = torch.nn.Linear(100, 100).cuda()

work()

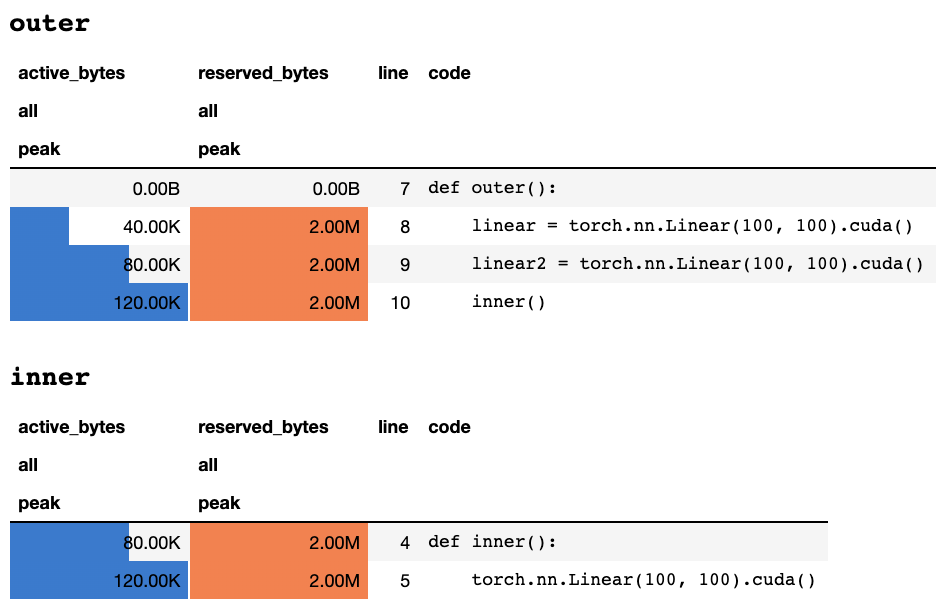

运行这段代码后,内存分析器会生成详细的内存使用报告:

这个报告清晰地展示了每行代码的内存使用情况,包括活跃字节数和保留字节数。这对于定位内存泄漏和优化内存使用非常有帮助。

内存报告器

内存报告器提供了更低级别的内存使用信息。它会遍历所有的Tensor对象,并获取底层的UntypedStorage对象,以获得实际的内存使用情况。这比仅仅查看Tensor.size更加准确。

让我们看一个使用内存报告器的例子:

import torch

from pytorch_memlab import MemReporter

linear = torch.nn.Linear(1024, 1024).cuda()

inp = torch.Tensor(512, 1024).cuda()

reporter = MemReporter(linear)

out = linear(inp).mean()

print('========= before backward =========')

reporter.report()

out.backward()

print('========= after backward =========')

reporter.report()

这段代码会生成详细的内存报告,包括每个张量的大小和内存使用情况。这对于理解模型的内存分布非常有帮助。

礼貌模式

礼貌模式是pytorch_memlab的一个独特功能。它允许你临时将所有CUDA张量移动到CPU内存中,以释放GPU资源。这在多人共享GPU资源的环境中特别有用。

from pytorch_memlab import Courtesy

iamcourtesy = Courtesy()

for i in range(num_iteration):

if something_happens:

iamcourtesy.yield_memory()

wait_for_restart_signal()

iamcourtesy.restore()

通过这种方式,你可以在不完全停止任务的情况下,临时释放GPU资源给其他用户使用。

IPython支持

pytorch_memlab还提供了IPython支持,这使得在Jupyter notebooks中使用这些工具变得更加方便。你可以使用%mlrun和%%mlrun魔法命令来分析单行或整个单元格的内存使用情况。

%%mlrun -f func

import torch

from pytorch_memlab import profile, set_target_gpu

def func():

net1 = torch.nn.Linear(1024, 1024).cuda(0)

set_target_gpu(1)

net2 = torch.nn.Linear(1024, 1024).cuda(1)

set_target_gpu(0)

net3 = torch.nn.Linear(1024, 1024).cuda(0)

这种方式使得内存分析变得更加灵活和交互式。

结语

pytorch_memlab为PyTorch开发者提供了强大的内存管理工具。通过使用内存分析器和报告器,开发者可以精确定位内存问题,优化模型性能。礼貌模式则为资源共享提供了优雅的解决方案。随着深度学习模型日益复杂,掌握这些工具将成为每个PyTorch开发者的必备技能。

📊 在实际项目中,合理使用pytorch_memlab可以帮助你:

- 识别并解决内存泄漏问题

- 优化模型结构,减少不必要的内存使用

- 在共享GPU环境中更好地管理资源

🔍 深入学习pytorch_memlab,探索更多高级功能,将让你在PyTorch开发中如虎添翼。记住,良好的内存管理不仅可以提高模型性能,还能让你的开发过程更加顺畅。

让我们一起拥抱这个强大的工具,开启PyTorch内存管理的新篇章吧!