rl-plotter:简化强化学习实验结果可视化

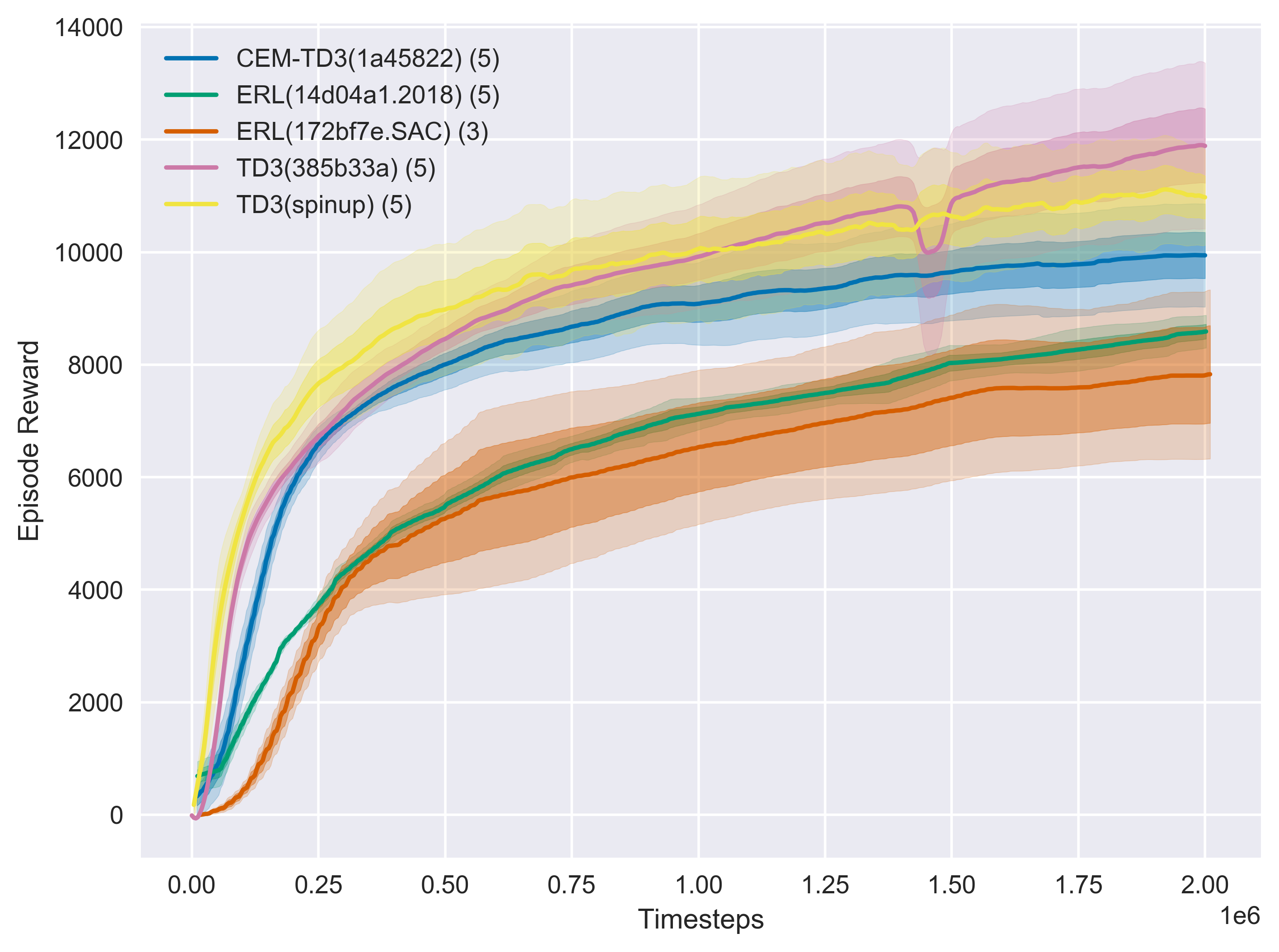

在强化学习(Reinforcement Learning, RL)领域,研究人员和工程师经常需要绘制各种学习曲线来分析和比较算法的性能。然而,传统的绘图方法往往繁琐耗时,难以满足快速迭代的需求。为解决这一问题,GitHub用户gxywy开发了一款名为rl-plotter的工具,旨在简化RL实验结果的可视化过程。

rl-plotter的主要特性

rl-plotter具有以下几个突出特点:

-

简单易用:只需几行代码即可集成到现有的RL项目中。

-

功能强大:支持多种绘图样式和自定义选项,可满足各种可视化需求。

-

兼容性好:与OpenAI Baselines和Spinning Up等主流RL框架兼容。

-

灵活性高:支持多实验对比、多指标绘制等高级功能。

快速上手

要使用rl-plotter,首先需要通过pip安装:

pip install rl_plotter

然后在代码中导入并初始化logger:

from rl_plotter.logger import Logger

logger = Logger(exp_name="your_exp_name", env_name, seed, locals())

在训练过程中记录数据:

logger.update(score=evaluation_score_list, total_steps=current_training_steps)

最后使用命令行工具绘制结果:

rl_plotter --save --show

高级用法

rl-plotter还支持许多高级功能,如:

- 多实验对比:

rl_plotter --save --show --filter HalfCheetah

- 自定义绘图样式:

rl_plotter --show --save --avg_group --shaded_err --shaded_std

- 多指标绘制:

rl_plotter --show --save --ykey bias real_q --yduel

通过这些功能,研究人员可以更灵活地分析和展示实验结果。

社区反馈

rl-plotter在GitHub上获得了超过200颗星,得到了社区的广泛认可。一位用户评论道:"这正是我一直在寻找的工具,它大大简化了我的工作流程。"另一位用户表示:"rl-plotter的兼容性很好,可以无缝集成到我们现有的项目中。"

未来展望

rl-plotter的开发者表示,他们计划在未来版本中添加更多功能,如:

- 支持更多数据格式

- 提供交互式绘图界面

- 集成更多统计分析工具

这些改进将进一步增强rl-plotter的功能,使其成为RL研究中更加强大的工具。

结语

rl-plotter为强化学习研究人员和工程师提供了一个简单而强大的可视化工具。通过简化实验结果的绘制过程,它使研究人员能够将更多精力集中在算法开发和性能优化上。无论是初学者还是专家,rl-plotter都是一个值得尝试的工具,有望成为强化学习项目中不可或缺的组成部分。

如果您对rl-plotter感兴趣,可以访问其GitHub仓库了解更多信息,或者查阅官方文档获取详细的使用说明。让我们一起期待rl-plotter在未来带来更多惊喜,为强化学习研究注入新的活力! 🚀🔬📊