RunPod Worker Comfy:AI图像生成的革命性解决方案

在人工智能和云计算飞速发展的今天,高效、强大且经济实惠的解决方案变得越来越重要。RunPod Worker Comfy项目应运而生,为开发者和AI爱好者提供了一种创新的方式来利用无服务器计算和AI的力量。本文将深入探讨这个令人兴奋的项目,了解它如何改变我们使用AI图像生成工具的方式。

无缝集成ComfyUI与RunPod

RunPod Worker Comfy是一个开创性的解决方案,旨在简化在RunPod上使用ComfyUI的过程。ComfyUI是AI工作流程中备受推崇的工具,而RunPod则提供了强大的云计算资源。RunPod Worker Comfy巧妙地将这两者结合,允许用户以JSON格式将ComfyUI工作流发送到API,并接收生成的图像,可以是base64编码的字符串或AWS存储桶的URL。这种集成不仅简化了流程,还大大提高了处理各种基于Stable Diffusion的AI图像生成模型的效率。

简化的无服务器架构

该项目极大地简化了集成过程,确保即使是刚接触无服务器架构的用户也能轻松在RunPod上设置和开始使用worker。通过遵循项目提供的全面指南,用户可以充分利用ComfyUI在无服务器环境中的全部潜力。

利用RunPod高效使用高端GPU

RunPod的一个显著特点是能够利用NVIDIA GTX 4080等高端GPU。这一能力确保了ComfyUI-API不仅功能强大,而且经济高效。使用RunPod时,用户只需按秒支付GPU使用费,从而完全控制自己的开支。这种模式特别适合那些需要高计算能力但同时也注重预算的用户。

主要特性

-

多样化的Docker镜像:项目提供了多个预配置的Docker镜像,包括基础版、SDXL版、SD3版等,以满足不同的需求。

-

灵活的输入输出:支持将输入图像作为base64编码字符串提供,生成的图像可以返回为base64编码字符串或上传到AWS S3。

-

自定义模型和节点:用户可以轻松地引入自己的模型和自定义节点,实现更大的灵活性。

-

基于Ubuntu和NVIDIA CUDA:确保了高性能和广泛的兼容性。

快速入门指南

-

选择Docker镜像:根据需求选择适合的预配置镜像,如

timpietruskyblibla/runpod-worker-comfy:3.1.0-sdxl用于Stable Diffusion XL。 -

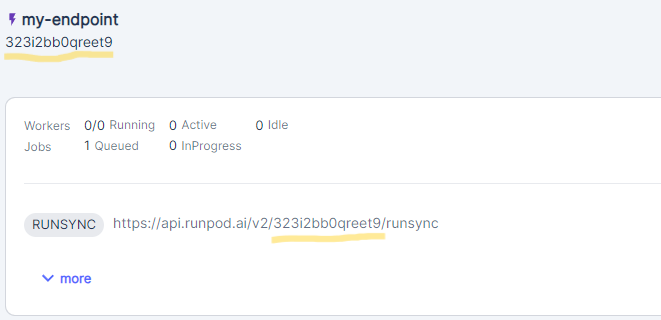

在RunPod上部署:按照指南在RunPod上创建端点并配置环境。

-

API交互:使用提供的API规范发送请求,生成AI图像。

配置和自定义

RunPod Worker Comfy提供了丰富的配置选项,允许用户根据自己的需求进行调整:

- 环境变量:可以设置工作器刷新、轮询间隔等参数。

- AWS S3集成:可选配置,用于将生成的图像上传到S3存储桶。

- 自定义模型和节点:通过网络卷或自定义Docker镜像引入自己的模型和节点。

本地开发和测试

为了方便开发者进行本地测试和调试,项目提供了详细的本地开发指南:

- 环境设置:包括Python环境配置和依赖安装。

- RunPod处理程序测试:可以运行单元测试或启动本地服务器。

- 本地API:模拟RunPod工作器环境,便于本地集成测试。

社区参与和开源贡献

RunPod Worker Comfy是一个开源项目,鼓励社区参与和贡献。开发者可以通过以下方式参与:

- 提交问题和功能请求

- 贡献代码改进

- 分享使用经验和最佳实践

自动化部署

项目利用GitHub Actions实现了自动化部署到Docker Hub的功能,简化了版本管理和发布流程。开发者可以轻松配置自己的CI/CD管道,实现持续集成和部署。

结语

RunPod Worker Comfy代表了AI图像生成工具的未来发展方向。通过将ComfyUI的强大功能与RunPod的高效计算资源相结合,它为开发者和AI爱好者提供了一个灵活、强大且经济的解决方案。无论您是想要探索AI图像生成的可能性,还是需要在生产环境中部署高性能的图像生成服务,RunPod Worker Comfy都是一个值得考虑的选择。

随着项目的不断发展和社区的积极参与,我们可以期待看到更多创新功能和应用场景的出现。现在正是加入这个激动人心的项目、探索AI图像生成新前沿的最佳时机。访问项目GitHub页面,开始您的AI图像生成之旅吧!