项目简介

Segmind 稳定扩散模型 (SSD-1B) 是稳定扩散 XL (SDXL) 缩小 50% 的精简版本,可为模型的运行提供 60% 的提速,同时保持高质量的文本到图像生成功能。它已经过各种数据集的训练,包括 Grit 和 Midjourney scrap 数据,以增强其根据文本提示创建各种视觉内容的能力。

该模型采用知识蒸馏策略,连续利用多个专家模型(包括SDXL、ZavyChromaXL和 JuggernautXL)的教学,结合它们的优势并产生令人印象深刻的视觉输出。

功能特征

- 文本到图像生成: 该模型擅长根据文本提示生成图像,从而实现广泛的创意应用。

- 精炼速度: 该模型专为提高效率而设计,可提供 60% 的加速,使其成为实时应用程序和需要快速生成图像的场景的实用选择。

- 多样化的训练数据: 模型经过多样化的数据集训练,可以处理各种文本提示并有效生成相应的图像。

- 知识蒸馏: 通过从多个专家模型中蒸馏知识,Segmind 稳定扩散模型结合了它们的优点并最大限度地减少了它们的局限性,从而提高了性能。

生图效果对比(SDXL-1.0 与 SSD-1B)

使用方法

- 该模型可以通过 🧨 Diffusers 库使用。

- 确保通过运行从源安装扩散器

pip install git+https://github.com/huggingface/diffusers

- 此外,请安装 transformers、safetensors 和 accelerate:

pip install transformers accelerate safetensors

- 要使用该模型,您可以运行以下命令:

from diffusers import StableDiffusionXLPipeline

import torch

pipe = StableDiffusionXLPipeline.from_pretrained("segmind/SSD-1B", torch_dtype=torch.float16, use_safetensors=True, variant="fp16")

pipe.to("cuda")

# if using torch < 2.0

# pipe.enable_xformers_memory_efficient_attention()

prompt = "An astronaut riding a green horse" # Your prompt here

neg_prompt = "ugly, blurry, poor quality" # Negative prompt here

image = pipe(prompt=prompt, negative_prompt=neg_prompt).images[0]

使用注意

- 此模型现在应该可以在 ComfyUI 中使用。

- 请务必添加负面提示词和 权重9.0 左右的 CFG 以获得最佳质量的图片!

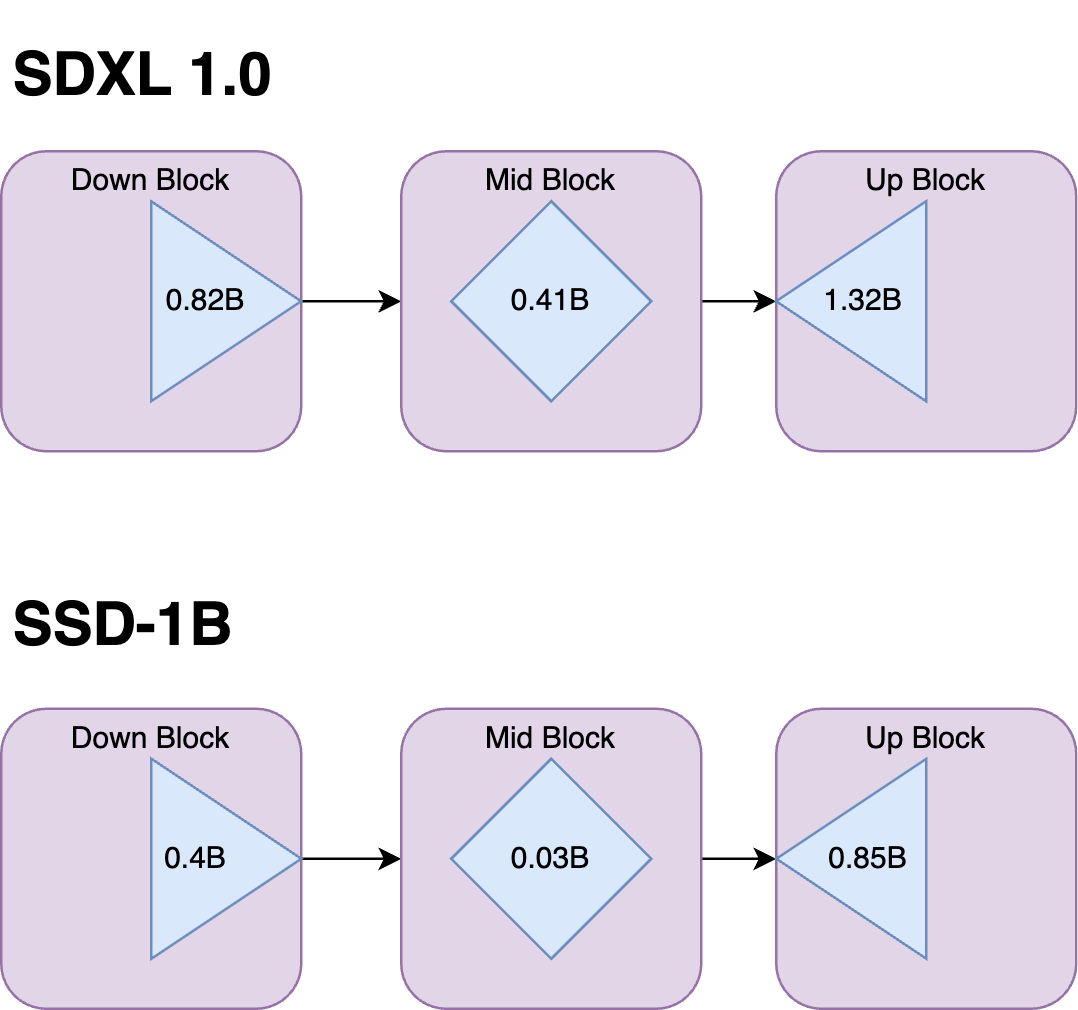

模型架构

SSD-1B 模型是 1.3B 参数模型,从基本 SDXL 模型中删除了多个层

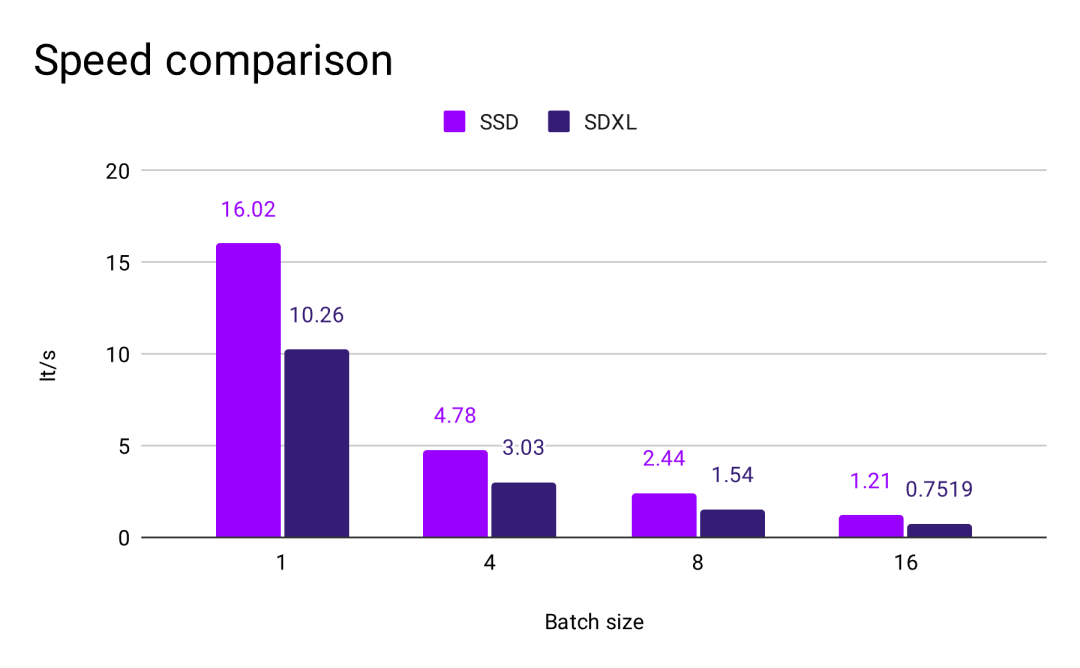

速度对比

经过测试,观察到 SSD-1B 比 Base SDXL 快 60%,以下是使用 A100 80GB 显卡的比较

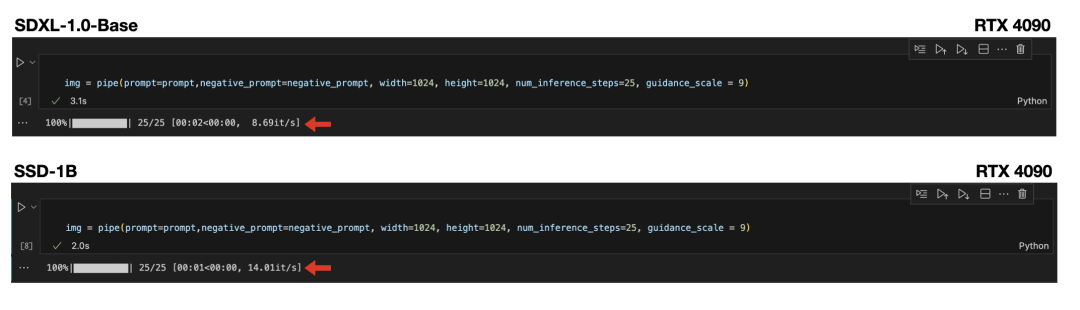

以下是 RTX 4090 GPU 的加速指标

适用领域

Segmind 稳定扩散模型适用于各个领域的研究和实际应用,包括:

- 艺术与设计: 它可用于生成艺术品、设计和其他创意内容,提供灵感并增强创意过程。

- 教育: 该模型可应用于教育工具,以创建用于教学和学习目的的视觉内容。

- 研究: 研究人员可以使用该模型来探索生成模型,评估其性能,并突破文本到图像生成的界限。

- 安全内容生成: 它提供了一种安全且受控的内容生成方式,降低了有害或不当输出的风险。

- 偏差和局限性分析: 研究人员和开发人员可以使用该模型来探究其局限性和偏差,从而有助于更好地理解生成模型的行为。